1 引 言

2 材料与方法

2.1 数据采集与特征标注

2.1.1 供试图像数据库与样本组织

表 1 模型样本量和采样方法表Table 1 Information of sample size and sampling method |

| 物种名(均为成虫) | 图片总数目/幅 | 训练集数目(80%)/幅 | 训练集平衡采样策略 |

|---|---|---|---|

| 草地贪夜蛾(雄虫) | 850 | 680 | 680 + 120的过采样 |

| 棉铃虫 | 1438 | 1150 | 800的欠采样 |

| 甜菜夜蛾 | 731 | 585 | 585 + 215的过采样 |

| 斜纹夜蛾 | 2282 | 1826 | 800的欠采样 |

| 粘虫 | 2523 | 2019 | 800的欠采样 |

| 小地老虎 | 1976 | 1581 | 800的欠采样 |

| 黄地老虎 | 377 | 302 | 302 + 498的过采样 |

|

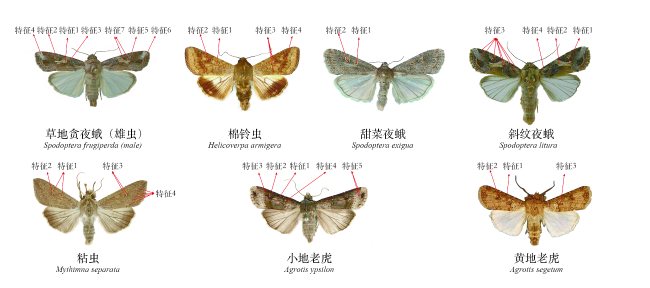

2.1.2 7种夜蛾科成虫图像关键视觉特征标注

表2 7种夜蛾科成虫主要的视觉特征Table 2 Key visual characteristics of 7 species of noctuid moths |

| 物种 | 视觉特征 |

|---|---|

| 草地贪夜蛾(雄虫) | 特征1:环形纹黄褐色,边缘内侧较浅,外侧为黑色至黑褐色; 特征2:肾形纹明显,颜色灰褐色; 特征3:环形纹上方有一个黑褐色至黑色斑纹; 特征4:前翅顶角处有一个较大白色斑纹; 特征5:肾形纹靠前缘脉一侧有一个白斑; 特征6:亚端线白色; 特征7:肾形纹靠臀脉侧白斑可与环形纹相连,渐变为黄褐色 |

| 棉铃虫 | 特征1:前翅中横线有肾形纹,边褐色,中央深褐色斑; 特征2:环形纹褐边,中央有一个褐色点; 特征3:中横线由肾形纹内侧斜至后缘,末端达环形纹的正下方; 特征4:亚端线的锯齿纹较均匀,距外缘的宽度大致相等。 |

| 甜菜夜蛾 | 特征1:前翅中央近前缘外方有一个肾形斑; 特征2:内方有一个环形斑 |

| 斜纹夜蛾 | 特征1:前翅翅基部前半部有白线条数条,内、外横线之间有灰白色宽带,自内横线前缘斜伸至外横线近内缘1/3处; 特征2:灰白色宽带中有2条褐色线纹(雄蛾不显著); 特征3:复杂的黑褐色斑纹; 特征4:翅基部前半部有白线数条 |

| 粘虫 | 特征1:前翅中央近前缘处有2个淡黄色圆斑; 特征2:外方圆斑下有一个小白点; 特征3:外方圆斑两侧各有一小黑点; 特征4:前翅顶角有一条向后缘的黑色斜纹 |

| 小地老虎 | 特征1:前翅环形纹黑色,有一个圆灰环; 特征2:肾形纹黑色黑边; 特征3:肾形纹外方有一个黑色楔形黑斑; 特征4:黑边楔状纹; 特征5:亚外缘线上有2个尖端向内的楔形黑斑 |

| 黄地老虎 | 特征1:前翅环形纹暗褐色黑边,圆形或微呈椭圆形; 特征2:肾形纹棕褐色黑边,较大; 特征3:清晰黑边楔状纹 |

2.2 深度学习模型训练实验设计

表3 模型训练策略及超参数设置Table 3 Model training strategy and hyper-parameters settings |

| 序号 | 训练策略或超参数 | 设置 |

|---|---|---|

| 1 | 优化器类型 | 随机梯度下降(Stochastic Gradient Descent) |

| 2 | 学习率调整策略 | 带热重启的随机梯度下降(Stochastic Gradient Descent with Warm Restart)[19,20],基本周期为1,倍率为2,每个周期开始时学习率为基础学习率,结束后学习率降为0 |

| 3 | 学习率退火方式 | 余弦退火(Cosine Annealing)[21] |

| 4 | 基础学习率 | 0.01 |

| 5 | 动量因子 | 0.9 |

| 6 | 权重衰减 | 0.0005 |

| 7 | 批大小 | 32 |

| 8 | 训练集数据增强策略 | 维持图片宽高比,最短边调整为224像素;中心裁剪224×224像素图像块;随机水平翻转;随机垂直翻转;随机平移;随机旋转;像素值按照ImageNet数据集进行归一化 |

| 9 | 总训练周期数 | 200 |

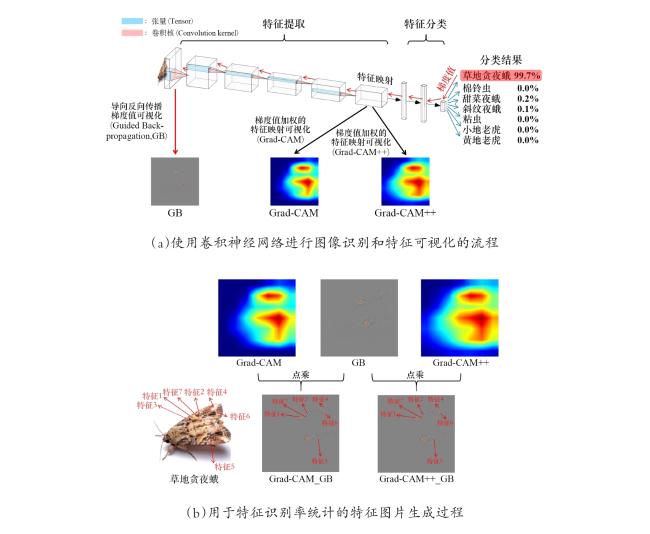

2.3 特征可视化技术选择

2.4 夜蛾科成虫识别和特征可视化

3 结果与分析

表4 不同卷积神经网络模型训练实验结果Table 4 Experimental results of different CNN models |

| 模型结构 | 平衡采样 | 数据增强 | 每类测试样本数 (共7类) | 准确率/% | epochth (总数200) |

|---|---|---|---|---|---|

| VGG-16 | 38 | 98.46 | 108 | ||

| √ | 99.22 | 104 | |||

| √ | 98.07 | 116 | |||

| √ | √ | 99.61 | 99 | ||

| ResNet-50 | 99.22 | 50 | |||

| √ | 99.61 | 103 | |||

| √ | 98.45 | 91 | |||

| √ | √ | 99.61 | 116 | ||

| DenseNet-121 | 99.22 | 116 | |||

| √ | 99.22 | 110 | |||

| √ | 98.45 | 96 | |||

| √ | √ | 99.22 | 64 |

3.1 数据增强和采样策略对夜蛾识别率的影响

3.2 形态特征可视化分析

表5 不同卷积神经网络模型对夜蛾科成虫关键特征识别率的比较Table 5 The comparison of noctuid moths key feature recognition rate of different CNN models |

| 物种 | 特征索引 | 有效样本数/总样本数 | 特征识别率/% | |||||

|---|---|---|---|---|---|---|---|---|

| DenseNet-121 | ResNet-50 | VGG-16 | ||||||

| 平衡采样 | 随机洗牌 | 平衡采样 | 随机洗牌 | 平衡采样 | 随机洗牌 | |||

| 草地贪夜蛾(雄虫) | 1 | 30/30 | 95.0 | 96.7 | 91.7 | 95.0 | 93.3 | 86.7 |

| 2 | 16/30 | 87.5 | 87.5 | 84.4 | 90.6 | 37.5 | 40.6 | |

| 3 | 20/30 | 77.5 | 75.0 | 67.5 | 60.0 | 10.0 | 10.0 | |

| 4 | 26/30 | 30.8 | 23.1 | 40.4 | 42.3 | 3.9 | 0.0 | |

| 5 | 27/30 | 81.5 | 85.2 | 85.2 | 90.7 | 44.4 | 59.3 | |

| 6 | 24/30 | 52.1 | 64.6 | 75.0 | 75.0 | 8.3 | 8.3 | |

| 7 | 29/30 | 96.6 | 96.6 | 100.0 | 98.3 | 65.5 | 63.8 | |

| 棉铃虫 | 1 | 27/30 | 98.2 | 100.0 | 100.0 | 100.0 | 77.8 | 83.3 |

| 2 | 24/30 | 97.9 | 100.0 | 95.8 | 93.8 | 68.8 | 87.5 | |

| 3 | 16/30 | 87.5 | 84.4 | 75.0 | 81.3 | 15.6 | 34.4 | |

| 4 | 20/30 | 22.5 | 52.5 | 47.5 | 80.0 | 12.5 | 32.5 | |

| 甜菜夜蛾 | 1 | 29/30 | 89.7 | 86.2 | 94.8 | 87.9 | 13.8 | 25.9 |

| 2 | 30/30 | 91.7 | 93.3 | 93.3 | 100.0 | 68.3 | 86.7 | |

| 斜纹夜蛾 | 1 | 30/30 | 100.0 | 100.0 | 100.0 | 100.0 | 96.7 | 98.3 |

| 2 | 18/30 | 100.0 | 100.0 | 100.0 | 100.0 | 86.1 | 83.3 | |

| 3 | 30/30 | 100.0 | 100.0 | 98.3 | 100.0 | 26.7 | 41.7 | |

| 4 | 23/30 | 67.4 | 73.9 | 67.4 | 76.1 | 32.6 | 28.3 | |

| 粘虫 | 1 | 4/30 | 75.0 | 75.0 | 50.0 | 75.0 | 50.0 | 0.0 |

| 2 | 30/30 | 95.0 | 98.3 | 95.0 | 95.0 | 86.7 | 96.7 | |

| 3 | 28/30 | 98.2 | 100.0 | 96.4 | 96.4 | 83.9 | 100.0 | |

| 4 | 17/30 | 73.5 | 55.9 | 58.8 | 55.9 | 38.2 | 23.5 | |

| 小地老虎 | 1 | 15/30 | 90.0 | 80.0 | 86.7 | 56.7 | 43.3 | 46.7 |

| 2 | 27/30 | 100.0 | 96.3 | 96.3 | 85.2 | 90.7 | 85.2 | |

| 3 | 30/30 | 100.0 | 100.0 | 100.0 | 95.0 | 98.3 | 100.0 | |

| 4 | 27/30 | 90.7 | 88.9 | 87.0 | 74.1 | 59.3 | 64.8 | |

| 5 | 24/30 | 95.8 | 95.8 | 93.8 | 95.8 | 31.3 | 54.2 | |

| 黄地老虎 | 1 | 25/28 | 80.0 | 74.0 | 74.0 | 68.0 | 64.0 | 58.0 |

| 2 | 26/28 | 92.3 | 96.2 | 92.3 | 94.2 | 80.8 | 84.6 | |

| 3 | 27/28 | 98.2 | 100.0 | 96.3 | 98.2 | 72.2 | 85.2 | |

| 特征识别率平均值/% | 85.0 | 85.5 | 84.2 | 84.8 | 53.8 | 57.6 | ||