1 引 言

2 设备与方法

2.1 移动机器人平台

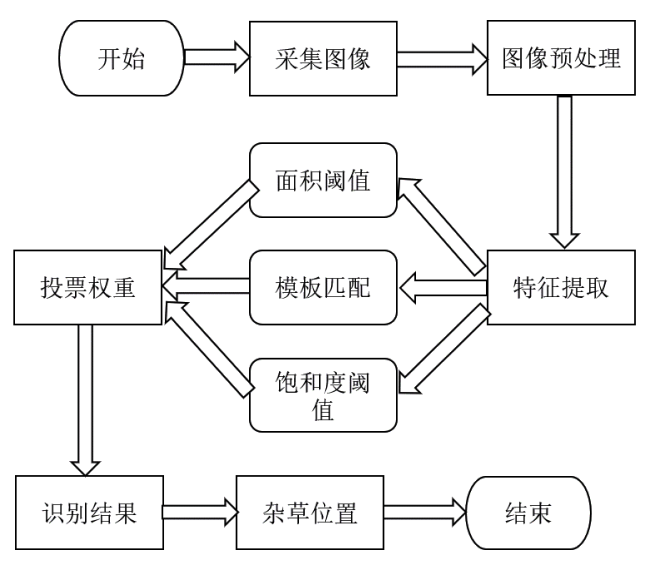

2.2 杂草识别与定位算法

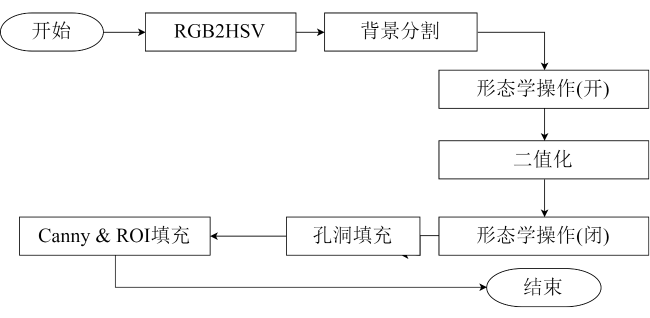

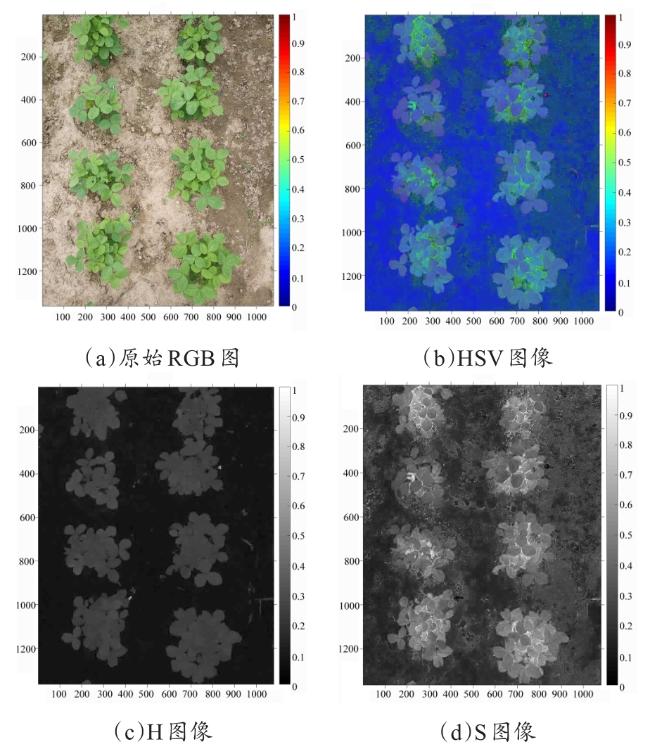

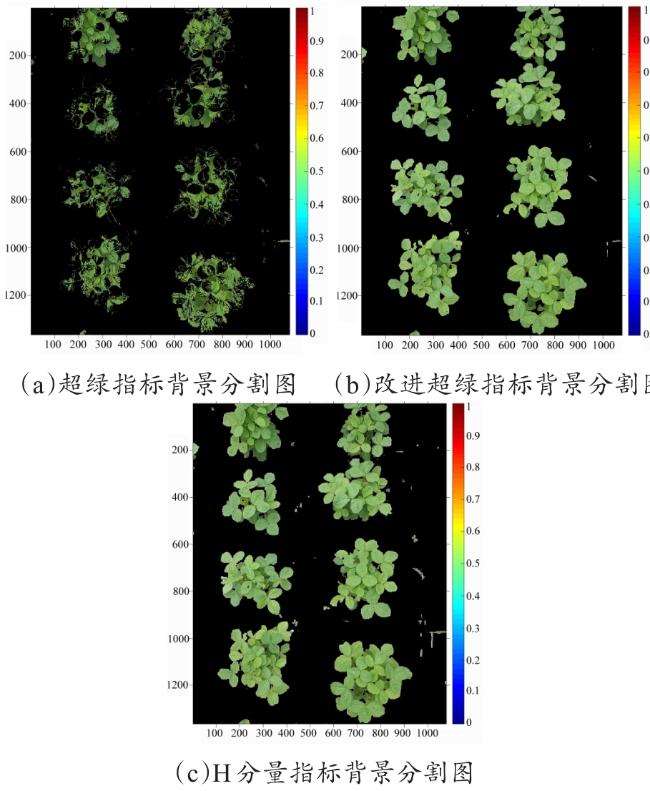

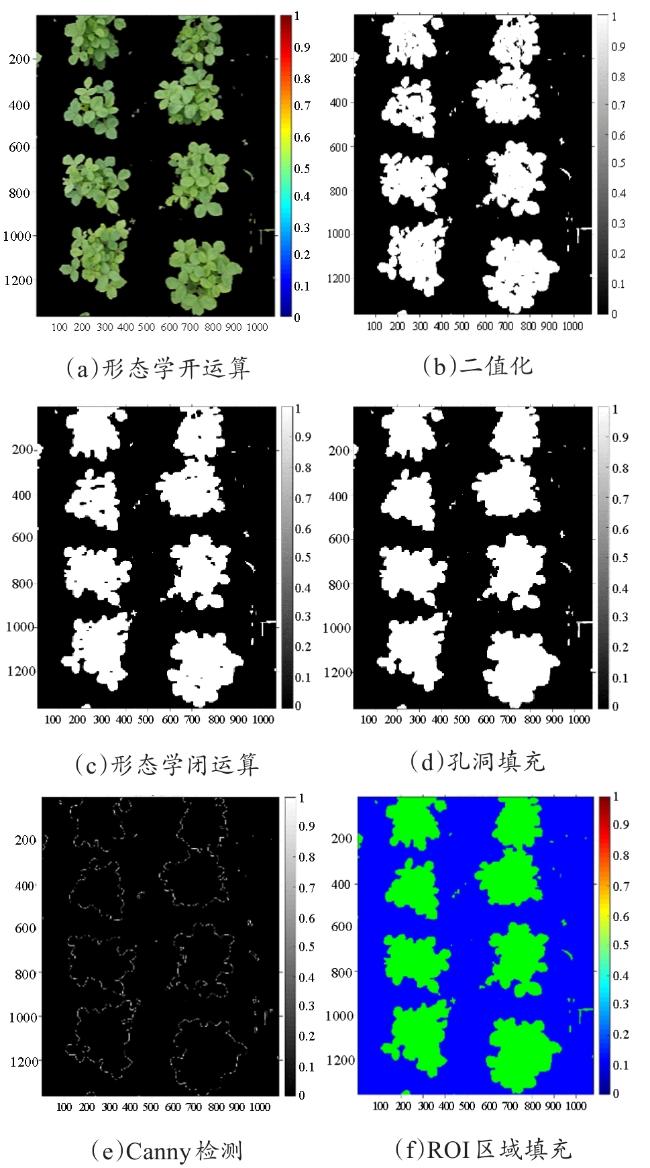

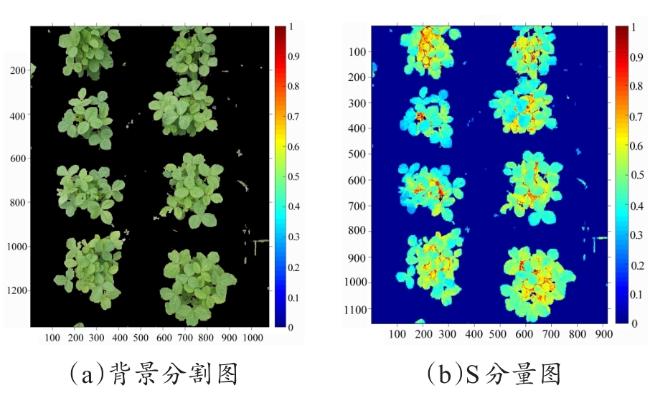

2.2.1 图像预处理

2.2.2 基于特征的检测

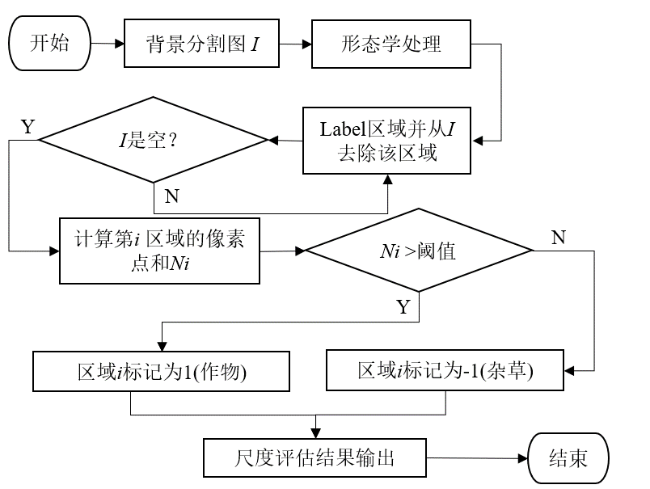

表1 面积评估中的标签分配Table 1 Label allocation in area assessment |

| 类型 | 阈值 | 标签 |

|---|---|---|

| 杂草 | && | 1 |

| 作物 | -1 | |

| 土壤 | —— | 0 |

表3 饱和度阈值标签分配Table 3 Label Assignment of saturation threshold |

| 类型 | 阈值 | 标签 |

|---|---|---|

| 杂草 | 1 | |

| 作物 | -1 | |

| 土壤 | —— | 0 |

2.3 杂草识别与定位

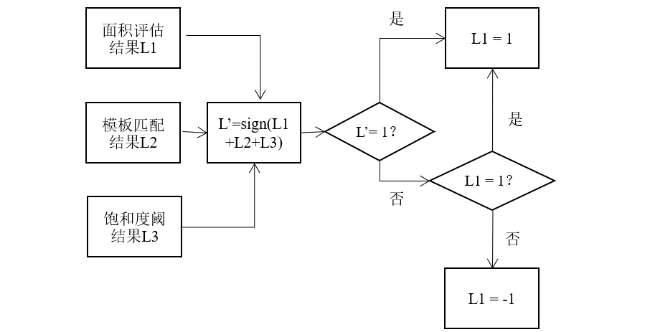

2.3.1 杂草检测投票算法

2.3.2 杂草定位算法

3 结果与分析

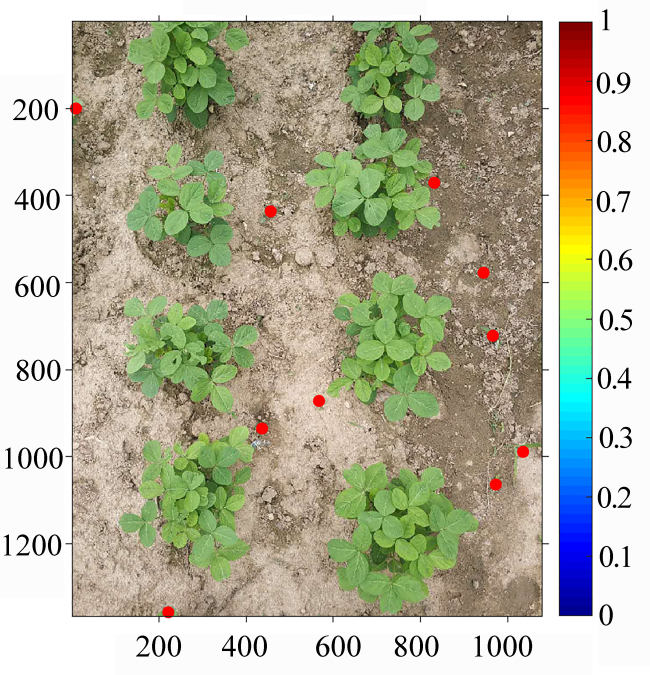

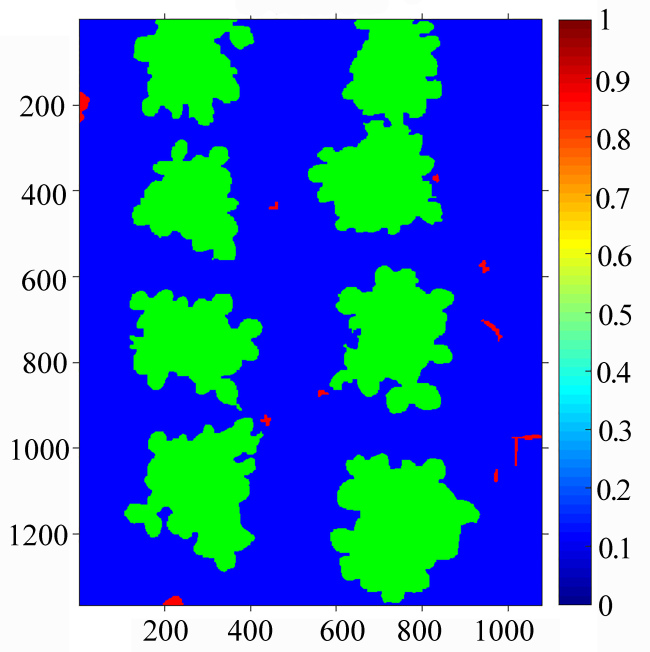

3.1 杂草识别结果

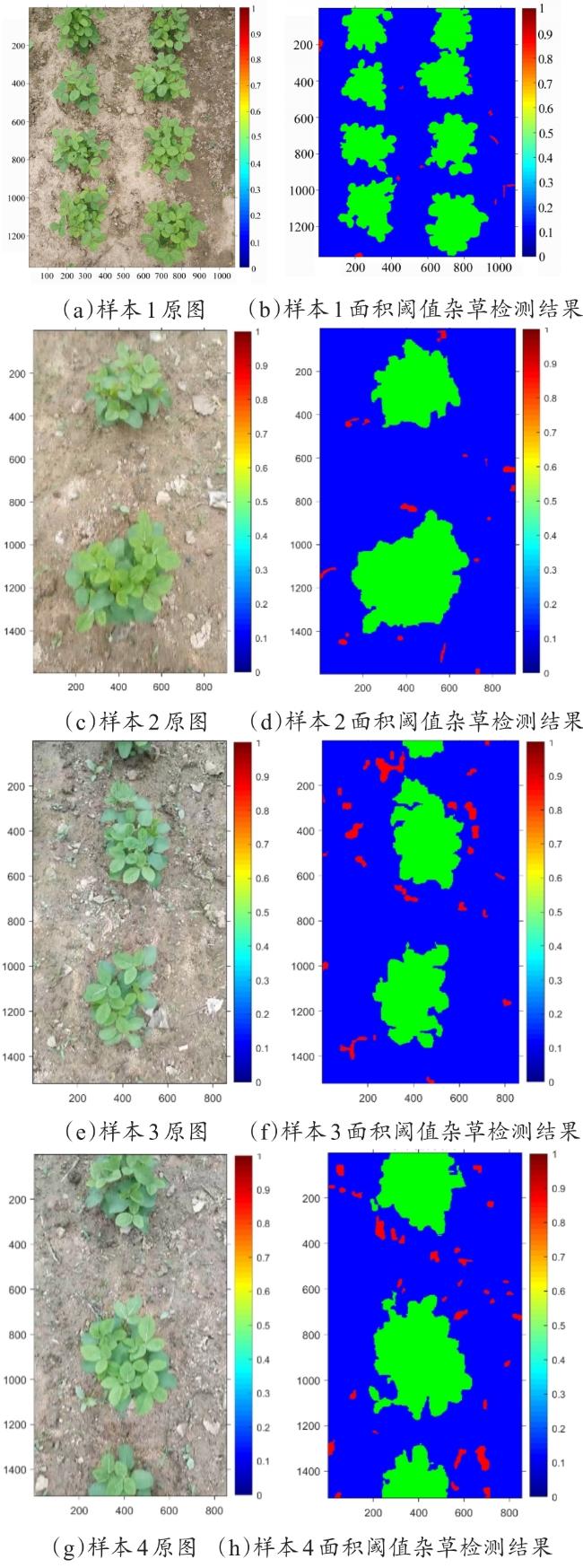

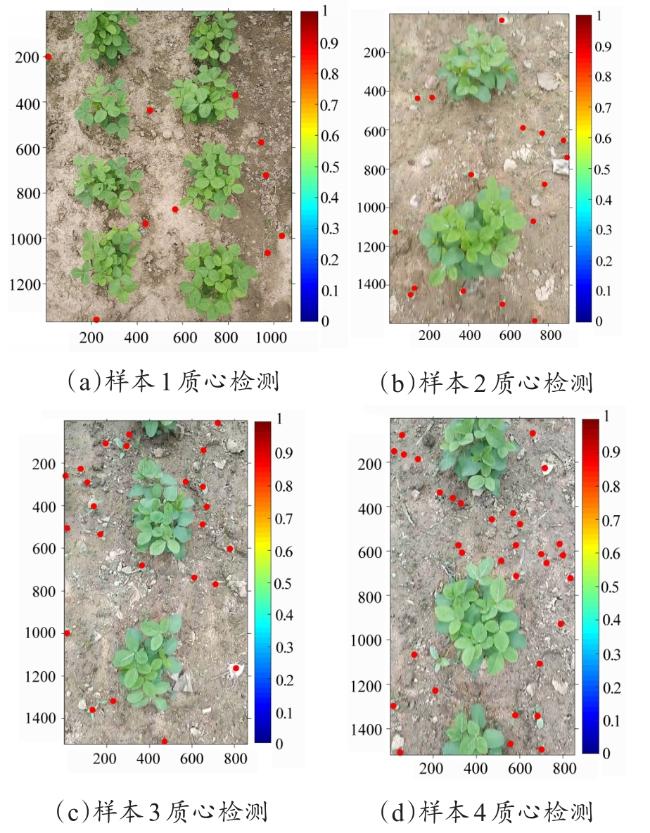

3.1.1 面积特征检测结果

图13 样本1~4面积阈值法杂草检测结果Fig. 13 Weed detection results of Sample 1-4 using area threshold method |

表5 样本1~4面积评估检测精度Table 5 Detection accuracy of scale evaluation in Sample 1-4 |

| 样本 | N | / % | / % | / % | A / % | ||||

|---|---|---|---|---|---|---|---|---|---|

| 1 | 1 | 4 | 10 | 33 | 43 | 10.00 | 9.30 | 11.62 | 88.38 |

| 2 | 0 | 1 | 2 | 19 | 21 | 0.00 | 5.26 | 4.76 | 95.23 |

| 3 | 0 | 2 | 3 | 37 | 40 | 0.00 | 5.41 | 5.00 | 95.00 |

| 4 | 0 | 4 | 3 | 40 | 43 | 0.00 | 10.00 | 9.30 | 90.70 |

| 全部 | — | — | — | — | — | 2.50 | 7.49 | 7.67 | 92.33 |

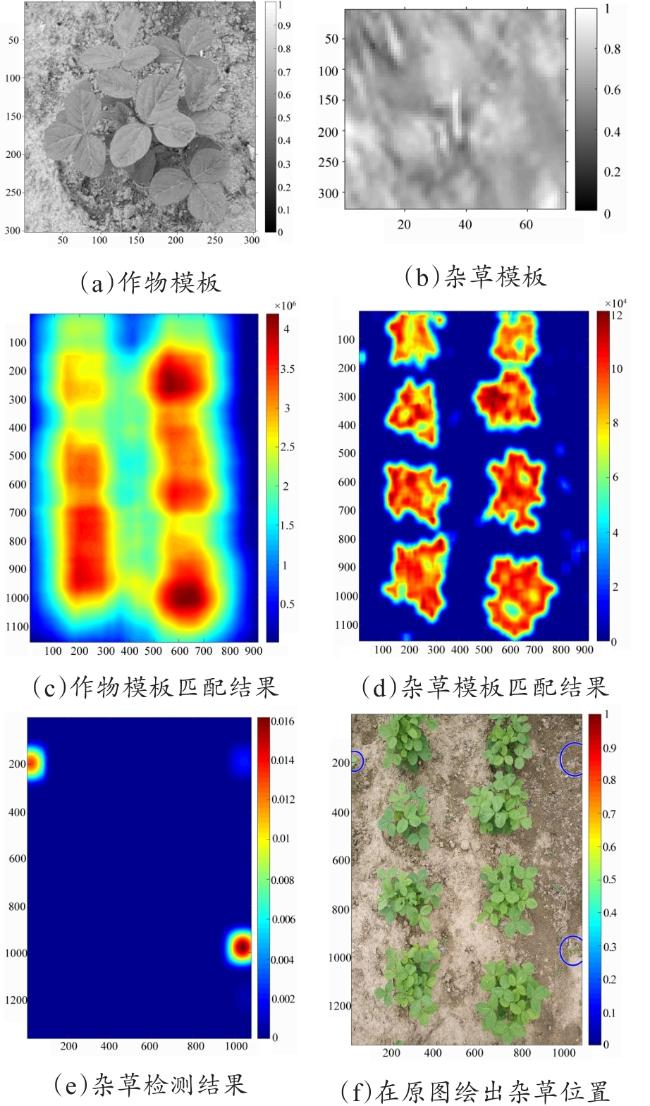

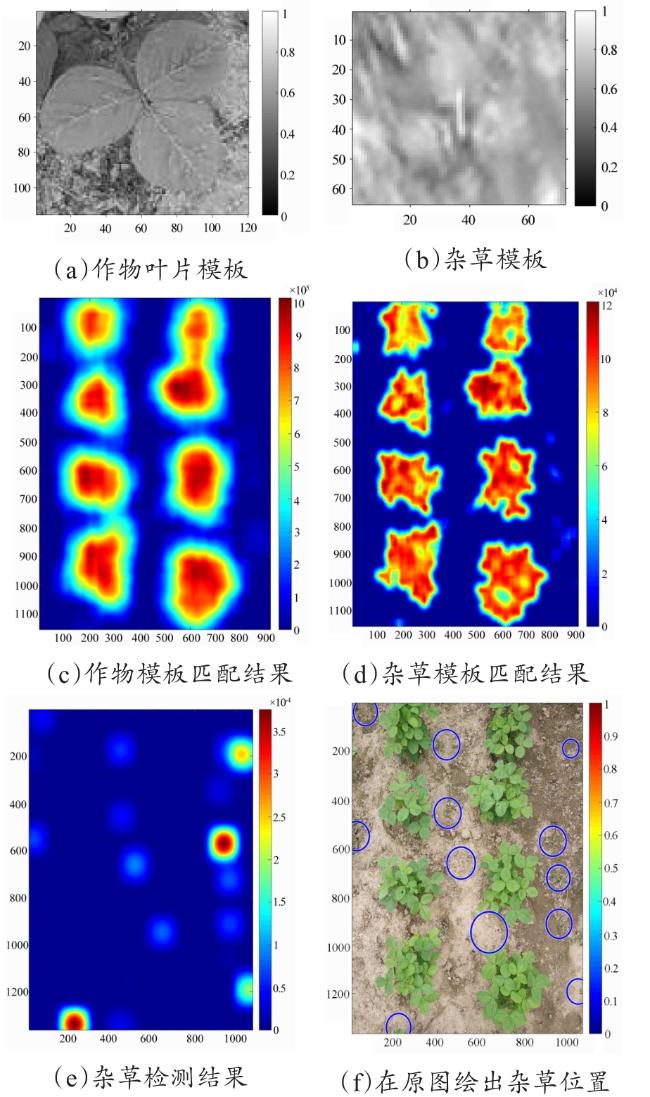

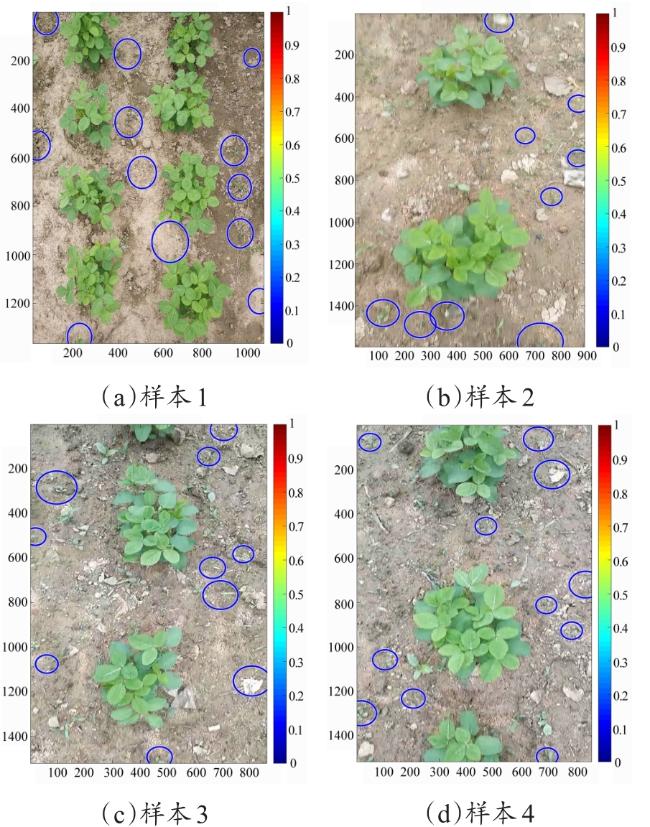

3.1.2 模板匹配算法

表6 样本1~4模板匹配检测精度Table 6 Detection accuracy of template matching in Sample 1-4 |

| 样本 | N | / % | / % | / % | A/% | ||||

|---|---|---|---|---|---|---|---|---|---|

| 1 | 0 | 3 | 10 | 33 | 43 | 0 | 9.09 | 6.98 | 93.02 |

| 2 | 0 | 2 | 2 | 19 | 21 | 0 | 10.53 | 9.52 | 90.48 |

| 3 | 0 | 3 | 3 | 37 | 40 | 0 | 8.11 | 7.50 | 92.50 |

| 4 | 0 | 4 | 3 | 40 | 43 | 0 | 10.00 | 9.30 | 90.70 |

| 全部 | — | — | — | — | — | 0 | 9.43 | 6.58 | 93.46 |

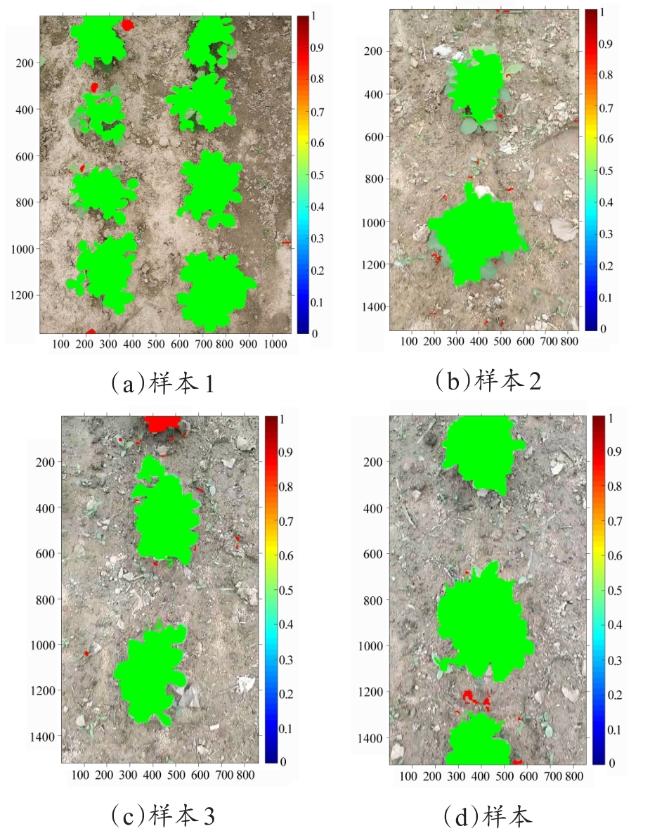

3.1.3 基于饱和度阈值特征检测结果

表7 样本1~4饱和度阈值特征检测精度Table 7 Detection accuracy of Sample 1-4 using saturation threshold characteristic |

| 样本 | N | % | / % | / % | A / % | ||||

|---|---|---|---|---|---|---|---|---|---|

| 1 | 4 | 0 | 10 | 33 | 43 | 40.00 | 0.00 | 9.30 | 90.70 |

| 2 | 3 | 0 | 2 | 19 | 21 | 150.00 | 15.79 | 14.29 | 85.71 |

| 3 | 1 | 1 | 3 | 37 | 40 | 33.33 | 27.03 | 2.50 | 97.50 |

| 4 | 2 | 1 | 3 | 40 | 43 | 66.67 | 25.00 | 6.98 | 93.02 |

| 全部 | — | — | — | — | — | 72.50 | 19.31 | 8.25 | 91.76 |

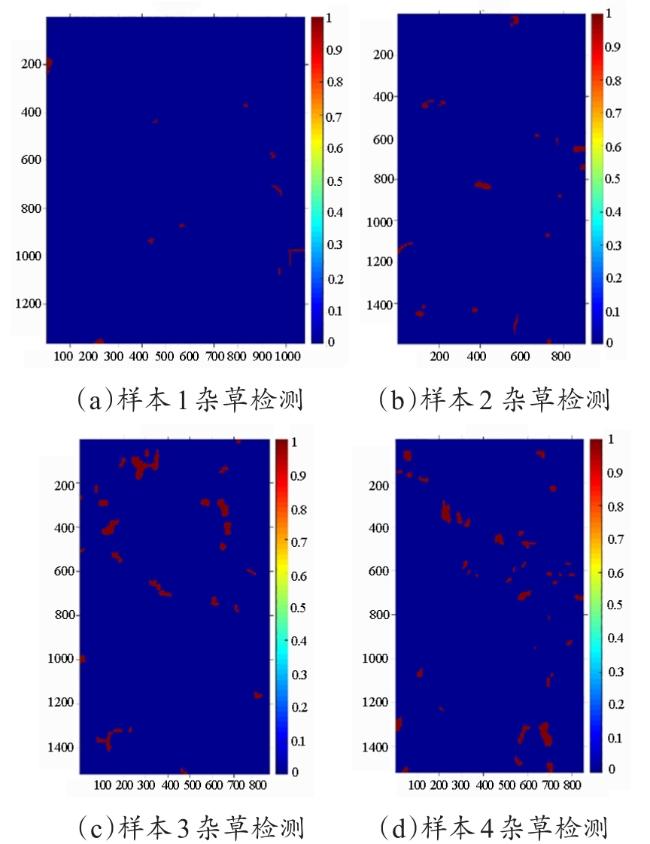

3.2 投票算法杂草检测结果

表8 杂草投票权重算法样本1~4的检测精度Table 8 Detection accuracy of weed voting algorithm in Sample 1-4 |

| 样本 | N | / % | / % | / % | A / % | ||||

|---|---|---|---|---|---|---|---|---|---|

| 1 | 1 | 0 | 10 | 33 | 43 | 10.00 | 0.00 | 2.33 | 97.67 |

| 2 | 0 | 0 | 2 | 19 | 21 | 0.00 | 0.00 | 0.00 | 100.00 |

| 3 | 0 | 1 | 3 | 37 | 40 | 0.00 | 27.03 | 2.50 | 97.50 |

| 4 | 0 | 1 | 3 | 40 | 43 | 0.00 | 25.00 | 2.33 | 96.35 |

| 全部 | — | — | — | — | — | 2.50 | 13.01 | 1.79 | 98.21 |

表9 四种算法杂草检测结果精度对比Table 9 Comparison of detection accuracy of four weed detection calculations |

| 样本 | / % | / % | / % | A / % |

|---|---|---|---|---|

| 面积阈值 | 2.50 | 7.49 | 7.670 | 92.330 |

| 模板匹配 | 0.00 | 9.43 | 6.575 | 93.425 |

| 饱和度阈值 | 72.50 | 19.31 | 8.245 | 91.755 |

| 本文算法 | 2.50 | 13.01 | 1.790 | 98.210 |