1 引 言

2 数据集构建

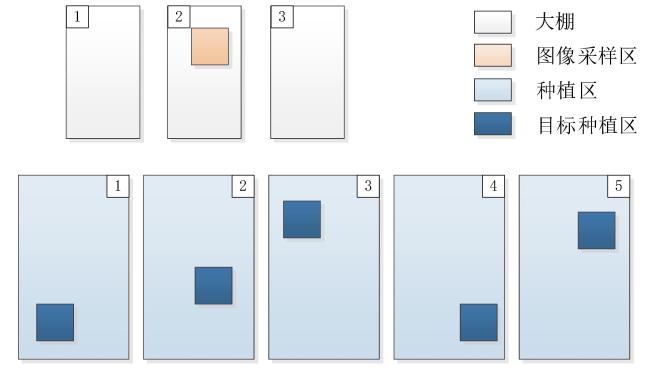

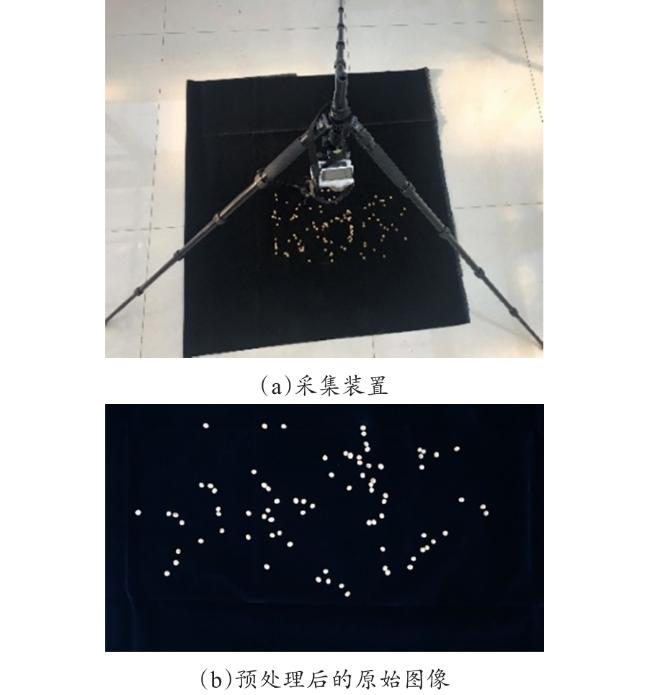

2.1 数据采集

2.2 数据标注

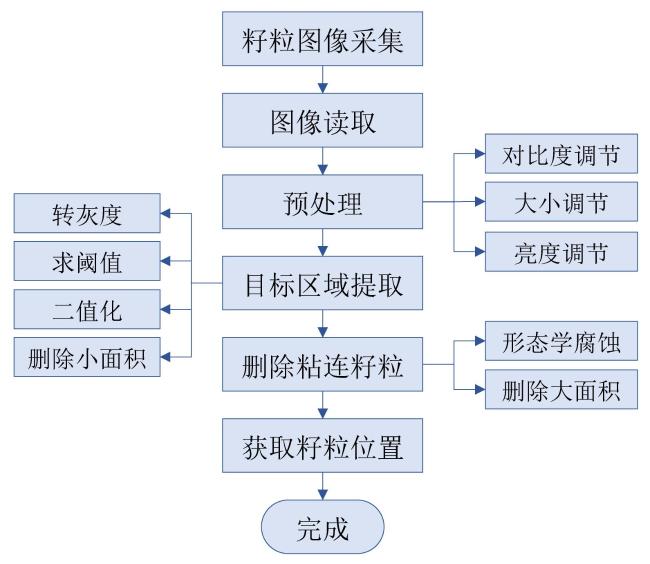

2.2.1 大豆籽粒预标注

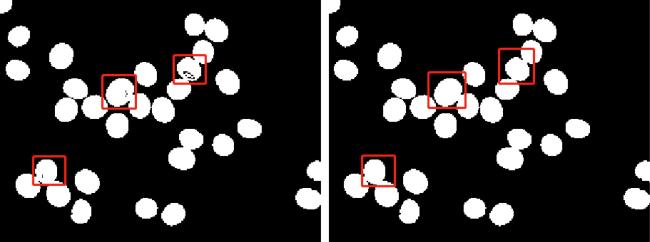

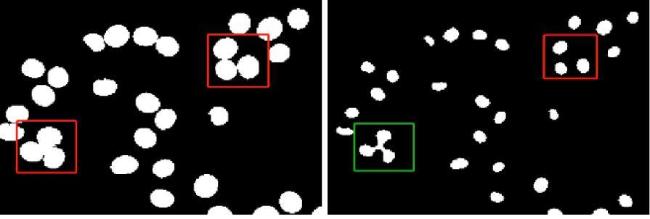

图 5 形态学腐蚀操作处理籽粒粘连(a)籽粒粘连 (b)形态学腐蚀操作 Fig. 5 Morphological corrosion treatment of adhesive seeds |

图6 删除粘连籽粒预标注前后的示意图(a)粘连籽粒的错误预标注 (b)删除错标结果 Fig. 6 Annotation diagram before and after deleting pre-labeling of adhesive seeds |

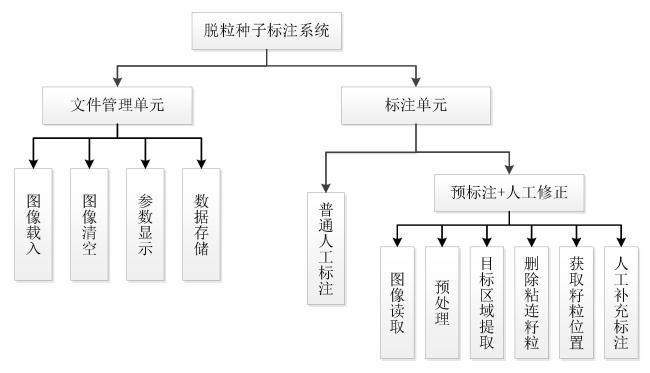

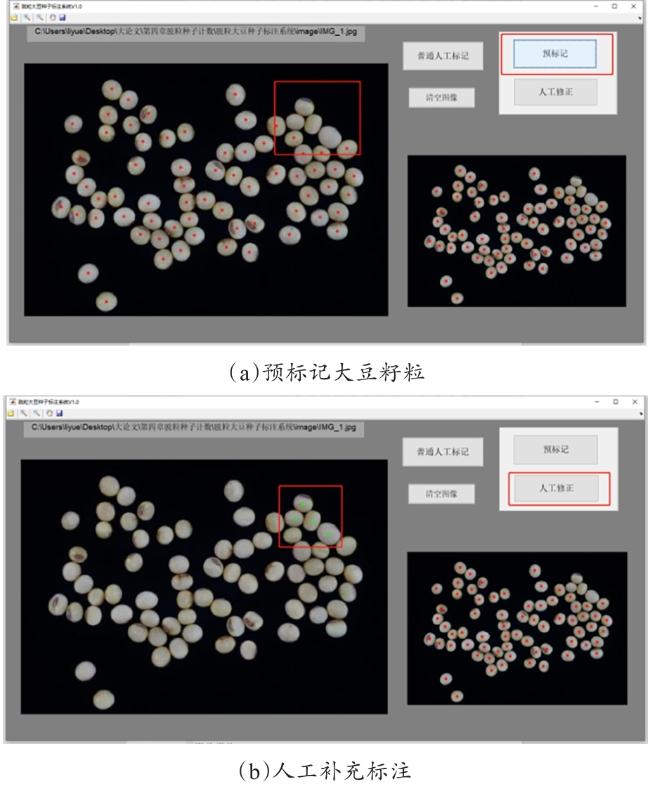

2.2.2 大豆籽粒标注系统

2.3 数据增强

2.4 数据集建立

表 1 大豆籽粒图像数据集Table 1 Soybean seed image dataset |

| 数据集 | 数量/张 | 籽粒数/个 | 最少籽粒数/个 | 最多籽粒数/个 | 平均籽粒数/个 |

|---|---|---|---|---|---|

| 训练集 | 206 | 22,582 | 67 | 201 | 109 |

| 验证集 | 33 | 3631 | 70 | 200 | 110 |

| 测试集 | 103 | 11,350 | 70 | 200 | 110 |

| 总数 | 342 | 37,563 | 67 | 201 | 109 |

3 研究方法

3.1 基于密度图的籽粒计数

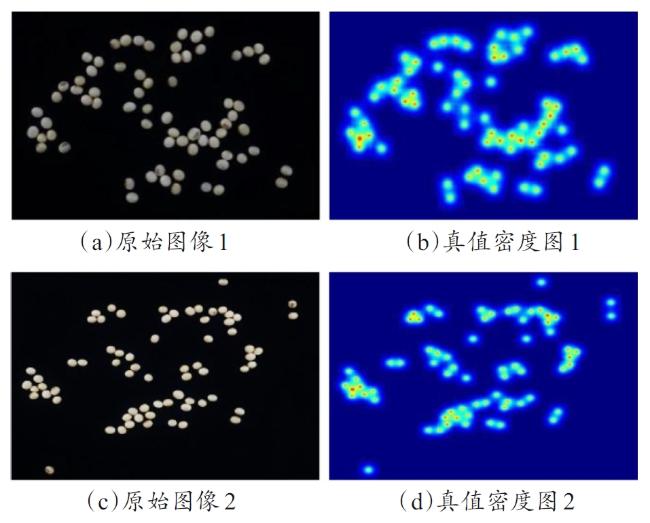

3.2 真值密度图

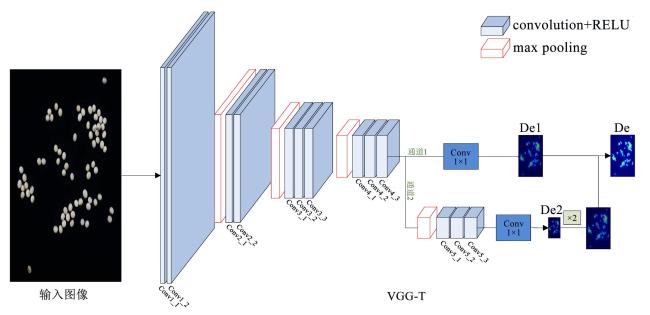

3.3 VGG-T网络架构

表2 VGG-T与VGG网络结构对比Table 2 Network structure comparison of VGG-T and VGG |

| 1 | 2 | |

3.4 损失函数计算

3.5 评估指标

4 试验与结果分析

4.1 有无数据增强计数对比

表3 VGG-T在有无数据增强下的试验结果Table 3 Test results of VGG-T with/without data enhancement |

| 模型 | Patch | MAE/(粒·图-1) | MSE/(粒2·图-1) |

|---|---|---|---|

| VGG-T | 无 | 0.6 | 0.6 |

| 有 | 0.2 | 0.3 |

4.2 不同计数方法对比

表 4 5种方法的计数性能对比Table 4 Comparison on the count performance of five methods |

| Method | Patch | MAE/(粒·图-1) | MSE/(粒2·图-1) |

|---|---|---|---|

| 传统形态学操作 | 无 | 4.36 | 7.17 |

| ResNet18 | 无 | 2.1 | 2.4 |

| 有 | 0.7 | 0.8 | |

| VGG16 | 无 | 2.2 | 2.9 |

| 有 | 0.4 | 0.6 | |

| ResNet18-T | 无 | 0.7 | 0.8 |

| 有 | 0.2 | 0.3 | |

| VGG-T | 无 | 0.6 | 0.6 |

| 有 | 0.2 | 0.3 |

4.3 不同测试集计数对比

表5 不同测试集的试验结果Table 5 Results of different test sets |

| 组别 | MAE/ (粒·图-1) | MSE/ (粒2·图-1) | 真值种子 数/粒 | 估值种子 数/粒 |

|---|---|---|---|---|

| 组1 | 0.46 | 0.53 | 71 | 71 |

| 组2 | 0.50 | 0.59 | 80 | 79 |

| 组3 | 0.61 | 0.57 | 90 | 90 |

| 组4 | 0.58 | 0.52 | 100 | 101 |

| 组5 | 0.63 | 0.55 | 110 | 109 |

| 组6 | 0.68 | 0.65 | 120 | 118 |

| 组7 | 0.73 | 0.63 | 200 | 199 |

4.4 时间成本

表6 11,350粒大豆籽粒计数时间成本对比Table 6 Cost comparison of 11,350 soybean seed counting time |

| 指标 | 人工计数 | 光电种子数粒仪 | VGG-T |

|---|---|---|---|

| 效率/(粒·s-1) | 1.25 | 5.56 | 116.690 |

| 总耗时/h |