传统的高光谱图像分割方法主要包含距离分类器(Distance Classifier, DC)、K近邻分类器(K-Nearest Neighbor, KNN)、最大似然分类器(Maximum Likelihood Classification, MLC)和逻辑回归(Logistic Regression, LR)等

[8, 9]。但这些方法大多都会受到Hughes现象的影响(当训练数据有限时,随着模型特征维数的增加,分类的精度会出现先增后降)

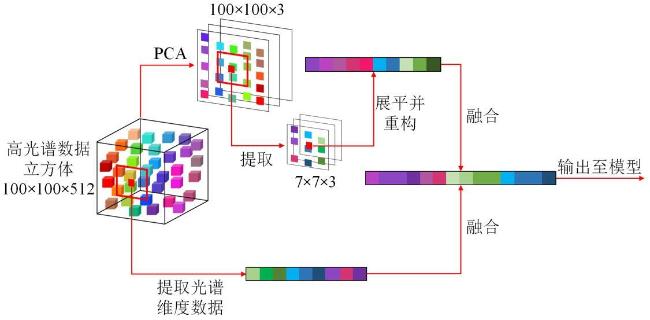

[10]。针对这一问题,研究者们提出了相关的特征提取方法和判别学习方法。其中,特征提取法主要是将高维数据映射到低维空间,同时保留类别信息。典型的特征提取方法有主成分分析(Principal Component Analysis, PCA)、独立成分分析(Independent Component Analysis, ICA)、线性判别分析(Linear Discriminant Analysis, LDA)等。判别学习法则包括:支持向量机(Support Vector Machines, SVM)、多类别逻辑回归(Multinomial Logistics Regression, MLR)、人工免疫网络(Artificial Immune Network, AIN)等

[11-13]。该类方法主要是通过学习得到高维空间中数据与类别之间的映射关系。近年来,除了谱维度数据以外,高光谱图像分割方法也开始引入空间信息,从而利用融合的空-谱信息来表征对象

[14]。空-谱信息的融合显著提高了高光谱图像的识别与分割精度,但也进一步增加了数据量。如何从海量的数据中高效且准确地提取特征,同时充分挖掘空间数据和光谱数据所包含的潜在信息,一直是该研究的难点与热点

[15]。