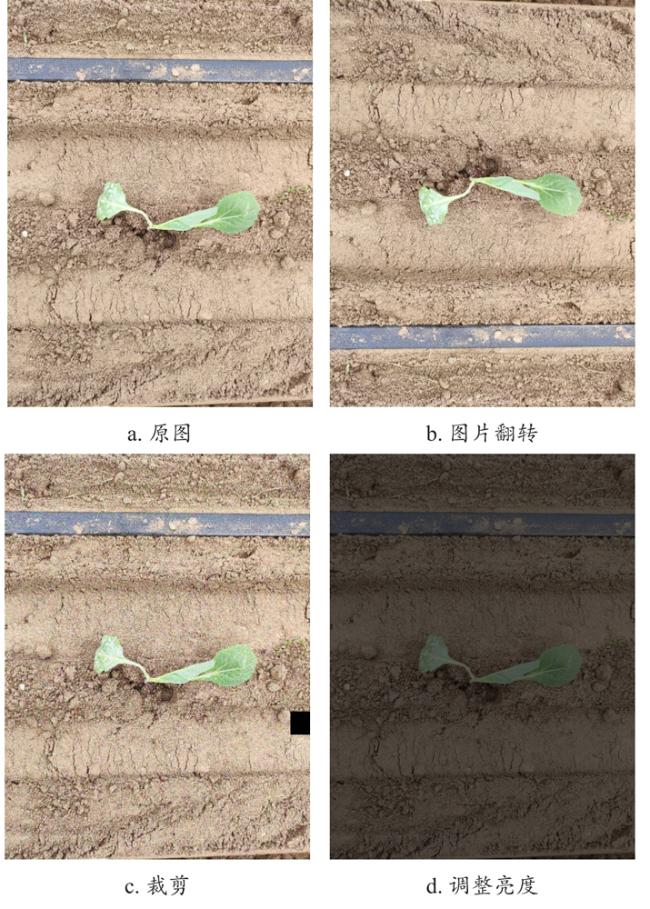

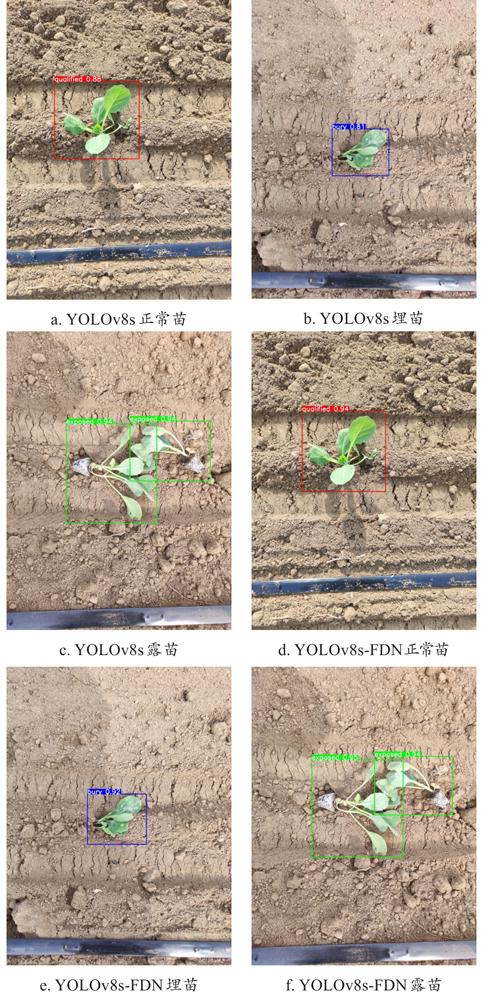

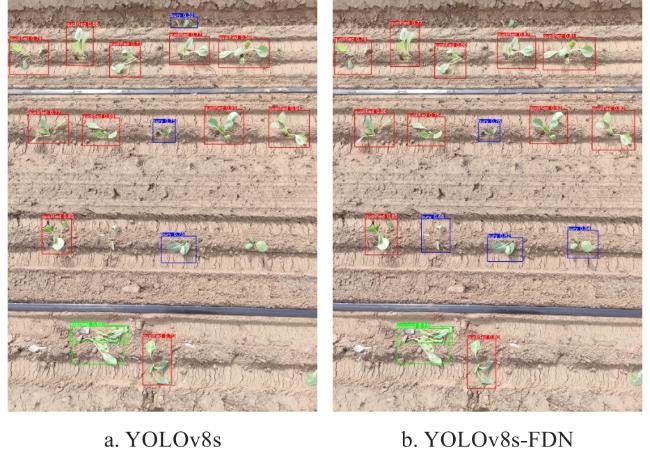

由于取苗栽植过程中会受到不可控因素的影响,会出现堵塞、伤苗、夹苗、掉苗等情况的发生,进而可能会导致露苗、埋苗、空穴、倒伏等栽植质量问题

[2]。传统的苗移栽状态识别工作围绕空化、倒伏展开

[3-5]。在现阶段的实践中发现,由于地块信息的不同,会导致移栽过程中出现因机械参数不适配导致的露苗、埋苗等情况。如果不及时调整机械并做出处理,很容易使苗暴晒死亡,造成额外的经济损失。截至目前,中国针对移栽工作中的移栽效果的统计研究较少,没有系统的智能化解决方案,大多还是依靠人工进行识别或借助经验进行操作,因此效率较低。对比之下,借助智能化识别及图像处理等技术来实现对移栽后蔬菜状态的识别和分析,将会极大提高识别效率。随着计算机技术快速发展,使得图像识别技术与交通、侦察及安全等领域结合并取得了较大进展

[6-8],在农业方面的应用也取得不错的进展,可实现对农作物幼苗的准确识别。张秀花等

[9]为了提高对番茄苗的分选、移栽和分级检测的准确性,引入多种特征融合机制,减轻模型对背景的关注,达到了97.64%的整体检测精度。Liu等

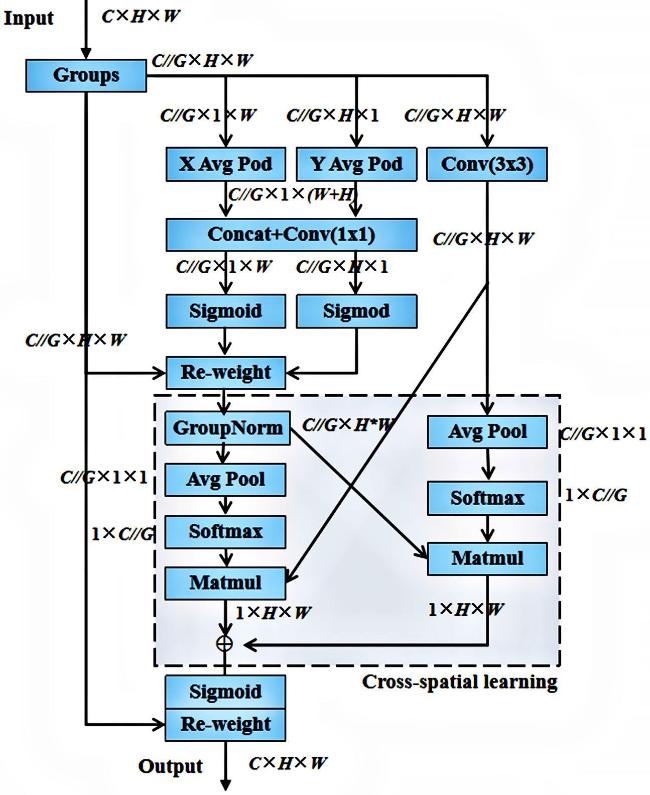

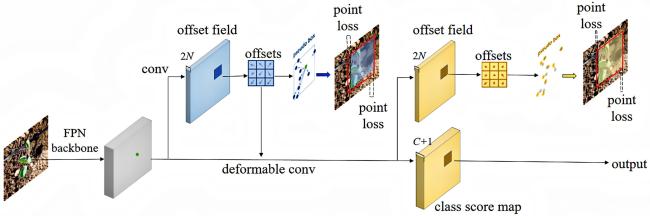

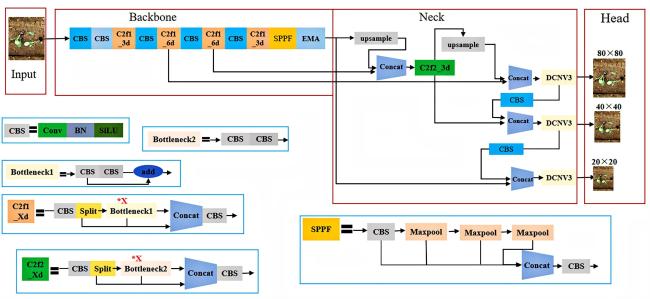

[10]使用目标检测网络来检测甘薯苗移栽状态,提出了双向特征金字塔网络(Directional Bidirectional Feature Pyramid Network, DBIFPN)结构和基于通道注意力和密集连接的网络(Convolutional Block Attention Module-Dense, CBAM_Dense),模型平均精度为97.66%。Li等

[11]提出一种基于改进YOLOv5s(You Only Look Once Version 5s)模型的导航线提取方法,基于两种种植方式的苗木移栽,实现导航线的精准提取和直接播种。Perugachi-Diaz等

[12]研究发现AlexNet能够实现对白菜幼苗94%的平均识别精度。Li等

[13]基于改进的Faster R-CNN (Faster Region-Based Convolutional Neural Network)对水培生菜幼苗进行分选,最终实现了86.2%的平均精度。