0 引 言

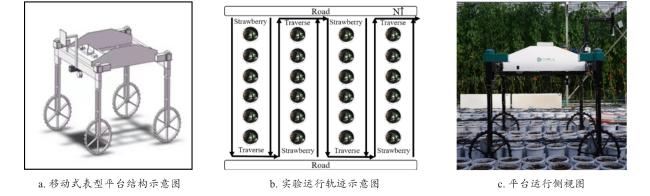

1 实验方法

1.1 数据获取

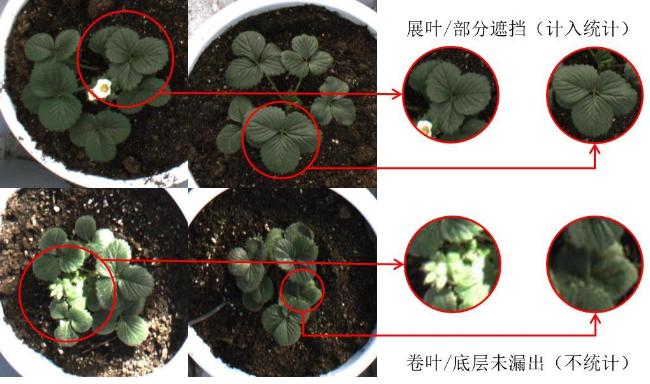

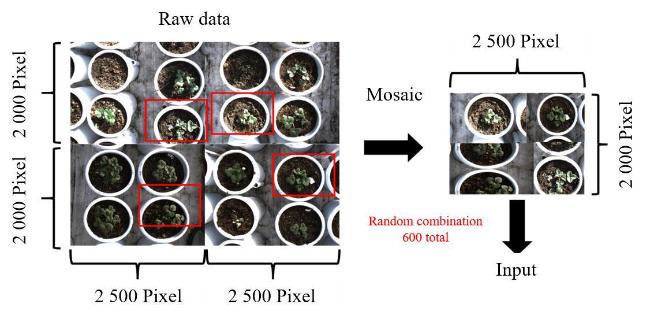

1.2 数据标注与预处理

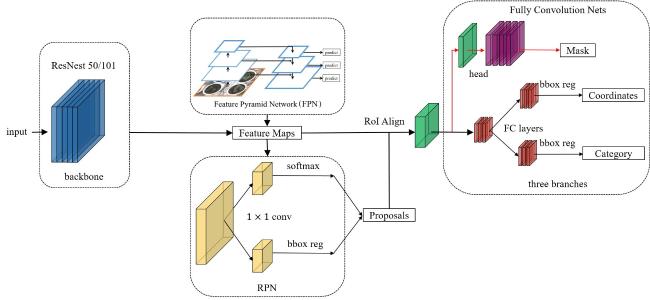

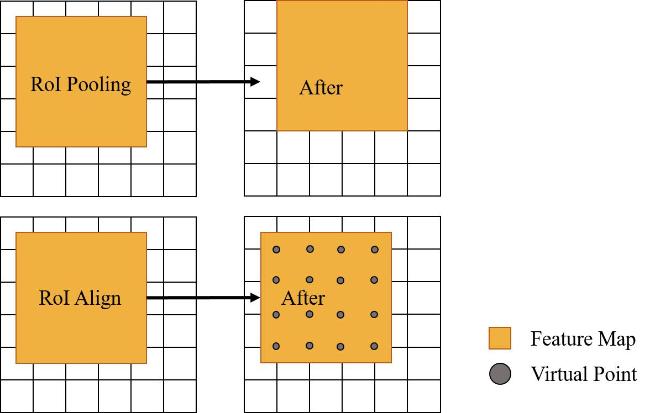

2 网络模型构建

2.1 边缘信息提取

2.2 损失函数

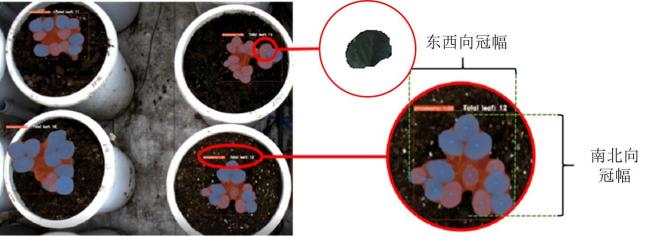

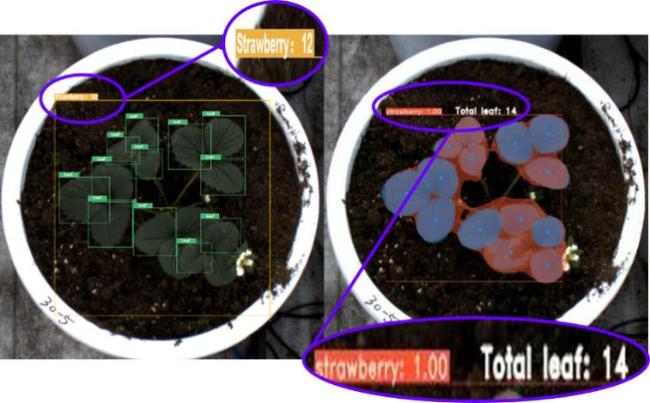

2.3 草莓叶龄统计与植株冠幅提取方法

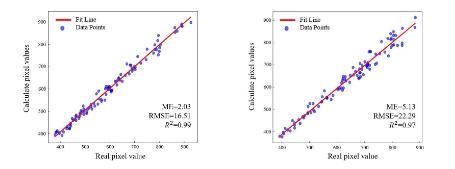

2.4 模型评价指标及方法准确性检验

3 实验结果

表1 改进Mask R-CNN研究模型训练所用服务器硬件参数Table 1 Hardware parameters of the server used for training the improved Mask R-CNN research model |

| 硬件设备 | 训练设备参数 | 测试设备参数 |

|---|---|---|

| CPU | 12th Gen Intel® Core i7-12700 | 6-core ARM v8.2 64-bit |

| 内存 | 16 GB | 8 GB |

| GPU | NVIDIA 3070ti | NVIDIA Pascal |

| 操作系统 | Windows 11 | Ubuntun 18.0.4 |

| 深度网络及加速架构版本 | Pytorch/CUDA11.8 | Pytorch |

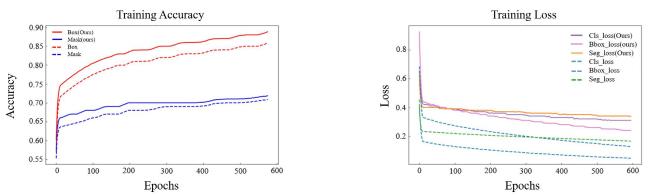

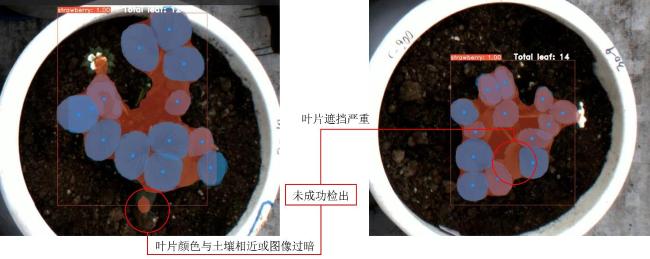

3.1 模型评估

3.2 消融实验

表2 草莓图像处理研究改进型Mask R-CNN实例分割研究消融实验Table 2 Research on strawberry image processing and improved Mask R-CNN instance segmentation with ablation experiment |

| 骨干网络 | 损失函数 | 检测框准确率/% | 掩膜准确率/% | 叶龄检测准确率/% |

|---|---|---|---|---|

| ResNeSt-101* | BCELoss | 89.6(Best) | 80.1(Best) | 99.3(Best) |

| ResNeSt-50* | BCELoss | 86.2 | 77.0 | 98.0 |

| ResNet-101* | BCELoss | 87.8 | 78.8 | 98.0 |

| ResNet-50* | BCELoss | 84.9 | 75.2 | 96.1 |

| ResNeSt-101 | BCELoss | 82.7 | 77.3 | 96.5 |

| ResNeSt-50 | BCELoss | 81.4 | 76.9 | 95.1 |

| ResNeSt-101* | Cross Entropy Loss | 87.2 | 78.1 | 97.6 |

| ResNeSt-50* | Cross Entropy Loss | 85.0 | 74.7 | 97.2 |

|

表3 草莓图像处理研究中改进Mask R-CNN模型与其他实例分割模型集参数量及执行效率对比Table 3 Comparison of parameter quantity and execution efficiency between improved Mask R-CNN model and other instance segmentation model sets in strawberry image processing research |

| 模型类别 | 模型参数量/M | 训练设备上推理速度/FPS | 测试设备的推理速度/FPS |

|---|---|---|---|

| 改进型Mask R-CNN(本研究) | 420.9 | 28.2 | 12.9 |

| Mask R-CNN(原始) | 480.1 | 20.4 | 7.5 |

| YOLOv8 | 640.5 | 19.3 | 6.3 |

| Yolact | 380.7 | 25.4 | 11.4 |

| Yolact++ | 365.5 | 24.9 | 11.0 |

3.3 不同模型结果对比

表4 草莓图像处理研究中不同模型在相同输入和参数下掩膜准确率与检测框准确率对比Table 4 Comparison of Mask accuracy and detection box accuracy of different models in strawberry image processing under the same input and parameters |

| 模型类别 | 掩膜准确率/% | 检测框准确率/% |

|---|---|---|

| 改进Mask R-CNN(本研究) | 80.1 | 89.6 |

| Mask R-CNN(原始) | 76.2 | 86.2 |

| Yolact | 76.5 | 84.9 |

| Yolact++ | 77.3 | 86.0 |

| YOLOv8 | 81.9 | 89.2 |

| YOLOv5 | — | 88.2 |

| YOLOX | — | 90.1 |

| DeepLabv3+ | 78.8 | — |

| U-Net | 76.5 | — |

|

表5 不同模型检测草莓植株与叶片数准确率Table 5 Accuracy of different models for strawberry plant and leaf numbers |

| 模型类别 | 模型正确检出值/人工计数值 | 正确率/% |

|---|---|---|

| 改进型Mask R-CNN(本研究)* | 412/415 | 99.3(Best) |

| 改进型Mask R-CNN(本研究)※ | 6 014/6 136 | 98.0(Best) |

| Mask R-CNN(原始)* | 405/415 | 97.6 |

| Mask R-CNN(原始)※ | 5 876/6 136 | 95.8 |

| Yolact* | 403/415 | 97.1 |

| Yolact※ | 5 993/6 136 | 97.7 |

| Yolact++* | 410/415 | 98.8 |

| Yolact++※ | 5 899/6 136 | 96.1 |

| YOLOv8* | 412/415 | 99.3(Best) |

| YOLOv8※ | 5 993/6 136 | 97.7 |

| YOLOv5* | 412/415 | 99.3(Best) |

| YOLOv5※ | 6 001/6 136 | 97.8 |

| YOLOX* | 412/415 | 99.3(Best) |

| YOLOX※ | 6 009/6 136 | 97.9 |

|