近年来,深度学习领域取得了迅猛发展,为行为识别研究提供了崭新的视角和方法。传统的手工特征提取方法通常伴随着内存需求较高的问题,并受到特征单一性的限制,从而在扩展性方面存在一定的挑战。这些深度学习方法不仅能够高效处理大规模数据,还能够自动从数据中学习丰富的特征表示,因此在视频行为识别等领域表现出巨大的潜力。主流的基于深度学习的视频理解算法包括双流卷积神经网络(Two-Stream Convolutional Neural Networks, Two-Stream CNN)、人体骨架识别、三维卷积神经网络(3D CNN),以及视觉Transformer。这些网络结构在捕捉视频中的行为特征和动作信息方面发挥着重要的作用。2014年,Simonyan和Zisserman

[11]提出了一种创新的方法,即双流卷积神经网络。这个网络采用了两个分支:一个分支专门用于提取时间流特征;另一个分支则专注于提取空间流特征。在网络的后端,它将这两个流的特征融合在一起,以实现更加全面和高效的信息提取和表示。这一方法为视频行为识别等任务带来了重要的突破,使得模型能够更好地理解时间和空间信息,从而提高了识别性能。在此基础上进行改进的网络有TSN(Temporal Segment Networks)

[12]网络和I3D( Inflated 3D ConvNet)

[13]网络。3D卷积神经网络通过加入时间维度来代替光流,可以实现端到端的识别。Tran等

[14]使用3D卷积构建了C3D(Convolutional Three Dimensional)模型,它将VGGNet(Visual Geometry Group network)网络

[15]的卷积核由3×3的2D卷积扩展为3×3×3的3D卷积。之后出现的R3D(Residual 3D Convolutional Network)

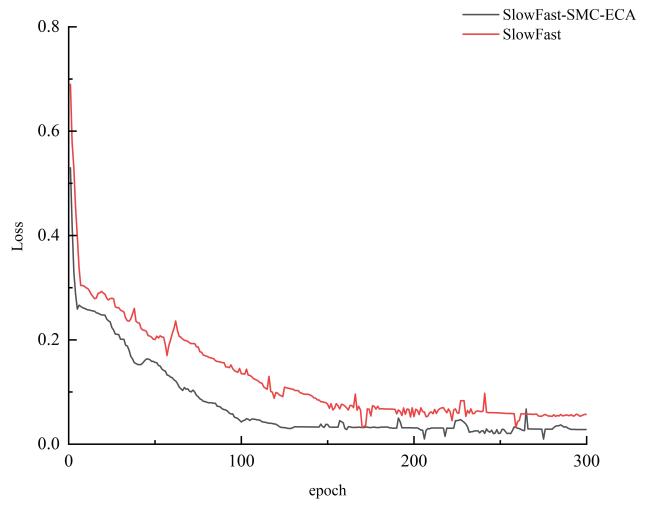

[16]网络和SlowFast

[17]网络等都基于3D卷积神经网络。此外,在长短时记忆网络(Long Short-Term Memory, LSTM)的进展中,Donahue等

[18]引入了长期循环卷积神经网络(Long-term recurrent Convolutional Networks, LRCN)的概念。LRCN结合了2D卷积神经网络(2D CNN)来提取帧级特征,并随后利用LSTM来建模多个视频帧之间的时间关系。这一方法在视频行为识别领域具有重要的应用潜力。