0 引 言

1 材料与方法

1.1 实验数据

1.1.1 图像数据采集

1.1.2 图像数据增强

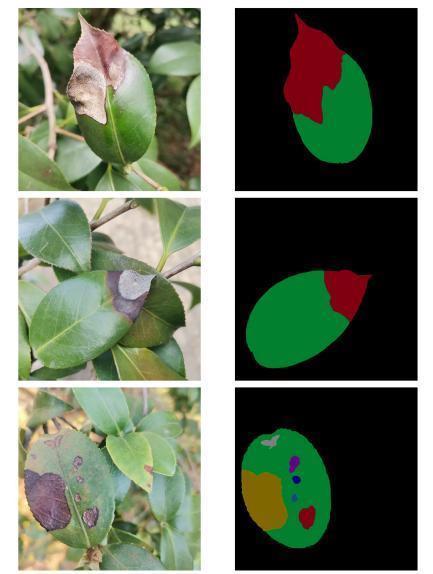

1.1.3 油茶炭疽病严重程度分级

表1 油茶炭疽病严重程度分级标准Table 1 Classification standard for the degree of Camellia oleifera leaf anthracnose |

| 严重程度分级 | 分级标准 |

|---|---|

| 0级 | 无病斑 |

| 1级 | K≤25% |

| 2级 | 25%< K≤50% |

| 3级 | 50%< K≤75% |

| 4级 | K >75% |

|

1.2 YOLACT的分割模型改进

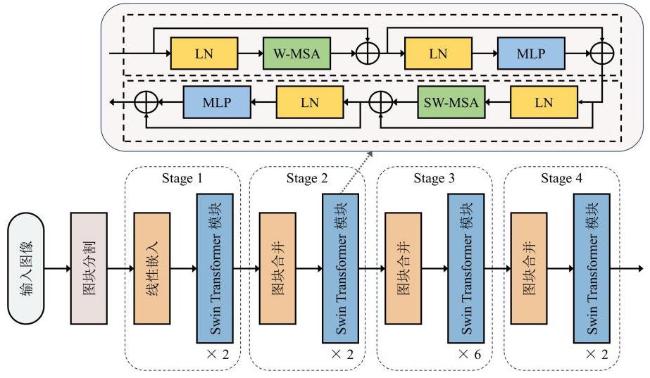

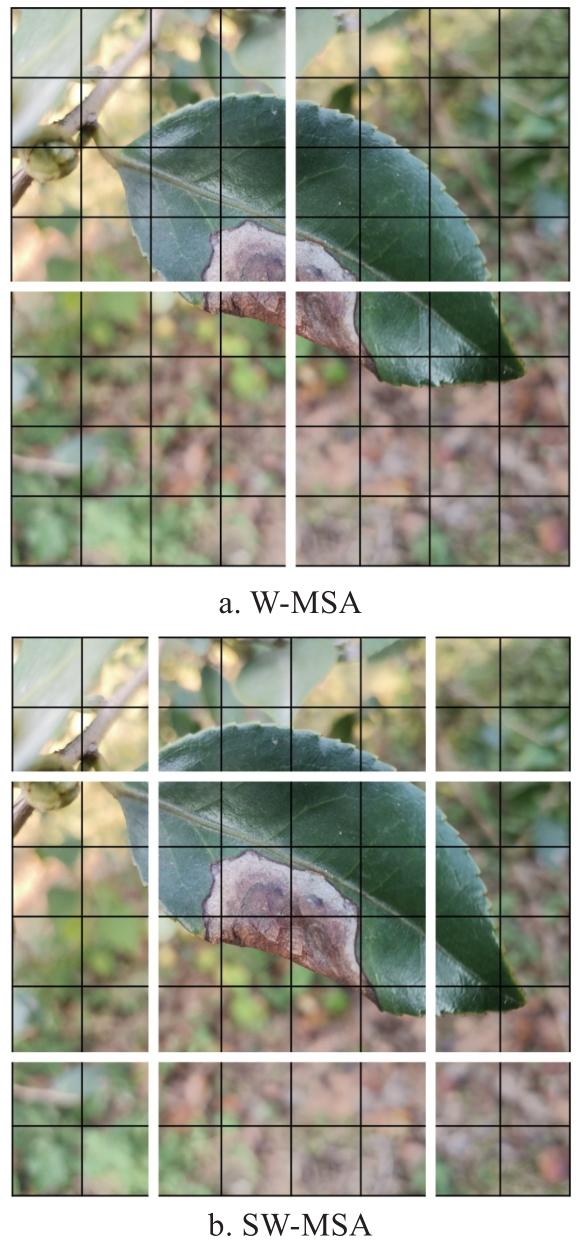

1.2.1 特征提取主干网络Swin-Transformer

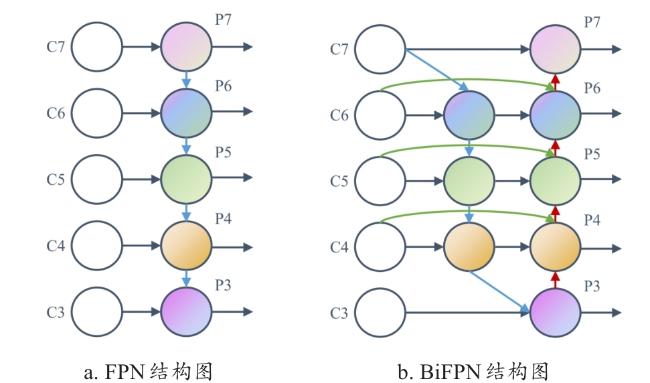

1.2.2 特征融合网络改进

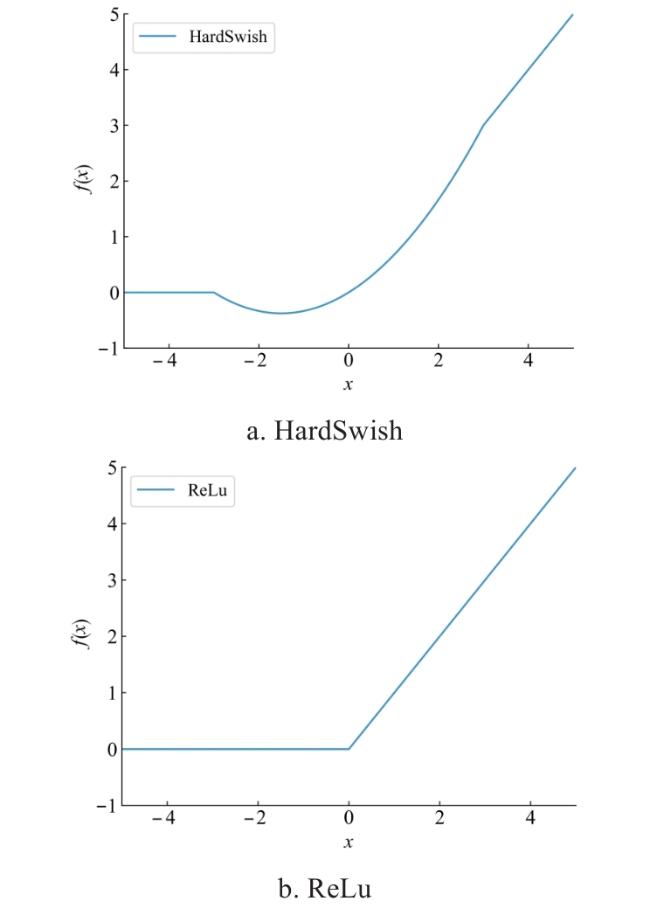

1.2.3 激活函数优化

2 实验与结果分析

2.1 实验环境

2.2 评价指标

2.3 消融实验

表2 改进的YOLACT算法消融实验结果Table 2 Results of ablation experiments with the improved YOLACT |

| 编号 | 主干网络 | BiFPN | HardSwish | mAP75/% | mAPall/% | mAR/% |

|---|---|---|---|---|---|---|

| 0 | ResNet50 | × | × | 81.1 | 75.8 | 83.7 |

| 1 | Swin-T | × | × | 86.7 | 78.0 | 91.2 |

| 2 | Swin-T | √ | × | 86.5 | 78.1 | 91.3 |

| 3 | Swin-T | √ | √ | 86.8 | 78.3 | 91.6 |

|

2.4 与其他分割方法对比

图8 不同算法对油茶炭疽病分割效果a. 原图 b. Camelia-YOLACT c. Mask R-CNN d. SOLO Fig.8 Effectiveness of different algorithms for segmentation of Camellia oleifera leaf anthracnose |

表3 不同算法的油茶炭疽病分割效果对比实验Table 3 Comparative experiment on the segmentation effect of different algorithms for Camellia oleifera leaf anthracnose |

| 模型 | mAP75/% | mAPall /% | mAR/% | td/ms |

|---|---|---|---|---|

| YOLACT | 81.1 | 75.8 | 83.7 | 46.85 |

| Mask R-CNN | 90.4 | 81.5 | 92.3 | 168.16 |

| SOLO | 87.1 | 77.8 | 90.4 | 75.73 |

| Camellia-YOLACT | 86.8 | 78.3 | 91.6 | 53.50 |

2.5 油茶炭疽病分级实验

表4 Camellia-YOLACT算法油茶炭疽病分级实验Table 4 Experimental classification of Camellia oleifera anthracnose by Camellia-YOLACT method |

| 编号 | 真实值 | 预测值 | K绝对误差/% | 编号 | 真实值 | 预测值 | K绝对误差/% | ||||

|---|---|---|---|---|---|---|---|---|---|---|---|

| K/% | 等级 | K/% | 等级 | K/% | 等级 | K/% | 等级 | ||||

| 1 | 58.31 | 3 | 57.28 | 3 | 1.03 | 19 | 80.68 | 4 | 77.11 | 4 | 3.57 |

| 2 | 43.14 | 2 | 43.05 | 2 | 0.09 | 20 | 23.92 | 1 | 21.31 | 1 | 2.61 |

| 3 | 0.00 | 0 | 0.00 | 0 | 0.00 | 21 | 6.26 | 1 | 6.24 | 1 | 0.02 |

| 4 | 7.32 | 1 | 6.84 | 1 | 0.48 | 22 | 16.55 | 1 | 13.69 | 1 | 2.86 |

| 5 | 26.08 | 2 | 24.56 | 1 | 1.52 | 23 | 22.32 | 1 | 20.28 | 1 | 2.04 |

| 6 | 8.54 | 1 | 8.03 | 1 | 0.51 | 24 | 7.83 | 1 | 7.04 | 1 | 0.79 |

| 7 | 63.88 | 3 | 63.03 | 3 | 0.85 | 25 | 21.80 | 1 | 21.50 | 1 | 0.30 |

| 8 | 10.39 | 1 | 9.34 | 1 | 1.05 | 26 | 0.00 | 0 | 0.00 | 0 | 0.00 |

| 9 | 52.65 | 3 | 49.12 | 2 | 3.53 | 27 | 8.18 | 1 | 7.67 | 1 | 0.51 |

| 10 | 76.44 | 4 | 75.34 | 4 | 1.10 | 28 | 12.97 | 1 | 10.95 | 1 | 2.02 |

| 11 | 53.34 | 3 | 53.26 | 3 | 0.08 | 29 | 19.50 | 1 | 18.38 | 1 | 1.12 |

| 12 | 0.00 | 0 | 0.00 | 0 | 0.00 | 30 | 13.77 | 1 | 13.55 | 1 | 0.22 |

| 13 | 0.00 | 0 | 0.00 | 0 | 0.00 | 31 | 28.68 | 2 | 27.64 | 2 | 1.04 |

| 14 | 12.19 | 1 | 11.29 | 1 | 0.90 | 32 | 7.21 | 1 | 4.50 | 1 | 2.71 |

| 15 | 18.18 | 1 | 17.99 | 1 | 0.20 | 33 | 14.81 | 1 | 13.07 | 1 | 1.74 |

| 16 | 47.29 | 2 | 46.20 | 2 | 1.09 | 34 | 5.04 | 1 | 4.72 | 1 | 0.32 |

| 17 | 62.31 | 3 | 59.92 | 3 | 2.39 | 35 | 11.06 | 1 | 10.50 | 1 | 0.56 |

| 18 | 36.39 | 2 | 35.86 | 2 | 0.53 | 36 | 18.22 | 1 | 16.85 | 1 | 1.37 |

|