0 引 言

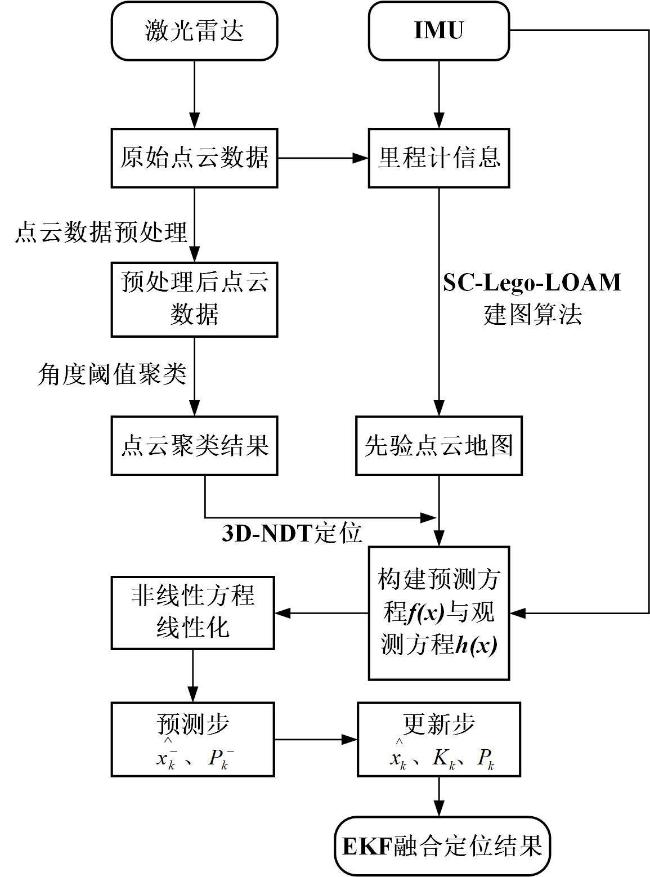

1 材料与方法

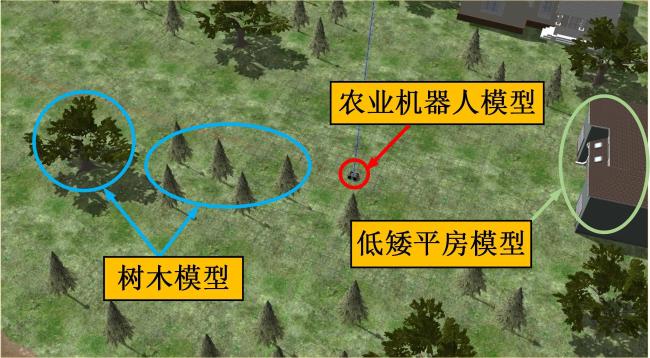

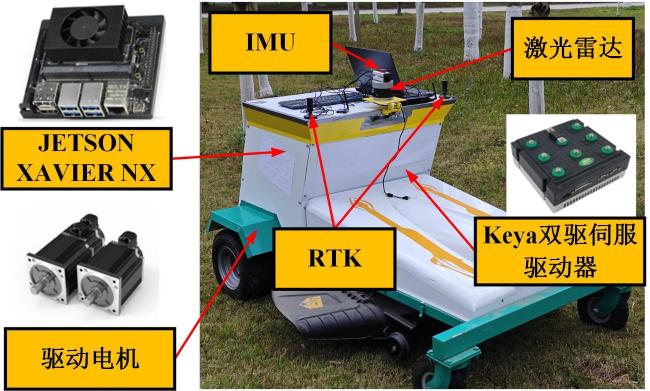

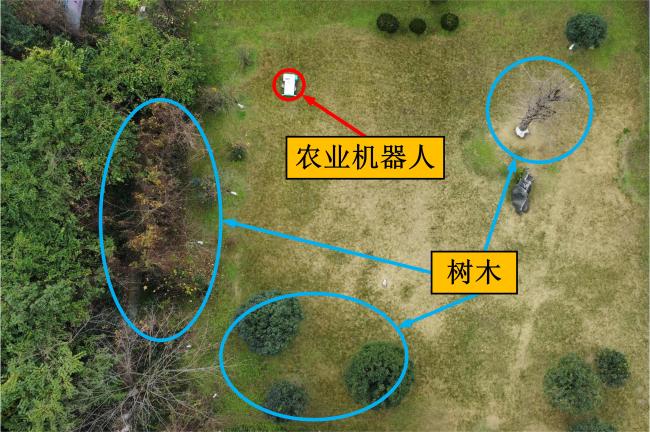

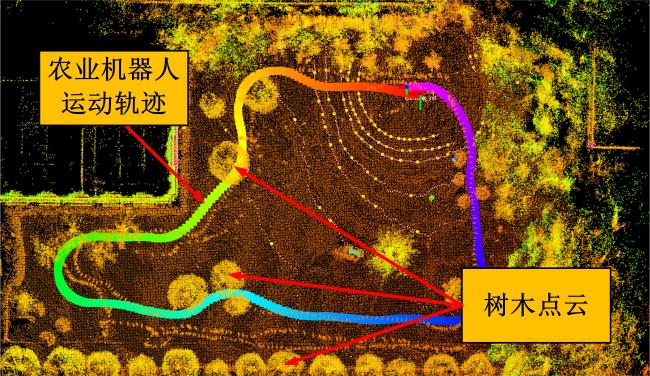

1.1 仿真与实验平台

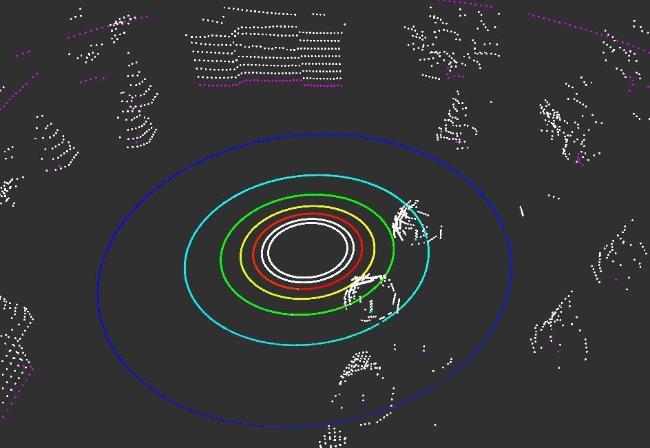

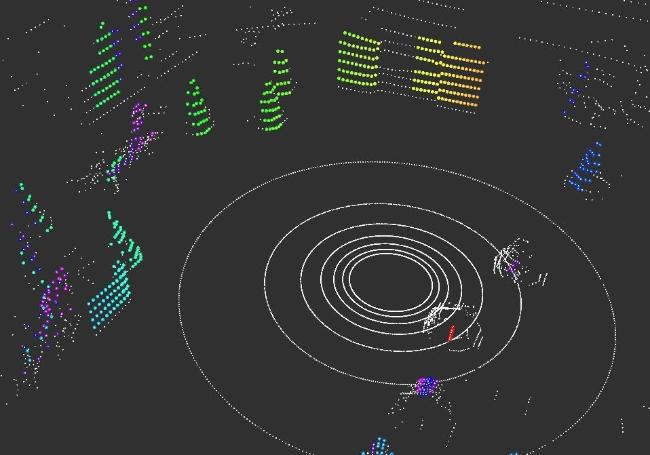

1.2 激光雷达点云聚类

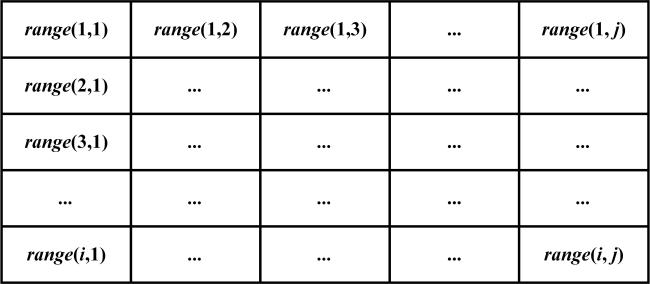

1.2.1 点云数据预处理

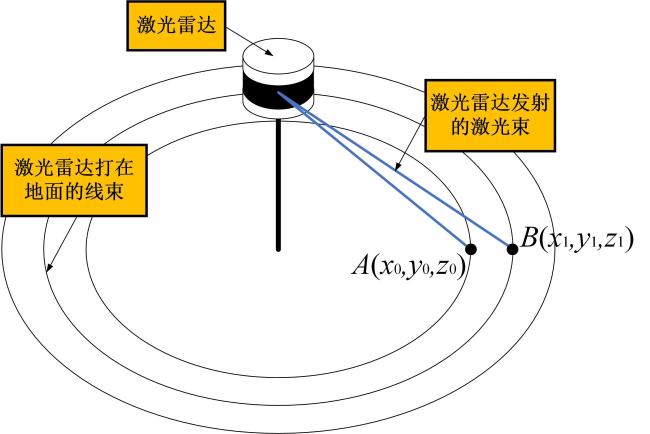

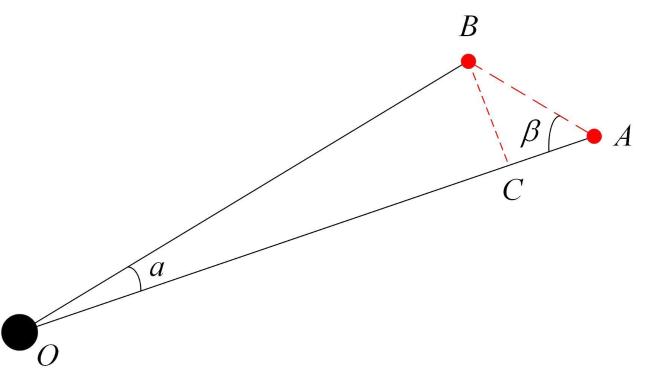

1.2.2 地面点云去除

1.2.3 点云聚类

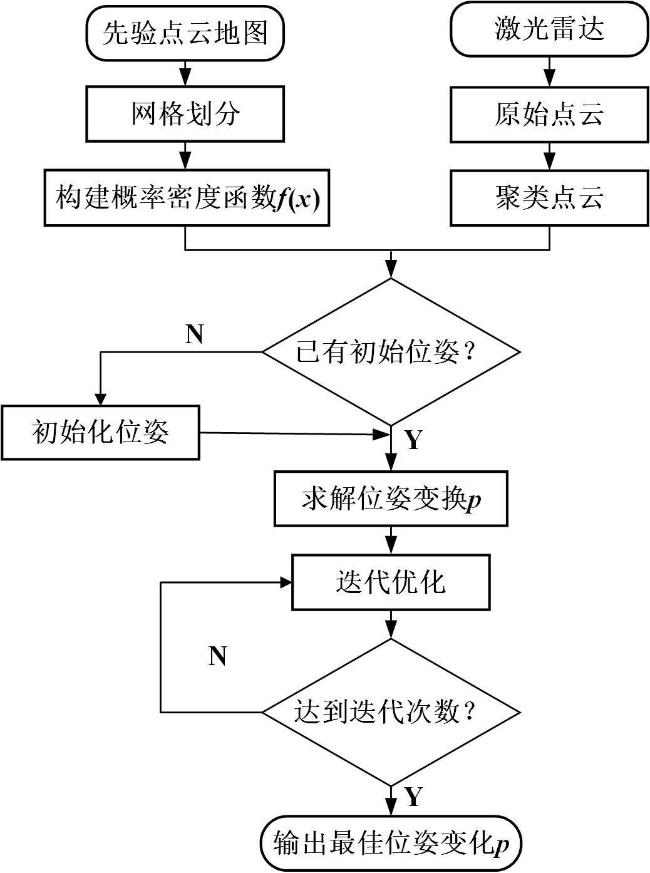

1.2.4 改进的3D-NDT定位算法

1.3 基于EKF的激光雷达与IMU融合定位

1.3.1 基于EKF的最优估计流程

1.3.2 基于EKF的传感器融合定位

2 结果与分析

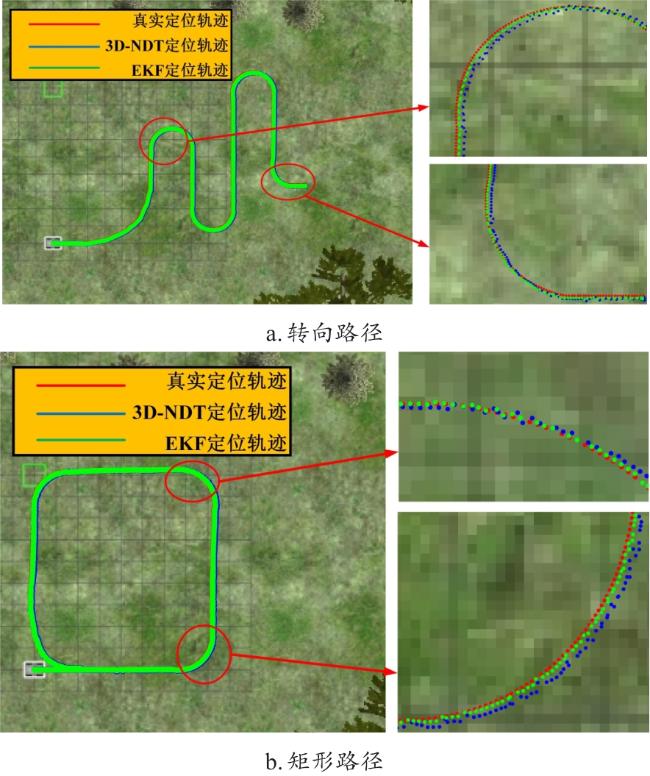

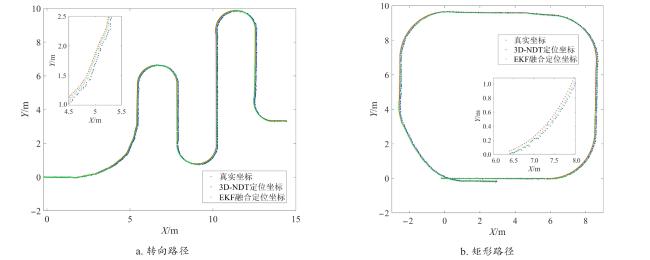

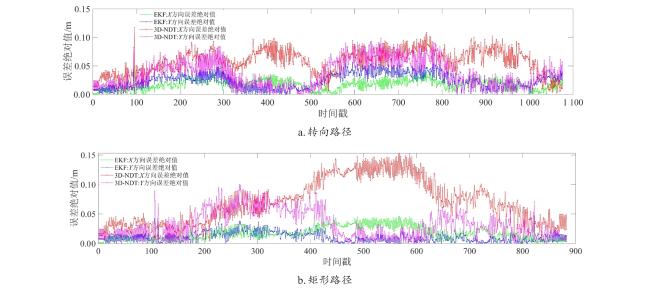

2.1 仿真结果与分析

图12 仿真环境下农业机器人的定位误差Fig. 12 Localization error of the agricultural robot in simulation environment |

表1 仿真环境下农业机器人的定位误差统计表Table 1 Localization error statistical table of agricultural robot in simulation environment |

| 路径 | 算法 | X方向上的平均误差绝对值/cm | Y方向上的平均误差绝对值/cm | X方向上的最大误差绝对值/cm | Y方向上的最大误差绝对值/cm |

|---|---|---|---|---|---|

| 转向路径 | 3D-NDT定位算法 | 5.8 | 3.7 | 11.7 | 9.9 |

| EKF融合定位算法 | 1.7 | 2.4 | 4.9 | 5.6 | |

| 矩形路径 | 3D-NDT定位算法 | 6.2 | 3.2 | 15.3 | 10.0 |

| EKF融合定位算法 | 1.7 | 1.1 | 4.6 | 4.7 | |

| 综合两种工况 | 3D-NDT定位算法 | 6.0 | 3.5 | 15.3 | 10.0 |

| EKF融合定位算法 | 1.7 | 1.8 | 4.9 | 5.6 | |

| 算法性能提升/% | 71.7 | 48.6 | |||

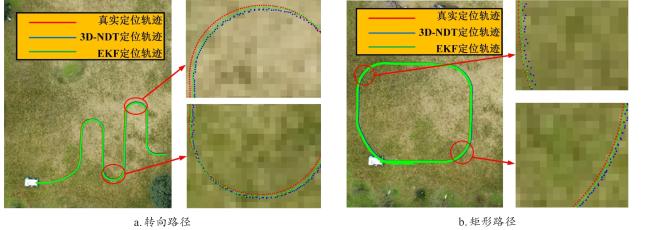

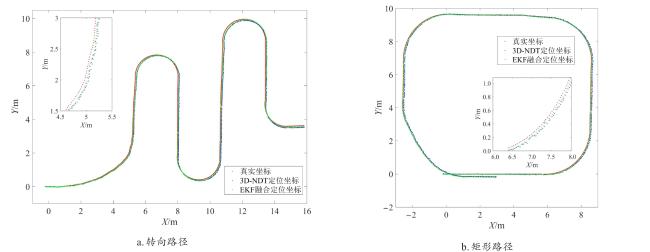

2.2 实验结果与分析

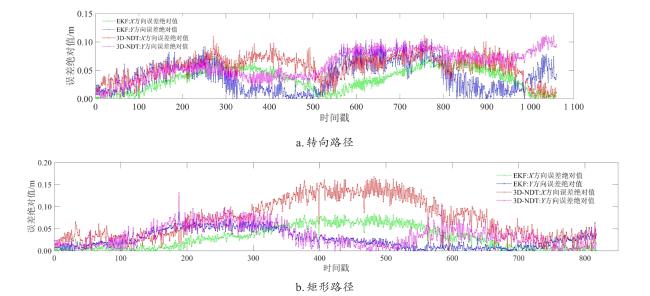

图17 实验环境下农业机器人的定位误差Fig. 17 Localization error of agricultural robot in experimental environment |

表2 实验环境下农业机器人的定位误差统计表Table 2 Localization error statistical table of agricultural robot in experimental environment |

| 路径 | 算法 | X方向上的平均误差绝对值/cm | Y方向上的平均误差绝对值/cm | X方向上的最大误差绝对值/cm | Y方向上的最大误差绝对值/cm |

|---|---|---|---|---|---|

| 转向路径 | 3D-NDT定位算法 | 6.7 | 6.0 | 11.7 | 11.1 |

| EKF融合定位算法 | 3.5 | 3.9 | 7.5 | 10.5 | |

| 矩形路径 | 3D-NDT定位算法 | 7.3 | 5.0 | 16.8 | 13.2 |

| EKF融合定位算法 | 3.0 | 2.6 | 8.4 | 8.7 | |

| 综合两种工况 | 3D-NDT定位算法 | 7.0 | 5.5 | 16.8 | 13.2 |

| EKF融合定位算法 | 3.3 | 3.3 | 8.4 | 10.5 | |

| 算法性能提升/% | 52.9 | 40.0 | |||