近年来,国内外众多研究学者对农机定位方式与导航控制方法进行了设计与研究。Cho等

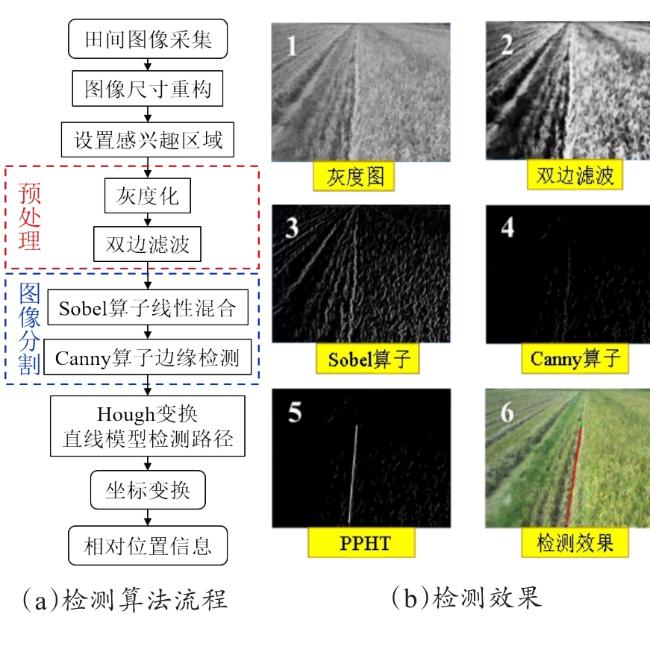

[5]通过逆透视变换获取稻田鸟瞰图,对未收割稻田边缘应用灰度化、边缘检测算法,检测准确率达97%。Kurita等

[6,7]在履带式收获机上搭载全球导航卫星系统(Global Navigation Satellite System,GNSS)及全球定位系统(Global Positioning System,GPS)罗盘获取车辆绝对位置和方向,导航作业横向和方位角误差的均方根误差分别为0.04 m和2.6°。David等

[8]开展了针对农用机器人的避障系统研究,利用视觉和惯性传感器实现了对田间障碍物的检测和绕行。Zhang等

[9]提出一种基于SUSAN角和改进顺序聚类算法的除草机器人导航方法,能在稻田复杂环境下提取导航线并进行跟踪控制。魏爽等

[10,11]开发了电动方向盘式农机自动导航软件系统,利用卫星定位和纯追踪模型实现了直线与转弯路径的导航控制。伟利国等

[12]和赵腾

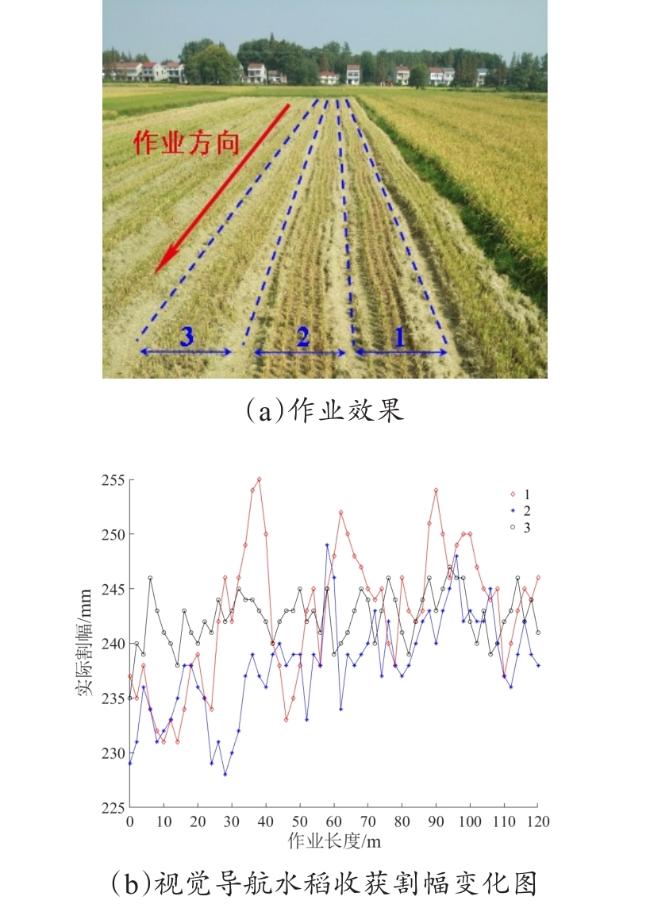

[13]采用激光扫描仪获取收获边界线的相对位置信息,实现在线监测联合收获机田间作业割幅变化。曾宏伟等

[14]基于区域生长算法,提出了一种低对比度情况下的小麦收获边界线提取方法,比人工标定线夹角平均误差小于1.21°。张雄楚等

[15]提出了一种用于红枣收获机的枣树行视觉导航路径检测算法,能够自动判别枣园种类进行作业,试验在两个不同种类的枣园进行,路径检测准确率平均值分别为94%和93%。张闻宇等

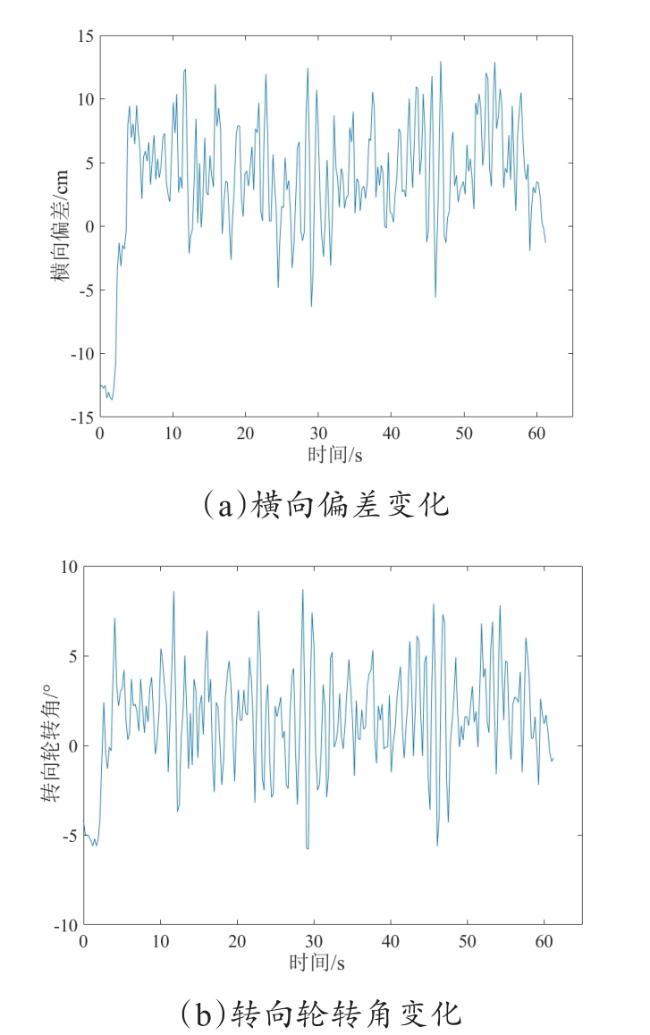

[16-18]基于摩擦轮式转向驱动系统,设计了自适应模糊控制转向控制器,实现了平均横向偏差为0.039 m的油菜联合直播机自动导航。何卿等

[19]通过分析运动过程中秸秆接触受力,研制机械式触感导航装置,借助竹竿模拟了拖拉机沿秸秆行间作业行驶。上述研究中,基于卫星差分定位的农机自动导航方法由于不依赖作业环境信息或农作物生长状态,多用于耕整、播施环节;基于激光的检测方法受安装精度、测量范围及传感器震动等的影响,工作稳定性不足;基于接触式的导航装置限于行距标准不统一及秸秆类型不同,实际应用场合较为特殊;基于作物收获边界的视觉导航方法主要应用于小麦、玉米的收获边界检测

[20-22]。目前针对水稻收获边界的检测与跟踪研究较少。