1 引 言

2 材料和方法

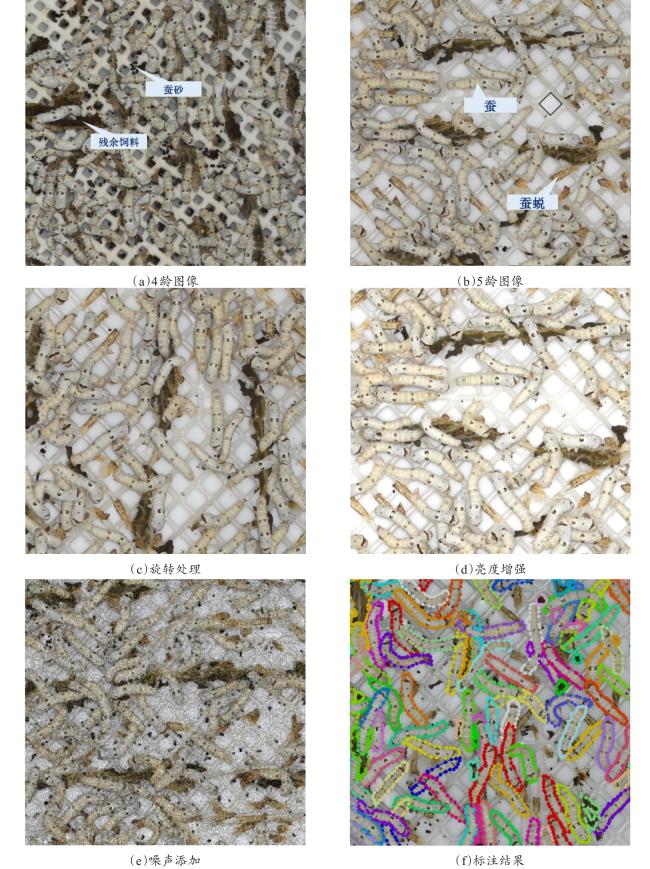

2.1 数据采集和预处理

2.1.1 数据采集

2.1.2 图像预处理

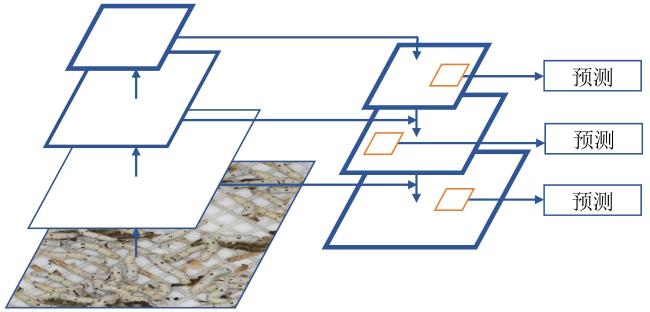

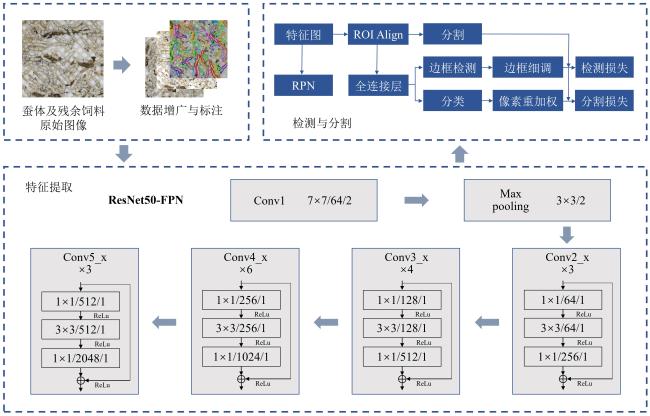

2.2 Mask R-CNN

2.3 利用噪声数据改进Mask R-CNN模型

2.3.1 原始Mask R-CNN模型存在问题及改进思路

2.3.2 主要处理流程

2.4 模型性能评价

2.4.1 准确率

2.4.2 平均精度

2.3.3 检测速度

3 试验与结果分析

3.1 试验设置和模型训练参数

表1 蚕体和残余饲料识别模型的初始化参数Table 1 The initialization parameters of the model for silkworm and residual feed |

| 图像尺寸/px | 批尺寸 | 动量 | 初始学习率 | 总步长/步 | 权重衰减 |

|---|---|---|---|---|---|

| 512×512 | 16 | 0.8 | 0.02 | 85,000 | 0.0005 |

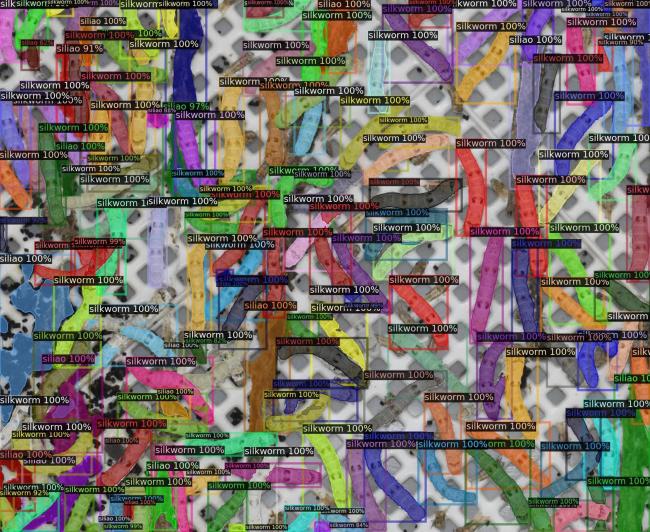

3.2 检测与分割结果

表2 两种蚕体与残余饲料检测模型的性能Table 2 The performance of the silkworm and residual feed detection models |

| 模型 | 目标 | 准确率/% | 检测 AP50 | 分割AP50 |

|---|---|---|---|---|

| Mask R-CNN | 蚕 | 95.23 | 0.764 | 0.768 |

| 饲料 | 85.35 | 0.602 | 0.611 | |

| 改进Mask R-CNN | 蚕 | 96.83 | 0.790 | 0.795 |

| 饲料 | 87.71 | 0.641 | 0.653 |

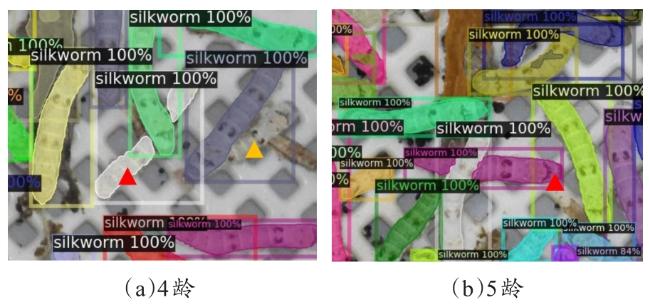

3.3 不同龄期蚕分割模型表现

表3 不同龄期蚕数据训练改进Mask R-CNN模型的蚕体检测性能Table 3 The silkworm detection performances of the improved Mask R-CNN models using the training data of different instars |

| 龄期 | 准确率/% | 检测AP50 | 分割AP50 |

|---|---|---|---|

| 4龄 | 95.21 | 0.768 | 0.774 |

| 5龄 | 97.82 | 0.801 | 0.815 |

3.4 蚕体重叠对检测性能影响

3.5 数据增广对检测性能影响

表4 利用不同数据集训练的改进Mask R-CNN模型的蚕体检测性能Table 4 The silkworm detection performances of the improved Mask R-CNN model trained by different datasets |

| 数据集 | 准确率/% | 检测 AP50 | 分割 AP50 |

|---|---|---|---|

| 完整数据集 | 96.83 | 0.790 | 0.795 |

| 剔除旋转与翻转处理数据 | 94.79 | 0.773 | 0.771 |

| 剔除亮度增强数据 | 93.34 | 0.747 | 0.751 |

| 剔除噪声添加数据 | 96.02 | 0.785 | 0.791 |