1 引 言

2 材料与方法

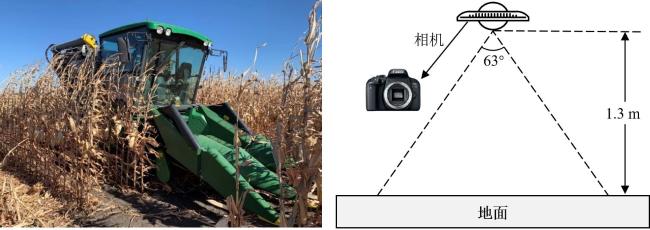

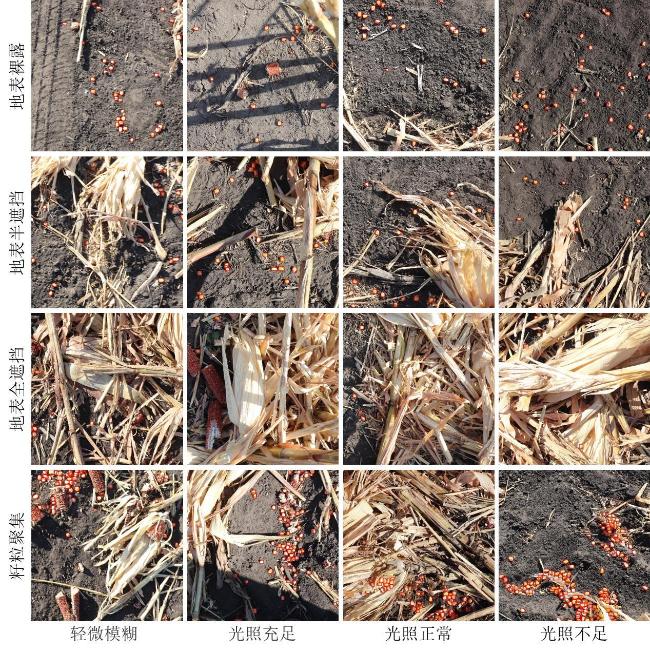

2.1 图像采集

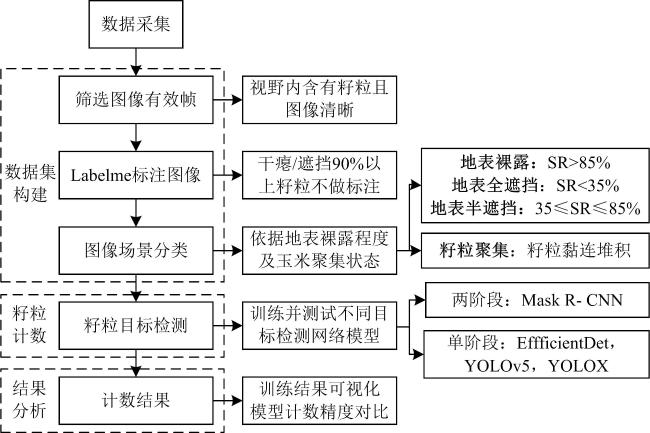

2.2 技术路线

2.2.1 数据集构建

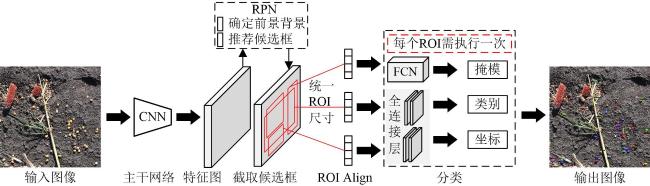

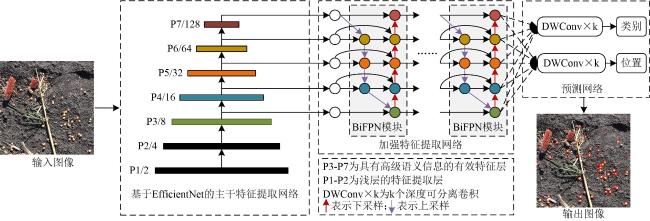

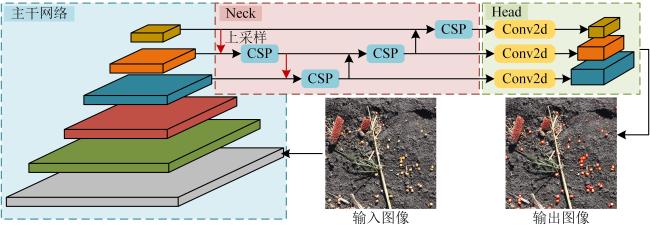

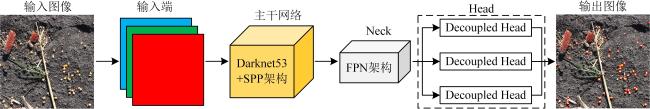

2.2.2 方法设计

2.2.3 评价指标

2.3 实验配置

3 结果与讨论

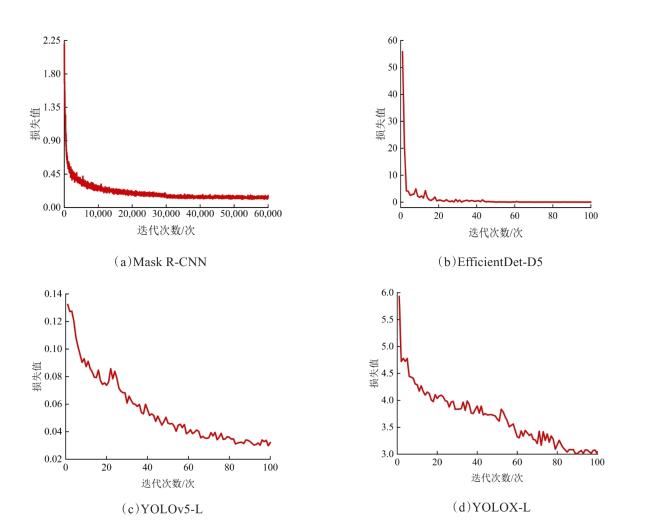

3.1 网络模型训练

表1 四种网络模型性能测试结果对比Table 1 Performance comparison of test results for four deep learning models |

| 模型 | AP/% | 帧率/(f·s-1) | 模型参数量/MB | GFLOPs | 训练时长/min | 模型尺寸/MB |

|---|---|---|---|---|---|---|

| Mask R-CNN | 68.8 | 8.85 | 63.0 | 164.4 | 504 | 479.8 |

| EfficientDet-D5 | 50.9 | 7.43 | 33.4 | 135.8 | 360 | 128.7 |

| YOLOv5-L | 78.3 | 55.55 | 47.0 | 115.6 | 26 | 89.3 |

| YOLOX-L | 66.5 | 27.02 | 54.0 | 155.3 | 84 | 207.0 |

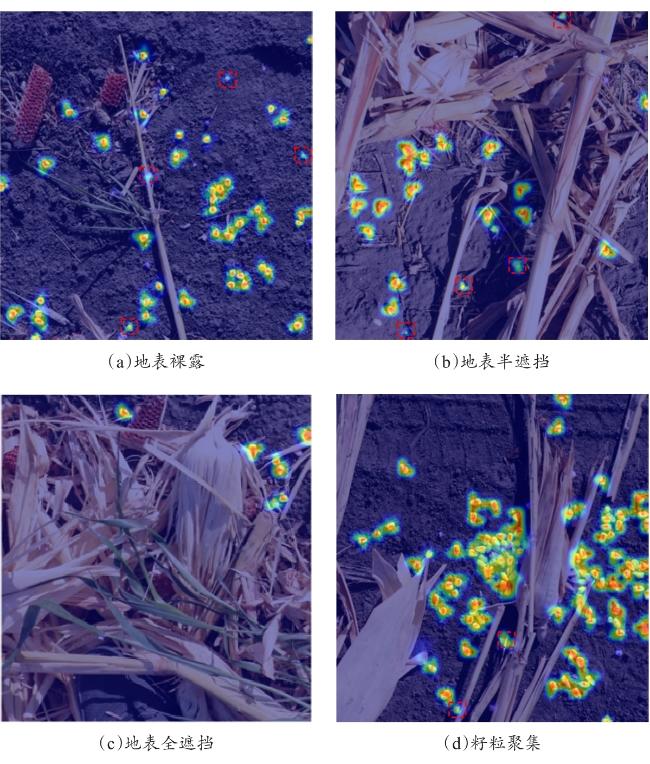

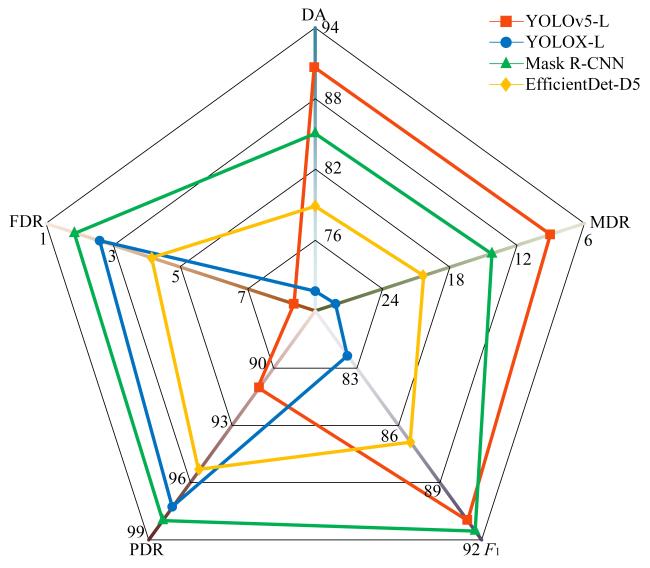

3.2 识别结果分析

3.3 计数结果对比

表2 不同场景下四种网络的玉米籽粒计数性能结果Table 2 Corn kernel counting performance results of four networks in different scenarios |

| 场景 | 指标 | 模型 | |||

|---|---|---|---|---|---|

| Mask R-CNN | EfficientDet-D5 | YOLOv5-L | YOLOX-L | ||

| 地表 裸露 | DA | 95.6 | 88.9 | 98.2 | 86.3 |

| MDR | 4.4 | 11.1 | 1.8 | 13.7 | |

| FDR | 1.7 | 3.8 | 8.6 | 3.2 | |

| PDR | 98.3 | 96.2 | 91.4 | 96.8 | |

| F 1 | 96.9 | 92.4 | 94.7 | 91.2 | |

| 地表半遮挡 | DA | 92.3 | 83.4 | 95.5 | 81.7 |

| MDR | 7.7 | 16.6 | 4.5 | 18.3 | |

| FDR | 1.7 | 3.4 | 7.7 | 2.4 | |

| PDR | 98.3 | 96.6 | 92.3 | 97.6 | |

| F 1 | 95.3 | 89.5 | 93.8 | 88.9 | |

| 地表全遮挡 | DA | 84.0 | 56.4 | 76.1 | 61.5 |

| MDR | 16.0 | 43.6 | 23.9 | 38.5 | |

| FDR | 5.7 | 7.5 | 9.3 | 2.9 | |

| PDR | 94.3 | 92.5 | 90.7 | 97.1 | |

| F 1 | 88.9 | 70.1 | 82.8 | 75.3 | |

| 籽粒 聚集 | DA | 74.0 | 72.0 | 83.3 | 54.7 |

| MDR | 26.0 | 28.0 | 16.7 | 45.3 | |

| FDR | 1.3 | 4.8 | 9.0 | 1.8 | |

| PDR | 98.7 | 95.2 | 91.0 | 98.2 | |

| F 1 | 84.5 | 82.0 | 87.0 | 70.3 | |