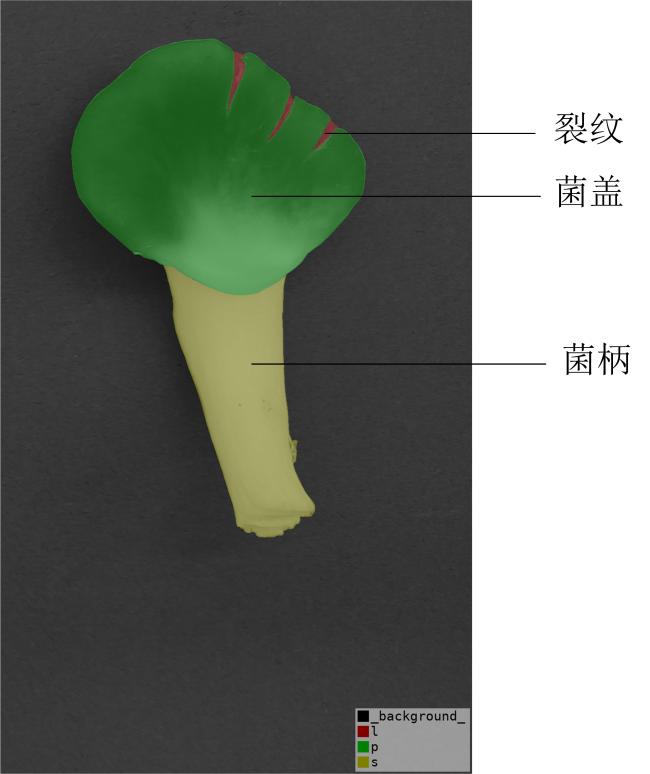

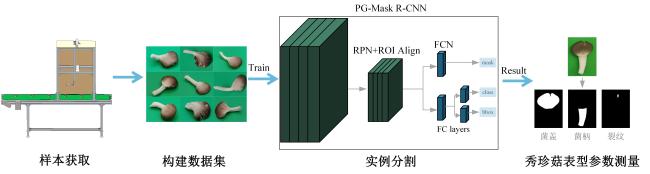

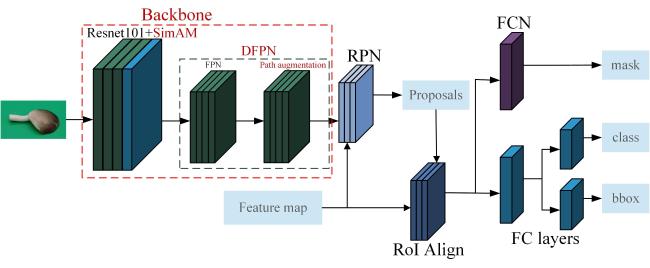

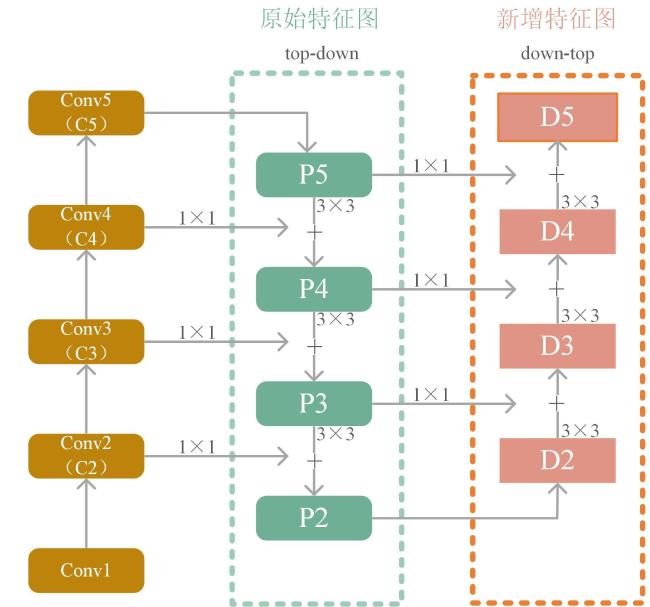

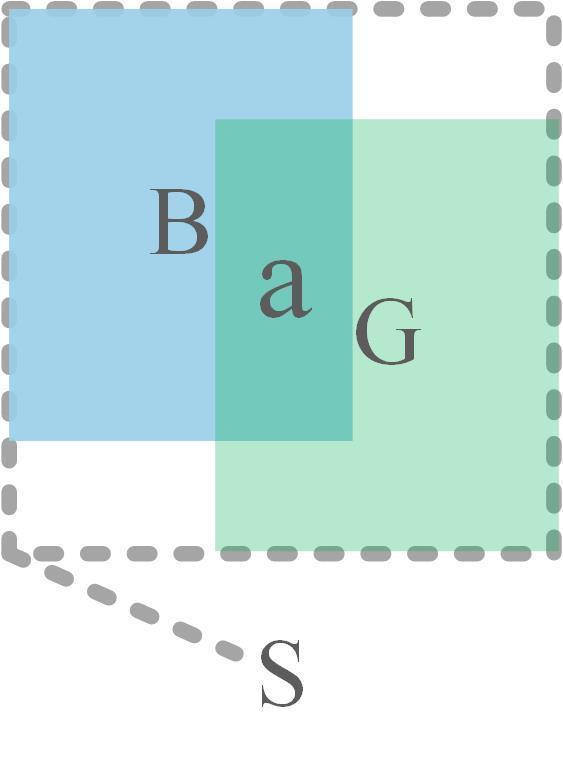

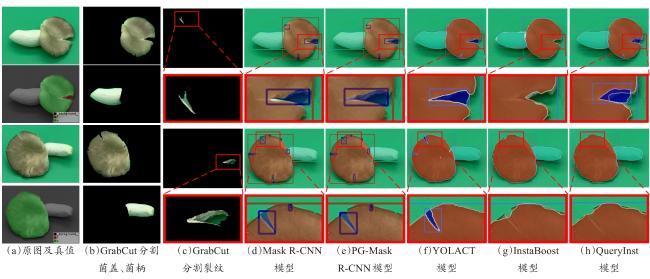

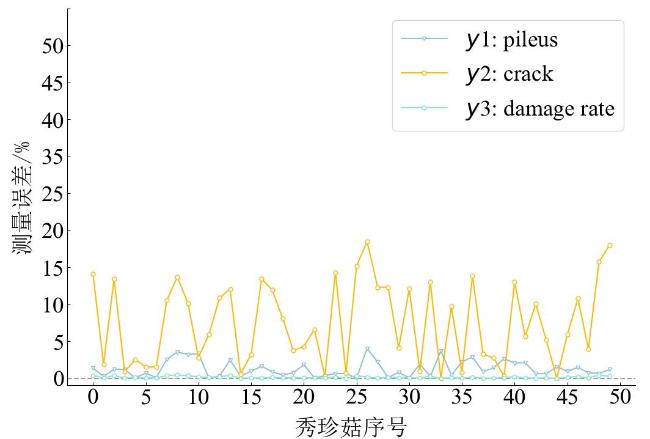

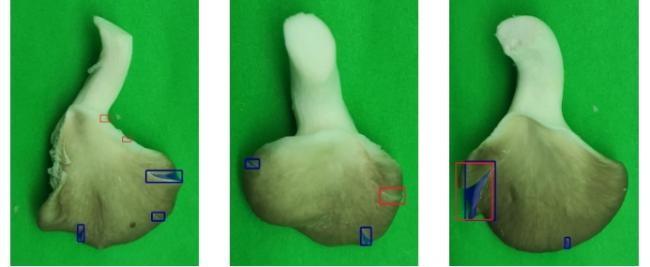

[Objective] Pleurotus geesteranus is a rare edible mushroom with a fresh taste and rich nutritional elements, which is popular among consumers. It is not only cherished for its unique palate but also for its abundant nutritional elements. The phenotype of Pleurotus geesteranus is an important determinant of its overall quality, a specific expression of its intrinsic characteristics and its adaptation to various cultivated environments. It is crucial to select varieties with excellent shape, integrity, and resistance to cracking in the breeding process. However, there is still a lack of automated methods to measure these phenotype parameters. The method of manual measurement is not only time-consuming and labor-intensive but also subjective, which lead to inconsistent and inaccurate results. Thus, the traditional approach is unable to meet the demand of the rapid development Pleurotus geesteranus industry. [Methods] To solve the problems which mentioned above, firstly, this study utilized an industrial-grade camera (Daheng MER-500-14GM) and a commonly available smartphone (Redmi K40) to capture high-resolution images in DongSheng mushroom industry (Jiujiang, Jiangxi province). After discarding blurred and repetitive images, a total of 344 images were collected, which included two commonly distinct varieties, specifically Taixiu 57 and Gaoyou 818. A series of data augmentation algorithms, including rotation, flipping, mirroring, and blurring, were employed to construct a comprehensive Pleurotus geesteranus image dataset. At the end, the dataset consisted of 3 440 images and provided a robust foundation for the proposed phenotype recognition model. All images were divided into training and testing sets at a ratio of 8:2, ensuring a balanced distribution for effective model training. In the second part, based upon foundational structure of classical Mask R-CNN, an enhanced version specifically tailored for Pleurotus geesteranus phenotype recognition, aptly named PG-Mask R-CNN (Pleurotus geesteranus-Mask Region-based Convolutional Neural Network) was designed. The PG-Mask R-CNN network was refined through three approaches: 1) To take advantage of the attention mechanism, the SimAM attention mechanism was integrated into the third layer of ResNet101feature extraction network after analyzing and comparing carefully, it was possible to enhance the network's performance without increasing the original network parameters. 2) In order to avoid the problem of Mask R-CNN's feature pyramid path too long to split low-level feature and high-level feature, which may impair the semantic information of the high-level feature and lose the positioning information of the low-level feature, an improved feature pyramid network was used for multiscale fusion, which allowed us to amalgamate information from multiple levels for prediction. 3) To address the limitation of IoU (Intersection over Union) bounding box, which only considered the overlapping area between the prediction box and target box while ignoring the non-overlapping area, a more advanced loss function called GIoU (Generalized Intersection over Union) was introduced. This replacement improved the calculation of image overlap and enhanced the performance of the model. Furthermore, to evaluate crack state of Pleurotus geesteranus more scientifically, reasonably and accurately, the damage rate as a new crack quantification evaluation method was introduced, which was calculated by using the proportion of cracks in the complete pileus of the mushroom and utilized the MRE (Mean Relative Error) to calculate the mean relative error of the Pleurotus geesteranus's damage rate. Thirdly, the PG-Mask R-CNN network was trained and tested based on the Pleurotus geesteranus image dataset. According to the detection and segmentation results, the measurement and accuracy verification were conducted. Finally, considering that it was difficult to determine the ground true of the different shapes of Pleurotus geesteranus, the same method was used to test 4 standard blocks of different specifications, and the rationality of the proposed method was verified. [Results and Discussions] In the comparative analysis, the PG-Mask R-CNN model was superior to Grabcut algorithm and other 4 instance segmentation models, including YOLACT (You Only Look At Coefficien Ts), InstaBoost, QueryInst, and Mask R-CNN. In object detection tasks, the experimental results showed that PG-Mask R-CNN model achieved a mAP of 84.8% and a mAR (mean Average Recall) of 87.7%, respectively, higher than the five methods were mentioned above. Furthermore, the MRE of the instance segmentation results was 0.90%, which was consistently lower than that of other instance segmentation models. In addition, from a model size perspective, the PG-Mask R-CNN model had a parameter count of 51.75 M, which was slightly larger than that of the unimproved Mask R-CNN model but smaller than other instance segmentation models. With the instance segmentation results on the pileus and crack, the MRE were 1.30% and 7.54%, respectively, while the MAE of the measured damage rate was 0.14%. [Conclusions] The proposed PG-Mask R-CNN model demonstrates a high accuracy in identifying and segmenting the stipe, pileus, and cracks of Pleurotus geesteranus. Thus, it can help the automated measurements of phenotype measurements of Pleurotus geesteranus, which lays a technical foundation for subsequent intelligent breeding, smart cultivation and grading of Pleurotus geesteranus.