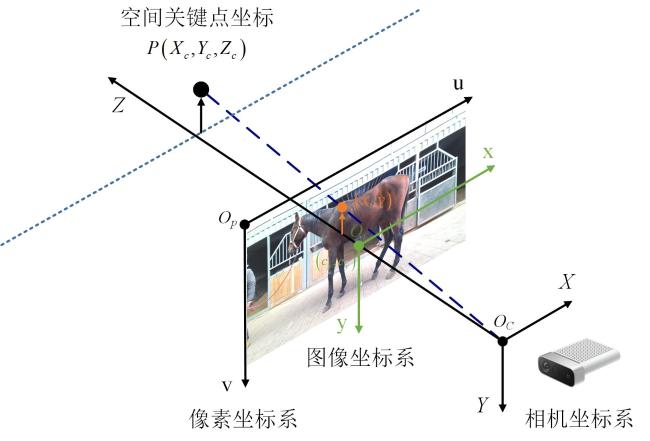

随着现代测试技术不断发展,运用先进技术获取马匹体尺参数并评估其形态特征,以制定育种计划成为当下的主流研究方向

[7-9]。Kristjansson等

[10]对影响冰岛马的骑行能力的不同形态特征的遗传关系进行评估,结果表明,可通过育种方式改进体型性状以达到提高冰岛马的骑行能力。Pallottino等

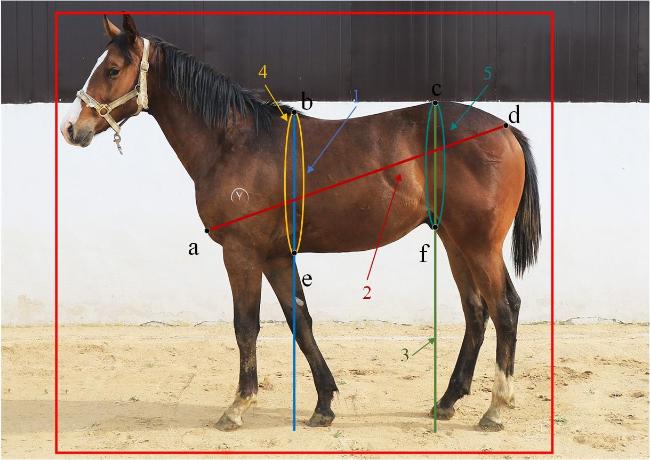

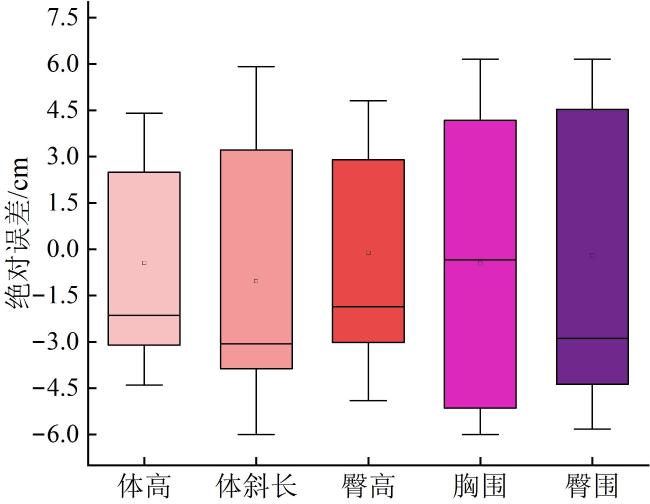

[11]使用立体视觉系统,通过手动方式测量利比赞马的体尺参数,结果显示测量误差小于3%。Gmel等

[12]使用tpsDig2图像分析工具由操作人员手动测量提取弗赖伯格马的各项体尺参数,并采用限制性最大似然模型估计体尺参数的遗传率。Pérez-Ruiz等

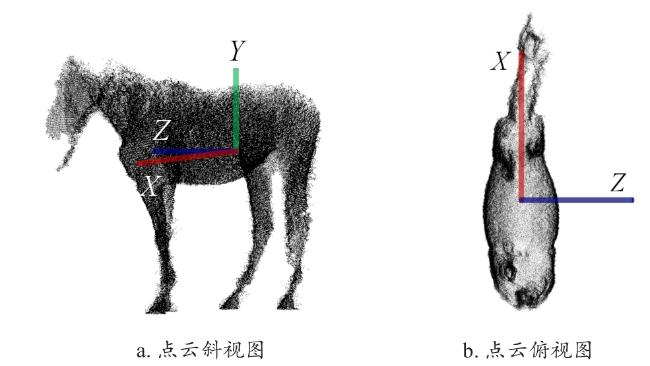

[13]采用LiDAR(Light Laser Detection and Ranging)传感器记录安达卢西亚马侧面信息并进行三维重建操作,通过手动缩放的方式测量体尺参数,得到人工测量值与三维重建测量值的平均相关系数为0.55。Freitag等

[14]研究在美国夸特马左侧放置标记物,并结合ImageJ图像分析软件,通过人工标记的方式测量相应的体尺参数,测量结果平均相对误差小于1.5%。上述研究表明,通过图像处理方法获取体尺参数并用于马匹育种计划的制定是可行的。然而,上述方法主要依赖于人工手动选择测量点,过程复杂且自动化程度低。快速、精准、高效的测量方法已成为推进马匹育种进程的关键手段。