通过图像分析和深度学习算法,可以准确地估计器官的数量和密度,为作物产量预测提供了基础。作物器官自动检测主要采用快速区域卷积神经网络(Faster Region-Based Convolutional Neural Network, Faster R-CNN)、YOLO(You Only Look Once)、CenterNet等目标检测方法或者U-Net等图像分割方法对作物的麦穗、稻穗、豆荚、雄穗等器官进行检测或分割,并统计器官的数量,为作物产量预测提供支撑。Maji等

[34]将Mask R-CNN和U-Net相结合,研究了一种新的SlypNet方法,可以从小麦植株的视觉图像中提取植物形态特征,如穗子和小穗,准确率高达97.57%。Liu等

[35]基于YOLOX提出了MRF-YOLO,可以用于小目标作物检测,在田间条件下对棉花棉铃进行检测,平均精度达到92.75%。Song等

[36]使用R-CNN模型对玉米穗姿态进行检测,采用Look Twice 方法用于玉米穗部姿态信息提取,准确率为88.56%。Wang等

[37]提出了一种基于深度学习的水稻穗检测与计数方法,用于在大图像尺寸的稻田图像中检测水稻穗,对比了不同检测模型,其中YOLOv5准确率为92.77%。Han等

[38]提出InceptionV3-LSTM的深度学习网络,用手机拍摄3个品种田间油菜籽图像,对油菜籽果实期的田间图像进行分析,建立产量分类预测模型,准确率达到96%。Zhao等

[39]提出了一种小米穗百分比估计方法,使用Faster-RCNN模型以应对存在多个分蘖的问题,准确率达到92.4%。Maimaitijiang等

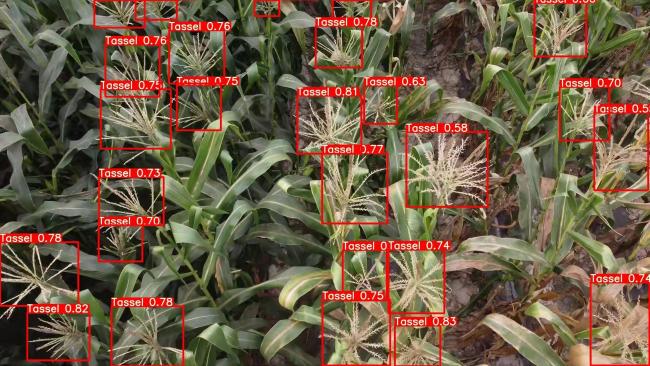

[40]基于无人机的多模态数据融合的能力,使用RGB、多光谱和热传感器在深度神经网络(Deep Neural Networks, DNN)框架内估计大豆产量,发现多模态数据融合提高了产量预测精度,对空间变化的适应性更强,DNN的模型在空间上表现出一致的性能,空间依赖性和变化较小,准确率达到91.30%。中国农业科学院智慧化数字化南繁技术团队在玉米雄穗检测中,构建了ESG-YOLO检测模型,实现了无人机视角下的雄穗器官检测,平均精度均值(Mean Average Precision, mAP)为93.1%,相比较YOLOv7模型的mAP提高2.3%,并且在低分辨率玉米图像和小目标检测方面效果极佳;同时,对叶片遮挡、强光照、生长密集条件、雄穗未成熟等田间环境复杂多样条件下,均能有效检测玉米雄穗,还能对玉米雄穗密度自动评估,效果如

图3所示。