随着人工智能和自动化技术应用的快速发展,使用成本较低且能够克服人工的消毒死角问题的畜禽养殖自动导航喷药机器人成为了研究热点,促使畜禽养殖向着自动化、智能化、高效化、可持续化方向发展。Adams等

[2]开发了一款牧场环卫机器人,使用了无迹卡尔曼滤波法(Unscented Kalman Filter, UKF)来使用传感器的位置估计来实现机器人的定位,使用UBlox的GPS里程计和激光雷达来实现机器人的自主导航;Muthugala等

[3]针对畜禽舍墙体消毒的难题,提出了非单例1型模糊逻辑系统(T1-FLS)和非单例间隔2型模糊逻辑系统(IT2-FLS)来实现消毒机器人的墙体跟随;Patel等

[4]提出了一种消毒机器人,使用紫外线消毒技术,保证机器人的消毒范围可以覆盖360°,采用Raspberry Pi嵌入式系统,可以在机器人运行时提供导航和避障的功能;Bijay等

[5]提出了一种机器人的自主导航系统,使用纯跟踪算法进行机器人的自主导航,矢量场直方图用于机器人的避障,二维激光雷达(Light Detection and Ranging, LiDAR)辅助机器人避障;Navone等

[6]提出了一种基于分割的自主导航方法来解决在遮挡情况下GPS信号受阻的问题,使用RGB-D(RGB+Depth Map)的深度帧数据来处理输出的分割掩码,对比了基于直方图最小搜索的SegMin、SegMinD和SegZeros方法对语义分割算法精度的提升程度。鞠庆等

[7]开发了一种消毒防疫机器人,使用无迹卡尔曼滤波法与二维LiDAR进行室内的定位与建图。冯青春等

[8]针对畜禽舍内的恶劣环境,提出了Magnet-RFID(Magnet-Radio Frequency Identification)路径导航方法,设计了基于流体仿真的喷嘴,并使用CFD(Computational Fluid Dynamics)仿真技术

[9]基于Ansys Fluent对机器人的喷药效果进行了仿真。徐济双等

[10]分析了传统A*算法的不足之处,提出了一种改变权值的A*算法,结合模糊PID(Fuzzy Proportional Intergral Derivative)进行巡线控制,实现了病死畜禽运输机器人的自主路径规划。朱立学等

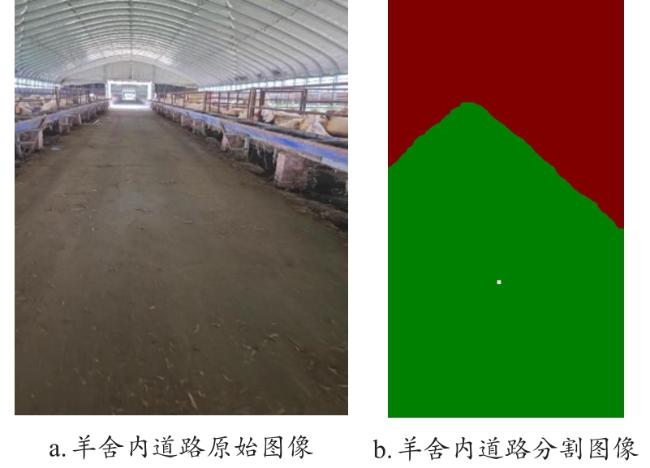

[11]设计了基于U-Net的导航路径识别方法,用于肉鸽养殖场内道路的分割,采用等比例法获取稀疏的导航点,并将这些导航点通过最小二乘法拟合成直线来作为机器人的导航线;宋怀波等

[12]设计了一种基于激光SLAM(Simultaneous Localization and Mapping)的导航方法用于牛场智能推翻草机器人的自主导航,使用了Cartographer算法来构建环境地图,通过自适应MCL(Markov Clustering)算法来实现机器人的定位,并采用了Dijkstra算法来规划机器人推翻草的导航路径。羊舍的环境复杂,包括不规则的地形、泥泞或多尘的路径,以及不同的天气条件,为自动导航喷药机器人带来了巨大的挑战。