以上基于目标轮廓纹理和颜色等信息的传统算法普遍存在稳定性差、适配性低等问题,难以适应动态天气条件。机器学习技术的发展,尤其是深度卷积神经网络的应用,为葡萄目标识别提供了新的方法

[11]。Cecotti等

[12]提出了一种基于迁移学习的卷积神经网络,葡萄检测准确率为99%。深度学习在检测葡萄过程中,可以有效降低外界因素的影响

[13]。当下,基于深度学习的目标检测模型主要分为两大类:一类是以Fast Region-based Convolutional Network

[14]、Faster R-CNN

[15]、Cascade R-CNN

[16]和Libra R-CNN

[17]为代表的二阶段目标检测模型。朱旭等

[18]基于Faster R-CNN模型对不同成熟度的蓝莓果实进行了准确识别,成熟、半成熟、未成熟果实的检测精确度分别为97%、95%和92%,但平均检测时间为0.25 s,实用性较低。另一类是单阶段网络,使用单个CNN网络对输入图像进行回归预测,在预测目标类别的过程中生成用于定位的边界框。这种类型的代表性网络有Single Shot MultiBox Detector(SSD)

[19]、RetinaNet

[20]、EfficientDet

[21]和You Only Look Once(YOLO)

[22-25]等,在单阶段目标检测模型中,目标定位和分类是同步进行的,所以检测速度较快。Moreira等

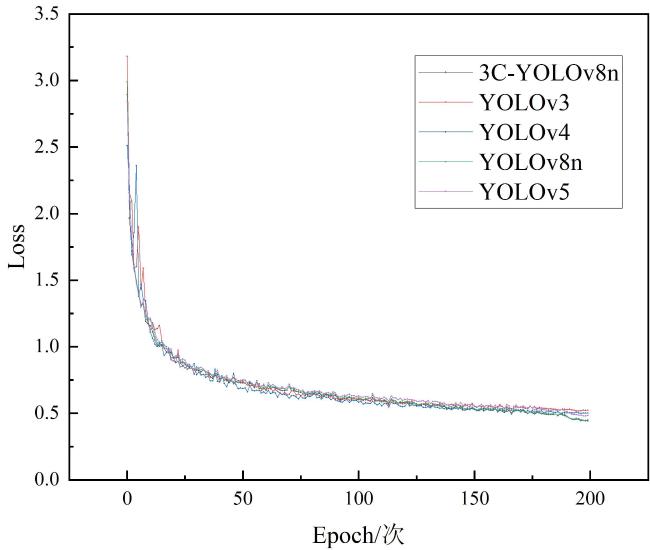

[26]比较了YOLOv4和SSD对番茄的检测能力,发现YOLOv4表现更好,

F 1分数为85.81%。Su等

[27]提出了一种基于YOLO的轻量化模型,其主干采用Uniform,颈部采用加权双向特征金字塔网络(Bidirectional Feature Pyramid Network, Bi-FPN)结构,在Wine Grape Instance Segmentation Dataset(WGISD)中的平均精度均值(Mean Average Precision, mAP)为87.7%,

F 1分数为83.1%,每秒帧数(Frames Per Second, FPS)为46。