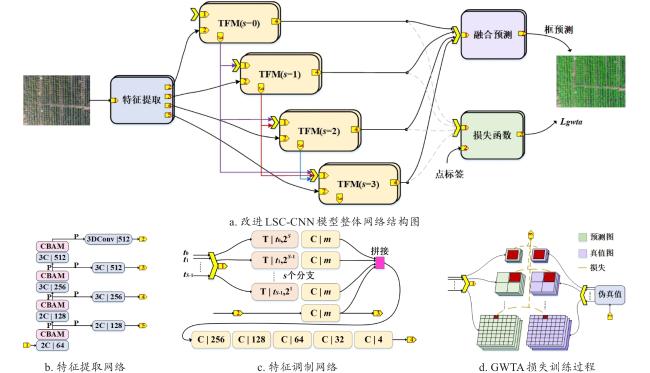

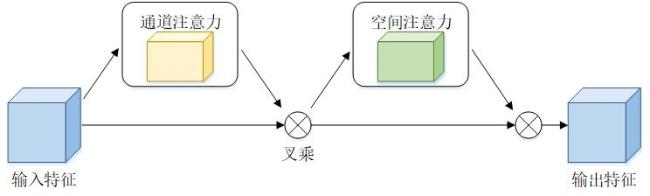

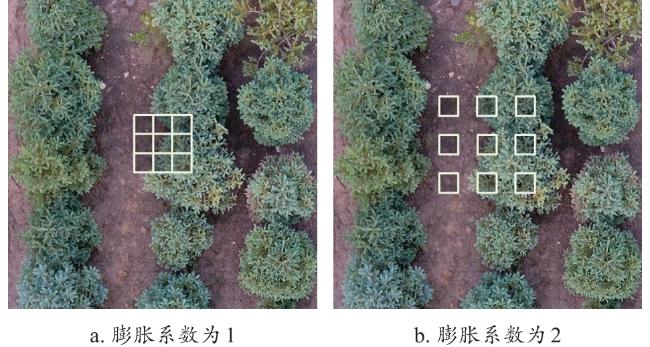

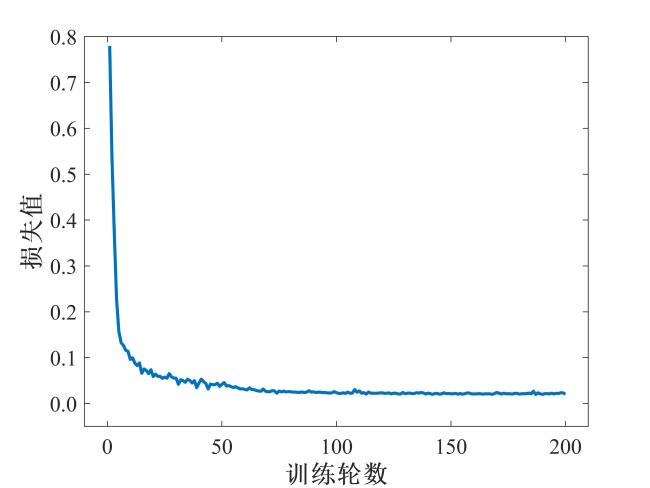

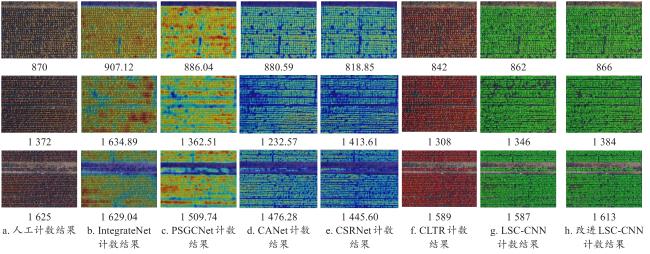

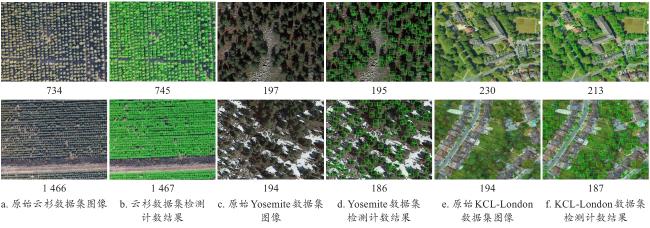

[Objective] The number, location, and crown spread of nursery stock are important foundations data for their scientific management. Traditional approach of conducting nursery stock inventories through on-site individual plant surveys is labor-intensive and time-consuming. Low-cost and convenient unmanned aerial vehicles (UAVs) for on-site collection of nursery stock data are beginning to be utilized, and the statistical analysis of nursery stock information through technical means such as image processing achieved. During the data collection process, as the flight altitude of the UAV increases, the number of trees in a single image also increases. Although the anchor box can cover more information about the trees, the cost of annotation is enormous in the case of a large number of densely populated tree images. To tackle the challenges of tree adhesion and scale variance in images captured by UAVs over nursery stock, and to reduce the annotation costs, using point-labeled data as supervisory signals, an improved dense detection and counting model was proposed to accurately obtain the location, size, and quantity of the targets. [Method] To enhance the diversity of nursery stock samples, the spruce dataset, the Yosemite, and the KCL-London publicly available tree datasets were selected to construct a dense nursery stock dataset. A total of 1 520 nursery stock images were acquired and divided into training and testing sets at a ratio of 7:3. To enhance the model's adaptability to tree data of different scales and variations in lighting, data augmentation methods such as adjusting the contrast and resizing the images were applied to the images in the training set. After enhancement, the training set consists of 3 192 images, and the testing set contains 456 images. Considering the large number of trees contained in each image, to reduce the cost of annotation, the method of selecting the center point of the trees was used for labeling. The LSC-CNN model was selected as the base model. This model can detect the quantity, location, and size of trees through point-supervised training, thereby obtaining more information about the trees. The LSC-CNN model was made improved to address issues of missed detections and false positives that occurred during the testing process. Firstly, to address the issue of missed detections caused by severe adhesion of densely packed trees, the last convolutional layer of the feature extraction network was replaced with dilated convolution. This change enlarges the receptive field of the convolutional kernel on the input while preserving the detailed features of the trees. So the model is better able to capture a broader range of contextual information, thereby enhancing the model's understanding of the overall scene. Secondly, the convolutional block attention module (CBAM) attention mechanism was introduced at the beginning of each scale branch. This allowed the model to focus on the key features of trees at different scales and spatial locations, thereby improving the model's sensitivity to multi-scale information. Finally, the model was trained using label smooth cross-entropy loss function and grid winner-takes-all strategy, emphasizing regions with highest losses to boost tree feature recognition. [Results and Discussions] The mean counting accuracy (MCA), mean absolute error (MAE), and root mean square error (RMSE) were adopted as evaluation metrics. Ablation studies and comparative experiments were designed to demonstrate the performance of the improved LSC-CNN model. The ablation experiment proved that the improved LSC-CNN model could effectively resolve the issues of missed detections and false positives in the LSC-CNN model, which were caused by the density and large-scale variations present in the nursery stock dataset. IntegrateNet, PSGCNet, CANet, CSRNet, CLTR and LSC-CNN models were chosen as comparative models. The improved LSC-CNN model achieved MCA, MAE, and RMSE of 91.23%, 14.24, and 22.22, respectively, got an increase in MCA by 6.67%, 2.33%, 6.81%, 5.31%, 2.09% and 2.34%, respectively; a reduction in MAE by 21.19, 11.54, 18.92, 13.28, 11.30 and 10.26, respectively; and a decrease in RMSE by 28.22, 28.63, 26.63, 14.18, 24.38 and 12.15, respectively, compared to the IntegrateNet, PSGCNet, CANet, CSRNet, CLTR and LSC-CNN models. These results indicate that the improved LSC-CNN model achieves high counting accuracy and exhibits strong generalization ability. [Conclusions] The improved LSC-CNN model integrated the advantages of point supervision learning from density estimation methods and the generation of target bounding boxes from detection methods.These improvements demonstrate the enhanced performance of the improved LSC-CNN model in terms of accuracy, precision, and reliability in detecting and counting trees. This study could hold practical reference value for the statistical work of other types of nursery stock.