第1类为侧视视角。通常是定位奶牛蹄子、背部脊柱、头颈和头部等关键区域进行单一特征或联动特征融合来实现奶牛跛行检测

[8-10]。Wu等

[11]提出一种基于YOLO(You Only Look Once)v3深度学习算法和相对步长特征向量的奶牛跛行检测技术。首先根据YOLOv3网络定位奶牛的四肢,将前后肢的质心距离变化提取成特征向量,再输送给长短期记忆网络(Long Short-Term Memory, LSTM)网络进行跛行预测。由于跛行奶牛需要弓背来负担发生跛行病情时行走过程中的疼痛,因此跛行奶牛的背部弯曲程度往往偏大。Jiang等

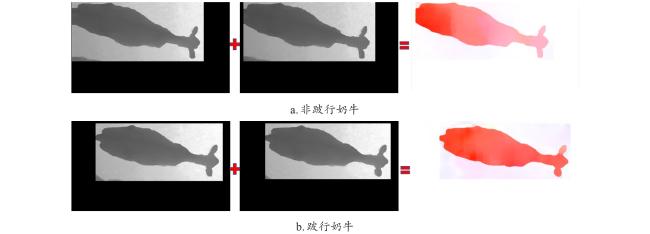

[12]提出了一种基于深度学习方法的计算背部曲率的奶牛跛行识别技术。首先通过目标检测定位出奶牛背部区域,然后通过帧间差分法提取出去除背景的奶牛背部脊柱区域,通过三点圆法计算出奶牛背部的曲率并作为特征值,输送给双向长短期记忆(Bidirectional Long Short-Term Memory, BiLSTM)网络进行训练,得到跛行与非跛行奶牛的二分类结果,在567段视频上的分类精度达到96.61%。跛行奶牛行走时蹄部往往由于疼痛承重能力下降而导致步态不规律性。Kang等

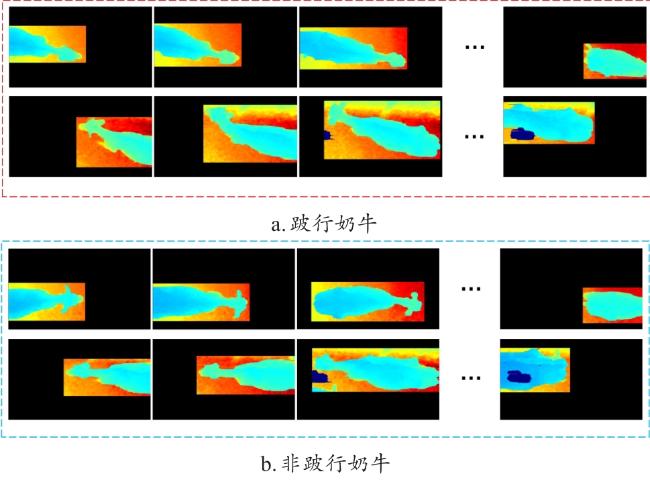

[13]提出了一种奶牛跛行检测方法,通过降维的基于牛腿位置的时空图像,保留步态信息,使用DenseNet算法根据时空图像进行跛行分类,精度达到了98.5%。Zheng等

[8]提出一种孪生注意力模型来实现奶牛腿部自动跟踪,通过注意力机制预测后续帧的牛腿的位置,并利用牛腿坐标计算相对步长,利用支持向量机(Support Vector Machine, SVM)模型实现奶牛跛行分类。Li等

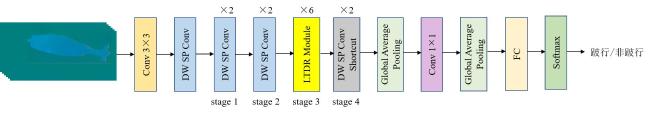

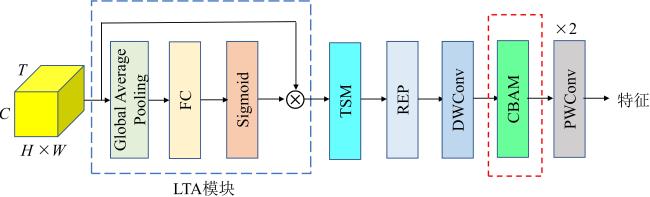

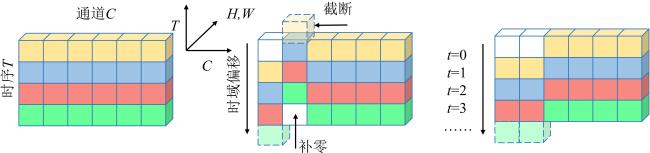

[9]提出了一种利用微小运动特征的时空聚合网络,通过设计的模块捕捉奶牛运动时的微小运动特征和时空特征来进行奶牛早期跛行的识别。针对奶牛跛行的步态不对称性,Li等

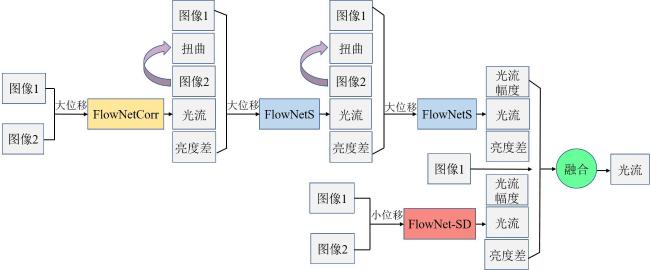

[14]提出了一种基于RGB、光流和骨骼等多种特征的奶牛跛足检测方法,根据不同的输入将网络分为3个分支:对于分支1和分支3,使用卷积神经网络(Convolutional Neural Networks, CNN)根据输入图像和光流预测跛行;对于分支2,使用时空图卷积网络用于根据奶牛的骨骼预测跛足;最后调整权重,融合这3个分支的预测分数,最佳准确度达到了97.2%。然而,奶牛在牧场中的运动往往是成群结队地行走,当多头奶牛并排行走时,远离相机一侧的奶牛由于被其他奶牛或者栏杆遮挡从而导致相机无法有效地捕获相应的图像。因此,在牧场环境下侧视视角检测跛行奶牛时出现的遮挡问题,是阻碍检测方法应用的主要原因之一。