0 引 言

1 数据集构建

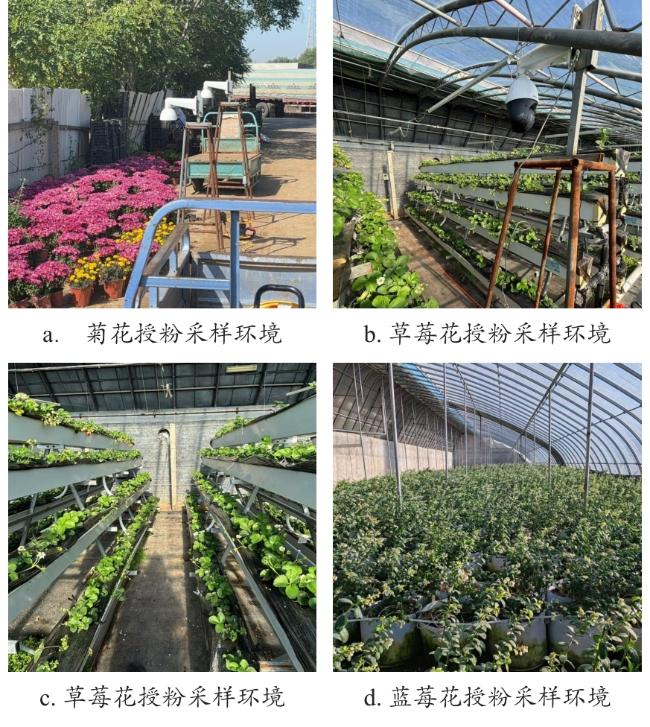

1.1 图像获取

1.2 数据集标注

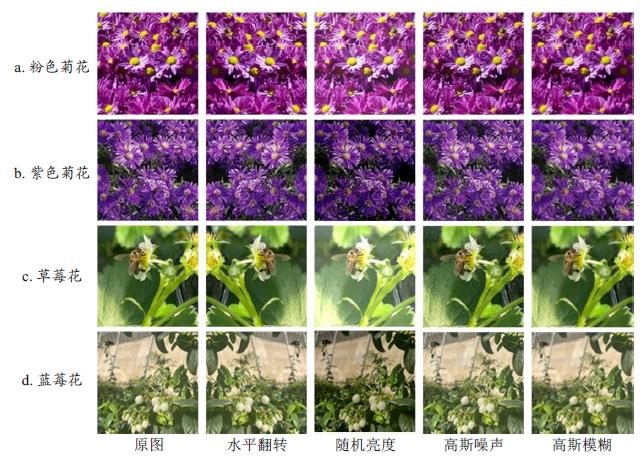

1.3 数据扩充

表1 草莓花蜜蜂授粉数据集类别目标数Table 1 Analysis of target number categories in strawberry flower bee pollination dataset |

| 目标类别 | 增强前训练集目标数/个 | 增强后训练集目标数/个 |

|---|---|---|

| 所有 | 1 092 | 18 564 |

| 花朵 | 832 | 14 144 |

| 授粉蜜蜂 | 168 | 2 856 |

| 飞行蜜蜂 | 92 | 1 564 |

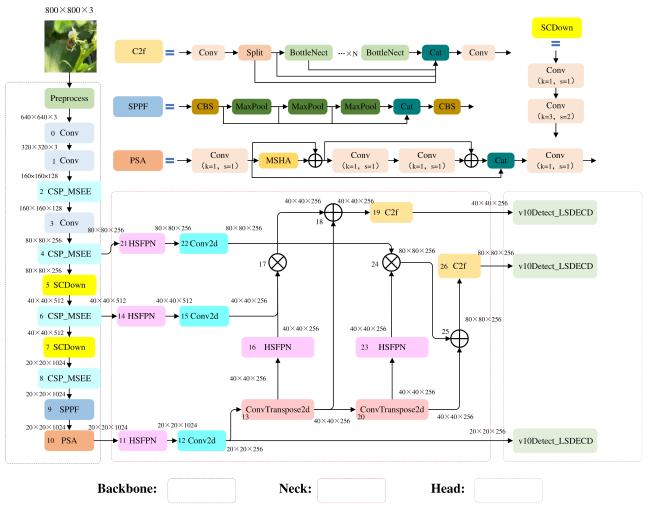

2 YOLOv10n-CHL

2.1 CSP_MSEE模块设计

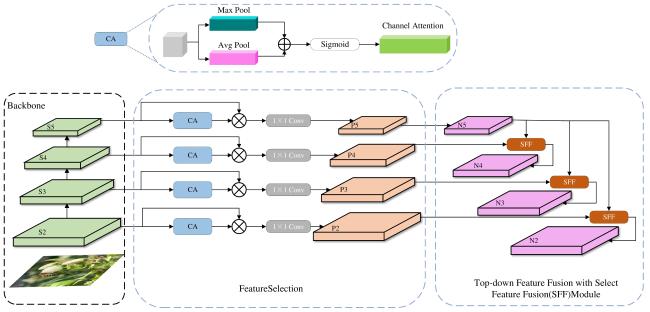

2.2 HS-FPN

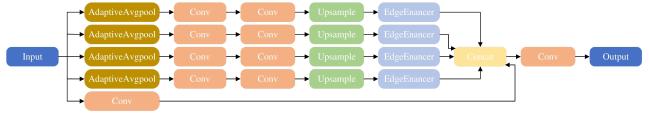

2.2.1 特征选择模块

2.2.2 特征融合模块

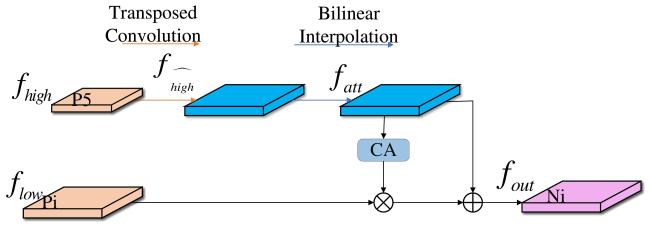

2.3 LSDECD检测头

3 结果与分析

3.1 训练环境与方法

3.2 评级指标

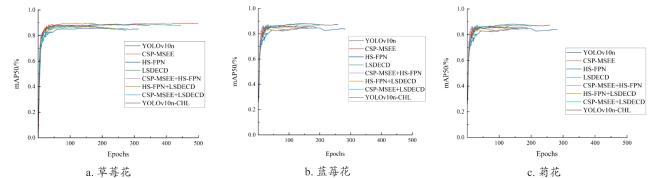

3.3 消融实验

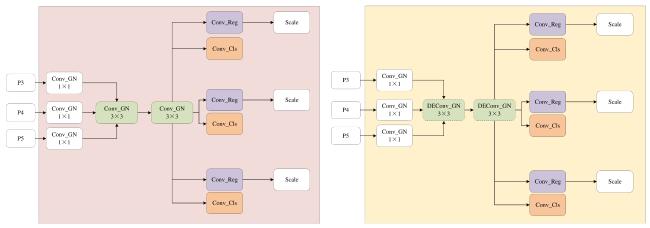

3.4 对比实验

3.4.1 YOLOv10n-CHL与其他模型性能对比

表2 不同数据集的蜜蜂授粉识别研究对比实验结果Table 2 Comparative experimental results of bee pollination recognition studies across different datasets |

| 模型 | 召回率 | mAP50/% | 计算效率/G | 参数量/M | ||||

|---|---|---|---|---|---|---|---|---|

| 草莓 | 蓝莓 | 菊花 | 草莓 | 蓝莓 | 菊花 | |||

| YOLOv7tiny | 81.9 | 83.6 | 84.3 | 86.4 | 88.1 | 85.7 | 13.2 | 6.0 |

| YOLOv8n | 82.4 | 83.1 | 83.7 | 86.4 | 87.6 | 86.1 | 8.2 | 3.0 |

| YOLOv11n | 82.2 | 82.9 | 84.1 | 88.7 | 86.3 | 84.4 | 6.3 | 2.5 |

| YOLOv12n | 78.4 | 83.3 | 81.6 | 87.3 | 86.4 | 85.2 | 6.3 | 2.5 |

| Faster-Rcnn | 76.2 | 71.9 | 75.1 | 80.7 | 78.3 | 79.6 | 141.3 | 41.3 |

| SSD | 70.9 | 66.5 | 69.5 | 74.8 | 73 | 70.6 | 90.8 | 23.8 |

| YOLOv10n-CHL | 82.6 | 84 | 84.8 | 89.3 | 89.5 | 88 | 5.1 | 1.3 |

|

3.4.2 YOLOv10n改进前后性能对比

表3 YOLOv10n改进前后在蜜蜂授粉检测任务中的对比分析Table 3 A comparative study of improved and baseline YOLOv10n on bee pollination detection pollination detection task |

| 模型 | 召回率(Recall) | mAP50/% | FLOPs/G | 参数量/M | ||||

|---|---|---|---|---|---|---|---|---|

| 草莓 | 蓝莓 | 菊花 | 草莓 | 蓝莓 | 菊花 | |||

| YOLOv10n | 80.5 | 82 | 82.7 | 87.6 | 86.9 | 85.8 | 8.2 | 2.6 |

| YOLOv10n-CHL | 82.6 | 84 | 84.8 | 89.3 | 89.5 | 88 | 5.1 | 1.3 |

3.4.3 数据类别不平衡实验

表4 不同数据平衡策略下草莓花数据集目标检测模型性能对比Table 4 Performance comparison of object detection models for strawberry flower datasets under different data balancing strategies |

| 目标类别 | R(原数据) | R(Focalloss) | R(增广16倍) | mAP50/%(原数据) | mAP50/%(Focalloss) | mAP50/%(增广16倍) |

|---|---|---|---|---|---|---|

| 飞行蜜蜂类 | 66.6 | 63.9 | 59.4 | 72.2 | 68.8 | 74.7 |

| 授粉蜜蜂类 | 87.5 | 73.2 | 87.9 | 90.1 | 84.1 | 92.4 |

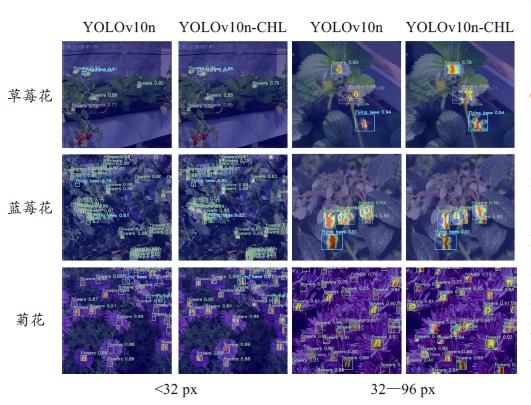

3.5 可视化实验分析

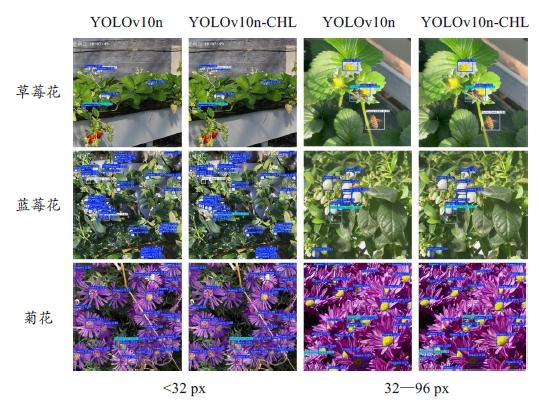

3.5.1 检测结果可视化

表5 改进前后模型在像素小于32 px目标尺寸下的检测结果Table 5 Detection results of original and improved models for targets less than 32 pixels in size |

| 数据类别 | YOLOv10n | YOLOv10n-CHL | ||||||

|---|---|---|---|---|---|---|---|---|

| All | TP | FN | FP | All | TP | FN | FP | |

| 草莓花 | 7 | 7 | 0 | 0 | 7 | 7 | 0 | 0 |

| 蓝莓花 | 45 | 38 | 1 | 6 | 45 | 41 | 0 | 4 |

| 菊花 | 27 | 26 | 0 | 1 | 27 | 26 | 0 | 1 |

表6 改进前后模型像素在32~96 px目标尺寸下的检测结果Table 6 Detection results of original and improved models for targets of 32 to 96 pixels in size |

| 数据类别 | YOLOv10n | YOLOv10n-CHL | ||||||

|---|---|---|---|---|---|---|---|---|

| All | TP | FN | FP | All | TP | FN | FP | |

| 草莓花 | 4 | 4 | 0 | 0 | 4 | 4 | 0 | 0 |

| 蓝莓花 | 10 | 9 | 0 | 1 | 10 | 9 | 0 | 1 |

| 菊花 | 29 | 28 | 1 | 0 | 29 | 29 | 0 | 0 |

表7 改进前后模型在目标像素小于16 px尺寸下的检测结果Table 7 Detection results of original and improved models for targets less than 16 px in size |

| 数据类别 | APtiny/%(YOLOv10n) | APtiny/%(YOLOv10n-CHL) |

|---|---|---|

| 草莓花 | 70 | 71.2 |

| 蓝莓花 | 55.2 | 59.6 |

| 菊花 | 68.5 | 70.4 |