由于小目标的有效像素少、尺度小,缺乏特征表达能力,其检测一直是目标检测中的难点。已有众多研究者从不同角度设计优化检测模型

[4]以提高小目标的检测性能。有的优化和改进主干网络结构

[5-11]以提取更丰富的特征,有的优化锚框

[12-17]以提高目标的定位精度,有的优化损失函数

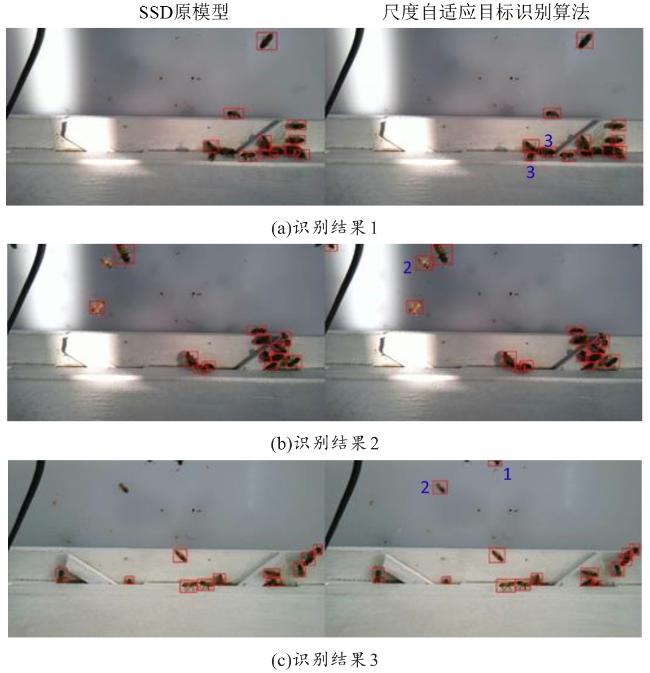

[18-20]以提高模型的训练效率和模型性能,这些改进方法能一定程度地提高对小目标的识别性能。然而,小目标的像素少且尺度小是造成其识别性能较差的根本原因。增加小目标的有效像素数以及增加其尺度是改善其识别性能的主要途径。同时,由于网络输出层包含全连接层,当前的网络模型大多都会对输入图像归一化至标准尺度,如快速区域卷积神经网络(Faster-Regions with Convolutional Neural Network,Faster-RCNN)

[21]和SSD(Single Shot MultiBox Detector)

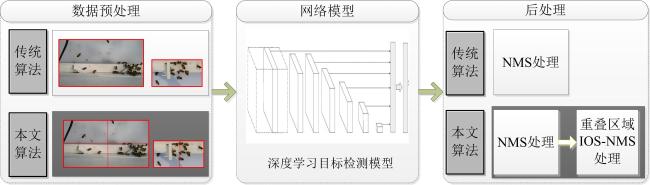

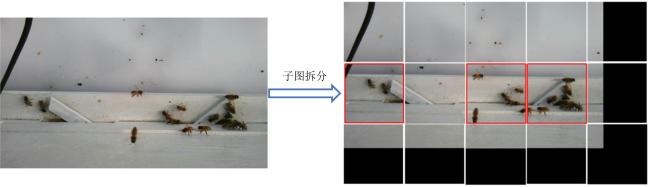

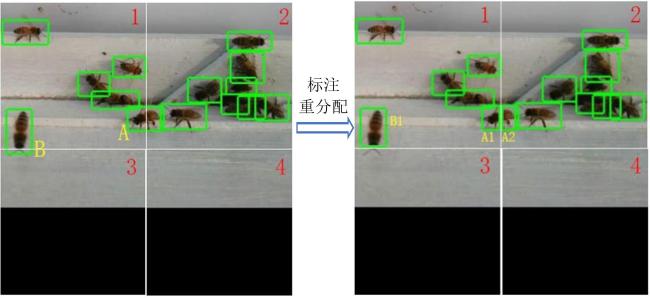

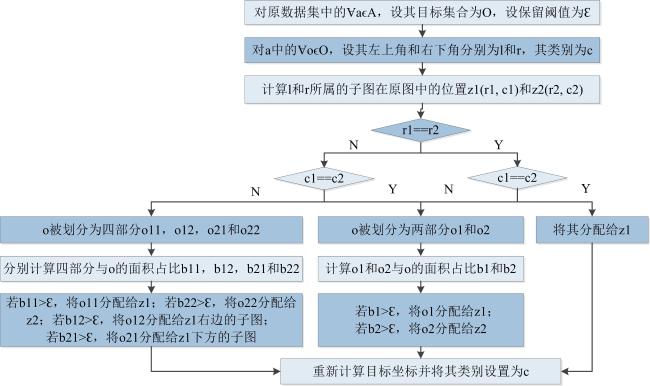

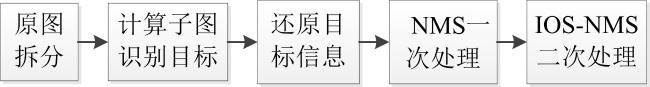

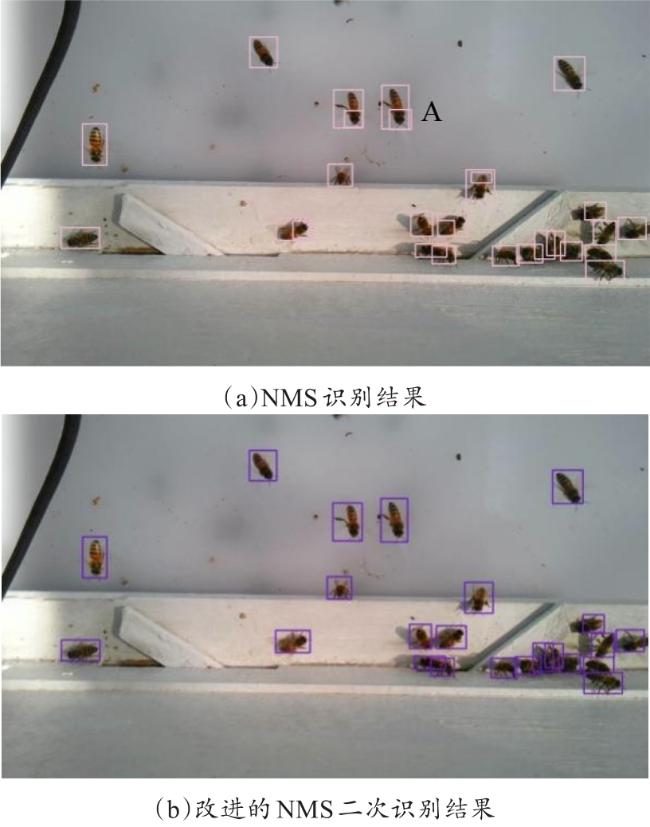

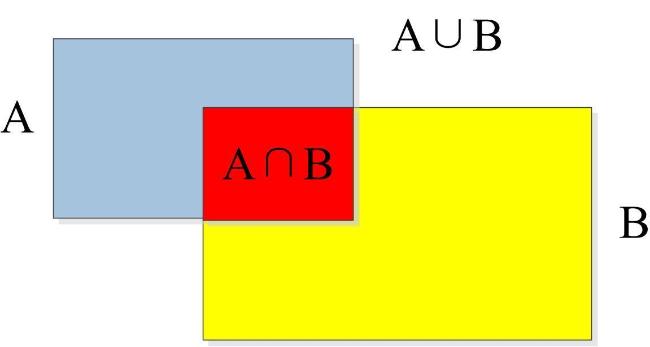

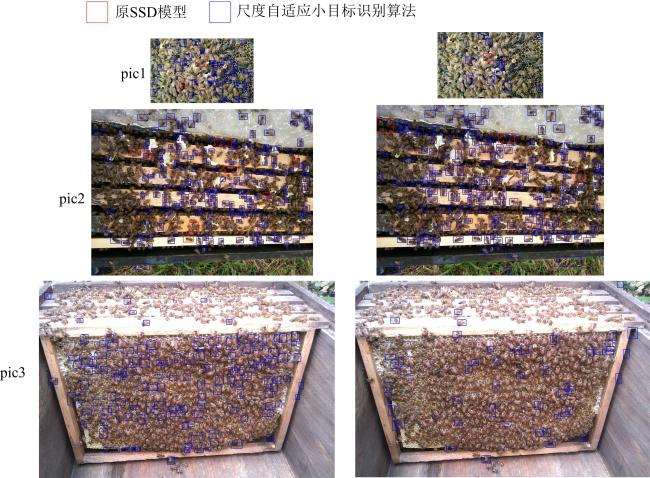

[22]。归一化处理会导致图像尺寸进一步缩小,目标的有效像素进一步减少,增加了小目标识别的难度。提高输入图像中的小目标的尺度,增加小目标的像素个数,有利于充分提取其特征并提高其识别性能。已有的方法大多通过优化模型提高小目标的识别性能,较少从提高小目标的尺度(目标像素数与整体图像像素数的比值)出发进行研究。本研究着眼于影响小目标识别性能不高的本质原因——有效像素少且尺度小,通过图像拆分的方法简单有效地提高小目标的尺度,以期提高其识别性能。