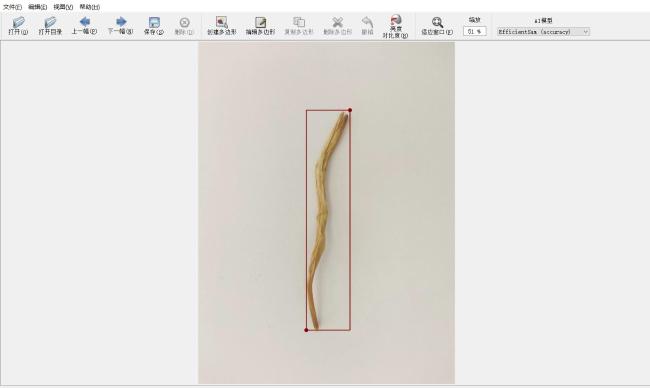

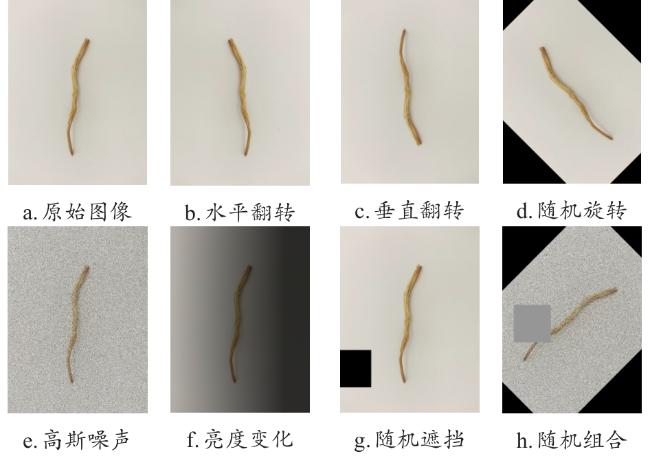

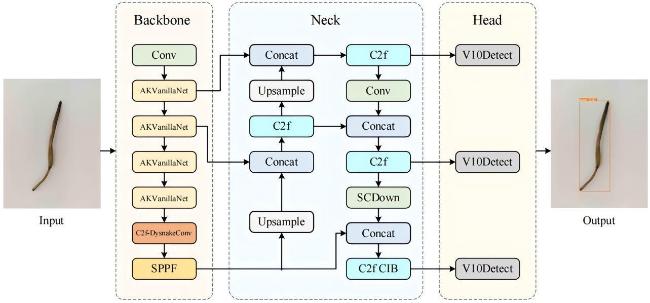

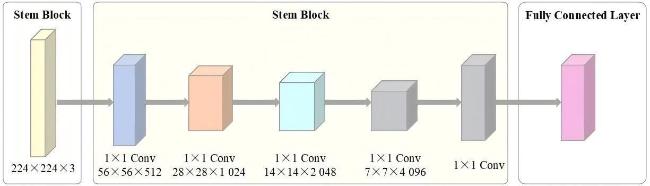

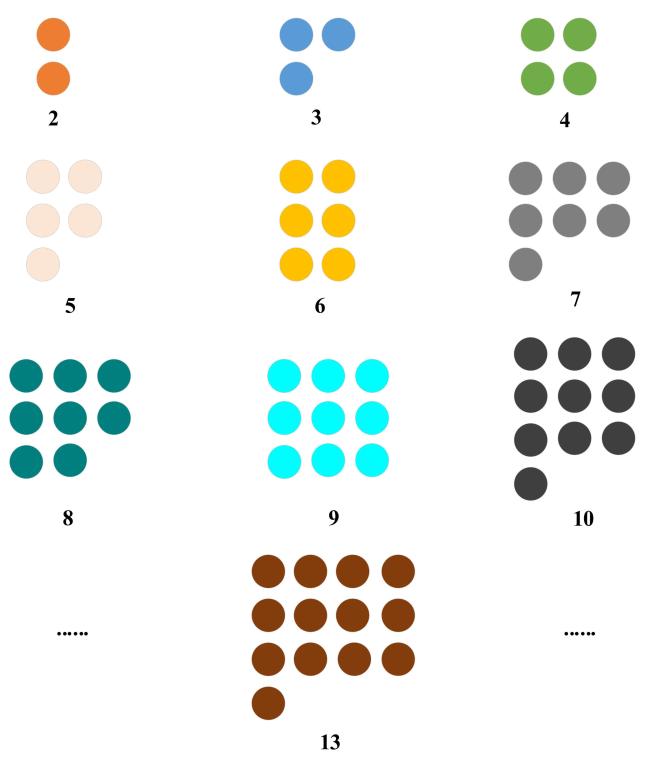

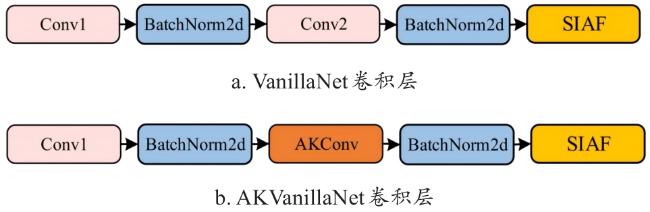

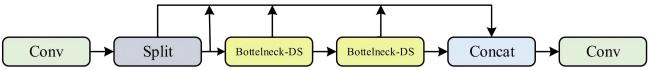

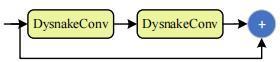

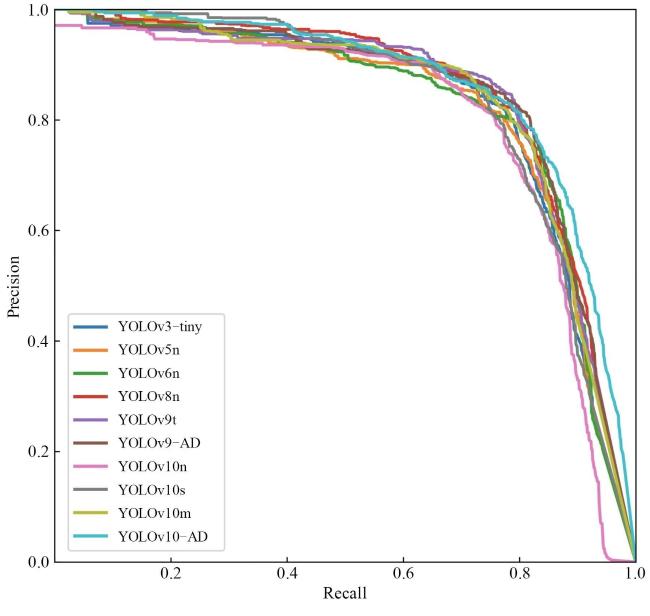

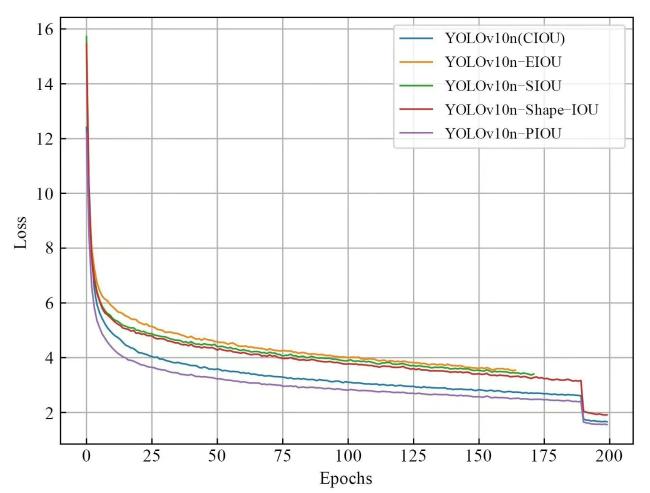

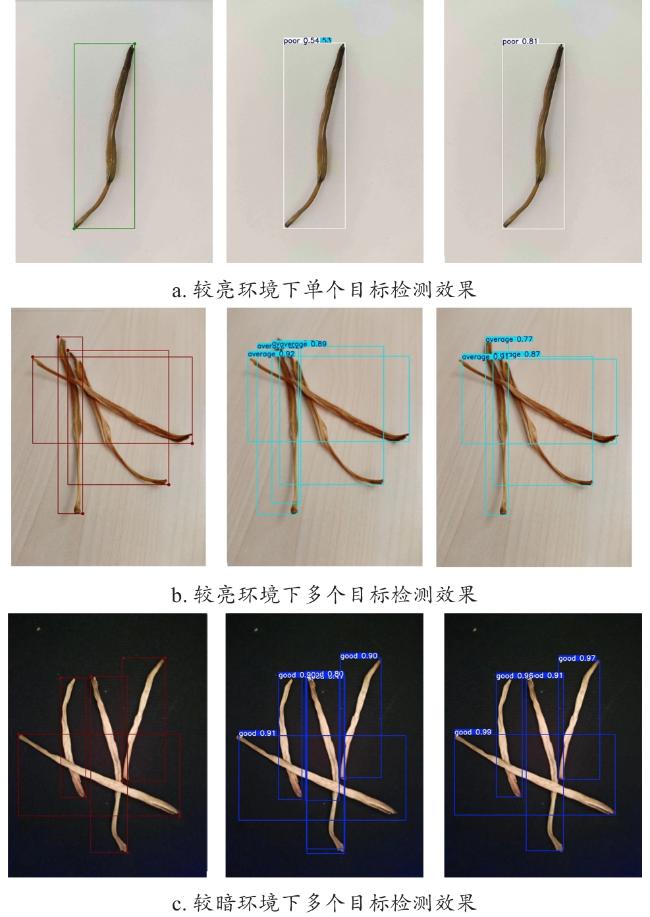

[Objective] In the agricultural production, accurately classifying dried daylily grades is a critical task with significant economic implications. However, current target detection models face challenges such as inadequate accuracy and excessive parameters when applied to dried daylily grading, limiting their practical application and widespread use in real-world settings. To address these issues, an innovative lightweight YOLOv10-AD network model was proposed. The model aims to enhance detection accuracy by optimizing the network structure and loss functions while reducing parameters and computational costs, making it more suitable for deployment in resource-constrained agricultural production environments. [Methods] The dried daylilies selected from the Qingyang region of Gansu province as the research subject. A large number of images of dried daylilies, categorized into three grades superior, medium, and inferior, were collected using mobile phones under varying lighting conditions and backgrounds. The images were carefully annotated and augmented to build a comprehensive dataset for dried daylily grade classification. YOLOv10 was chosen as the base network, and a newly designed backbone network called AKVanillaNet was introduced. AKVanillaNet combines AKConv (adaptive kernel convolution) with VanillaNet's deep learning and shallow inference mechanisms. The second convolutional layer in VanillaNet was replaced with AKConv, and AKConv was merged with standard convolution layers at the end of the training phase to optimize the model for capturing the unique shape characteristics of dried daylilies. This innovative design not only improved detection accuracy but also significantly reduced the number of parameters and computational costs. Additionally, the DysnakeConv module was integrated into the C2f structure, replacing the Bottleneck layer with a Bottleneck-DS layer to form the new C2f-DysnakeConv module. This module enhanced the model's sensitivity to the shapes and boundaries of targets, allowing the neural network to better capture the shape information of irregular objects like dried daylilies, further improving the model's feature extraction capability. The Powerful-IOU (PIOU) loss function was also employed, which introduced a target-size-adaptive penalty factor and a gradient adjustment function. This design guided the anchor box regression along a more direct path, helping the model better fit the data and improve overall performance. [Results and Discussions] The testing results on the dried daylily grade classification dataset demonstrated that the YOLOv10-AD model achieved a mean average precision (mAP) of 85.7%. The model's parameters, computational volume, and size were 2.45 M, 6.2 GFLOPs, and 5.0 M, respectively, with a frame rate of 156 FPS. Compared to the benchmark model, YOLOv10-AD improved mAP by 5.7% and FPS by 25.8%, while reducing the number of parameters, computational volume, and model size by 9.3%, 24.4%, and 9.1%, respectively. These results indicated that YOLOv10-AD not only improved detection accuracy but also reduced the model's complexity, making it easier to deploy in real-world production environments. Furthermore, YOLOv10-AD outperformed larger models in the same series, such as YOLOv10s and YOLOv10m. Specifically, the weight, parameters, and computational volume of YOLOv10-AD were only 31.6%, 30.5%, and 25.3% of those in YOLOv10s, and 15.7%, 14.8%, and 9.8% of YOLOv10m. Despite using fewer resources, YOLOv10-AD achieved a mAP increase of 2.4% over YOLOv10s and 1.9% over YOLOv10m. These findings confirm that YOLOv10-AD maintains high detection accuracy while requiring significantly fewer resources, making it more suitable for agricultural production environments where computational capacity may be limited. The study also examined the performance of YOLOv10-AD under different lighting conditions. The results showed that YOLOv10-AD achieved an average accuracy of 92.3% in brighter environments and 78.6% in darker environments. In comparison, the YOLOv10n model achieved 88.9% and 71.0% in the same conditions, representing improvements of 3.4% and 7.6%, respectively. These findings demonstrate that YOLOv10-AD has a distinct advantage in maintaining high accuracy and confidence in grading dried daylilies across varying lighting conditions. [Conclusions] The YOLOv10-AD network model proposed significantly reduces the number of parameters and computational costs without compromising detection accuracy. This model presents a valuable technical reference for intelligent classification of dried daylily grades in agricultural production environments, particularly where resources are constrained.