0 引 言

1 研究材料

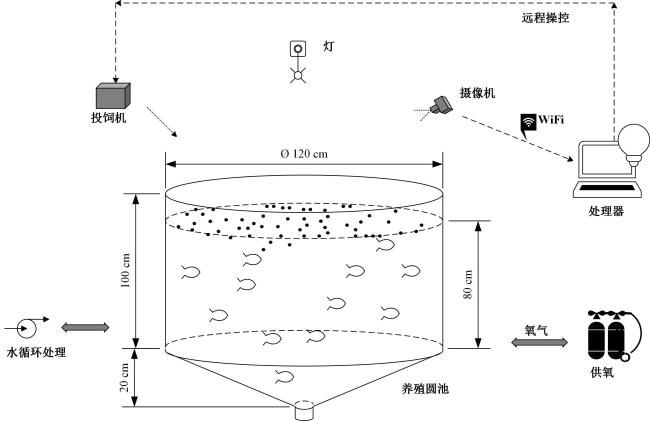

1.1 研究对象与采集系统

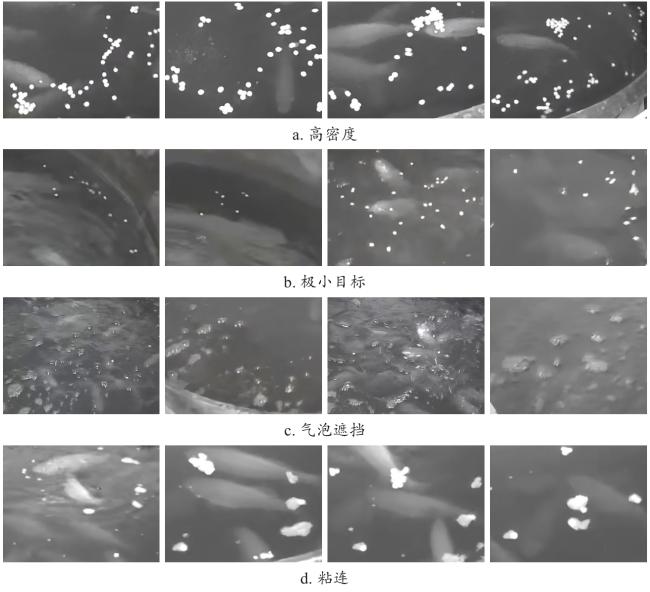

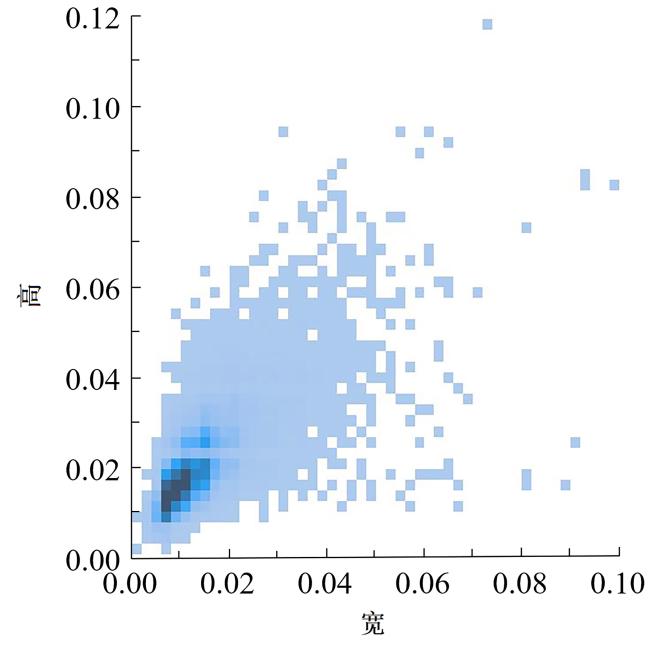

1.2 数据集构建

2 算法模型

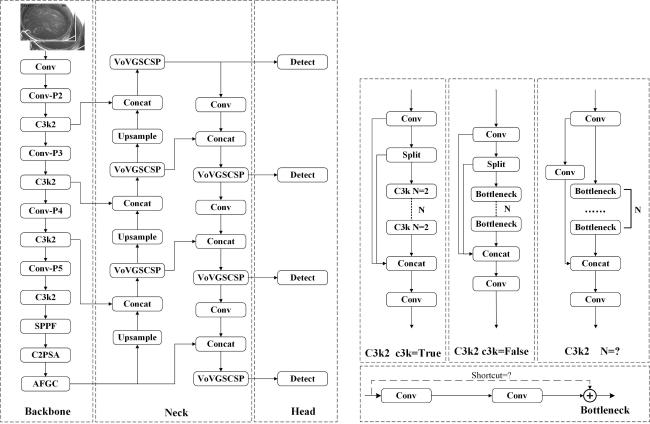

2.1 YOLOv11

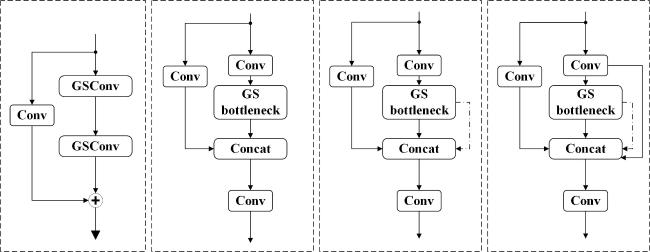

2.2 Slim-neck检测器

2.3 P2小目标检测层

2.4 细粒度分类的注意力机制(AFGC)

2.5 算法模型

2.5.1 骨干网络(Backbone)

2.5.2 颈部(Neck)

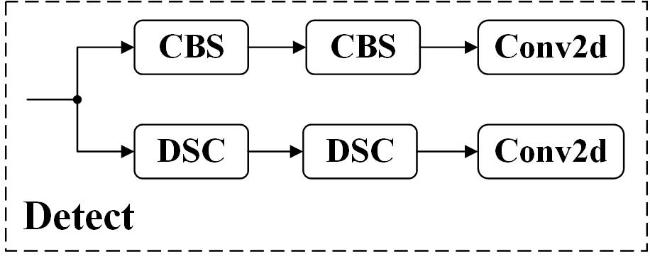

2.5.3 头部(Head)

2.6 模型参数设置与评价指标

表1 鱼群摄食行为检测研究的训练环境Table 1 Training environment for fish shoal foraging behavior detection research |

| 配置 | 名称 | 详细信息 |

|---|---|---|

| 硬件 | CPU | Intel(R)Core(TM)i7-12700H |

| 运行内存 | 16 G | |

| GPU | NVIDIA GeForce RTX 4060 Laptop GPU | |

| 显存 | 8 G | |

| 软件 | OS | Windows11 |

| Python | 3.8.20 | |

| CUDA | 12.1 | |

| 深度学习框架 | Pytorch 1.11.0 | |

| Batch size | 4 | |

| Learning | 0.001 | |

| Epoch_max | 250 |

3 结果与分析

3.1 消融实验

表2 改进YOLOv11模型检测水面膨化饲料的消融实验结果对比Table 2 Comparison of ablation experiment results for improved YOLOv11 model of surface extruded feed detection |

| 序号 | AFGC | P2层 | Slim-neck | P/% | R/% | mAP50/% | F 1分数/% | GFLOPs/G | FPS/(帧/s) |

|---|---|---|---|---|---|---|---|---|---|

| 1 | × | × | × | 72.00 | 69.70 | 70.60 | 71.00 | 6.4 | 53.20 |

| 2 | √ | × | × | 72.10 | 70.40 | 71.60 | 71.00 | 6.3 | 51.10 |

| 3 | × | √ | × | 78.00 | 78.70 | 79.40 | 78.00 | 10.3 | 43.80 |

| 4 | × | × | √ | 77.40 | 78.90 | 78.90 | 78.00 | 5.9 | 45.10 |

| 5 | √ | √ | × | 78.60 | 78.00 | 79.80 | 78.00 | 10.3 | 42.50 |

| 6 | √ | × | √ | 72.00 | 70.20 | 70.80 | 71.00 | 6.0 | 44.30 |

| 7 | × | √ | √ | 77.70 | 78.50 | 79.50 | 78.00 | 10.0 | 36.90 |

| 8 | √ | √ | √ | 78.70 | 78.70 | 80.00 | 79.00 | 10.0 | 38.30 |

|

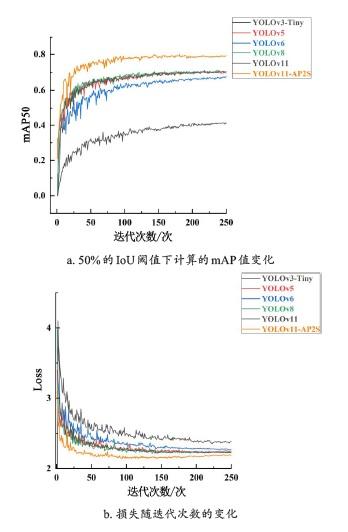

3.2 与其他模型的性能比较

表 3 不同模型在自制数据集上的水面膨化饲料检测结果对比Table 3 Comparison of detection results among different models on a self-made dataset of surface extruded feed detection |

| 模型 | P/% | R/% | mAP50/% | F 1分数/% | GFLOPs/G | FPS/(帧/s) |

|---|---|---|---|---|---|---|

| YOLOv3-tiny | 41.40 | 37.20 | 41.30 | 43.30 | 19.0 | 153.82 |

| YOLOv5 | 71.90 | 69.40 | 70.80 | 71.00 | 7.2 | 111.85 |

| YOLOv6 [ 18] | 71.50 | 66.70 | 67.80 | 70.50 | 11.9 | 146.01 |

| YOLOv8 | 71.30 | 80.00 | 71.30 | 72.00 | 8.2 | 92.50 |

| YOLOv11 | 82.30 | 81.00 | 70.60 | 71.00 | 6.4 | 53.20 |

| YOLOv11-AP2S | 78.70 | 78.70 | 80.00 | 79.00 | 10.0 | 38.30 |

4 讨论与结论

4.1 讨论

表4 YOLOv11-AP2S模型与现有基于机器视觉的饲料检测方法对比Table 4 Comparison between the present study's method and existing machine vision-based feed detection methods |

| 文献 | 图像处理 | 检测方法 | 功能 | 结果 |

|---|---|---|---|---|

| Hu等 [ 6] | 图像和数据增强 | 基于改进的YOLOv4网络的检测模型 | 水下图像中漏斗饲料颗粒的实时检测 | mAP50:92.61% |

| Li等 [ 28] | 直方图拟合 | 分割馈源的自适应阈值方法 | 在水下发现未食用的鱼类食物 | TPR:80.00%~95.90% FPR:<2.7% |

| Gao和Xu [ 29] | 图像去除、图像建立和图像增强 | 基于个体颗粒面积的轮廓识别和饲料颗粒数量估计的阈值方法 | 标识和计数剩余提要 | 相对误差:大约10% |

| Hou等 [ 30] | 图像调整尺寸 | 改进的多列卷积神经网络的检测方法 | 检测进料颗粒 | MAE:2.32 MSE:3.00 |

| Wang等 [ 31] | — | 用于检测未食用饲料颗粒的多任务卷积神经网络 | 分析养殖鱼类的摄食活性,监测未食用饲料颗粒的数量,并进行动态调整饲养 | MAE:4.80 MSE:6.75 |

| YOLOv11-AP2S | — | 基于改进的YOLOv11网络的检测模型 | 水面膨化饲料颗粒的实时检测 | mAP50:80.00% |

|