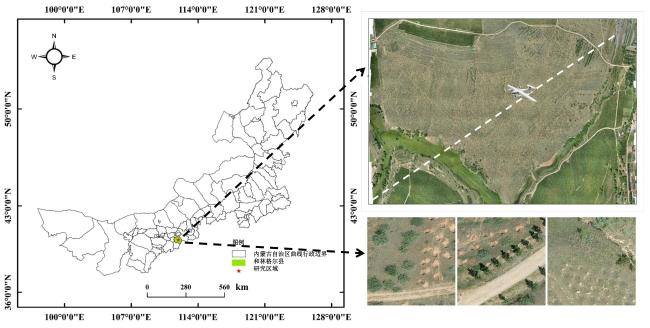

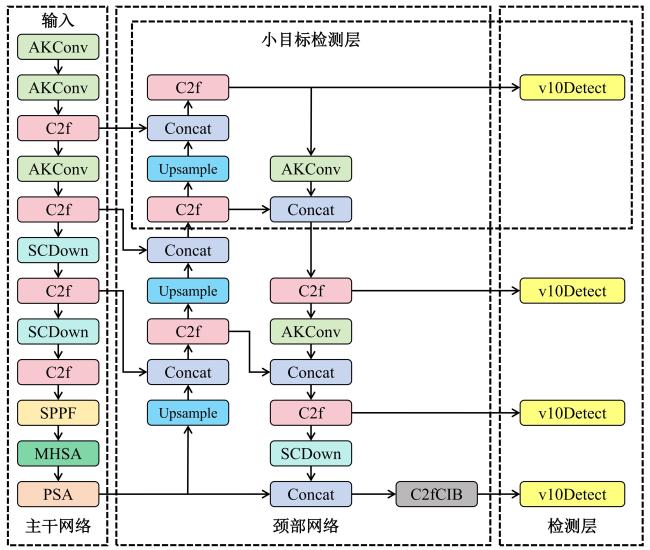

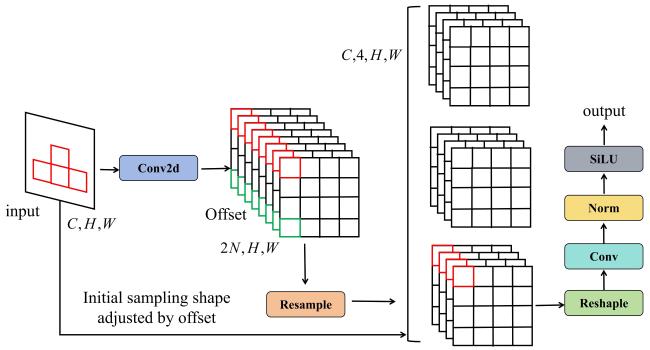

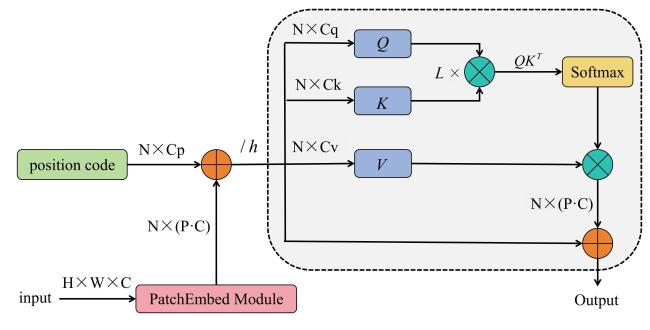

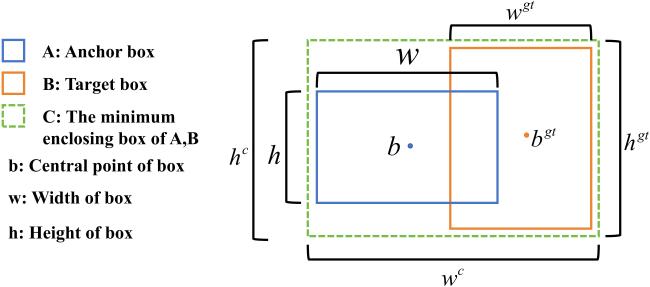

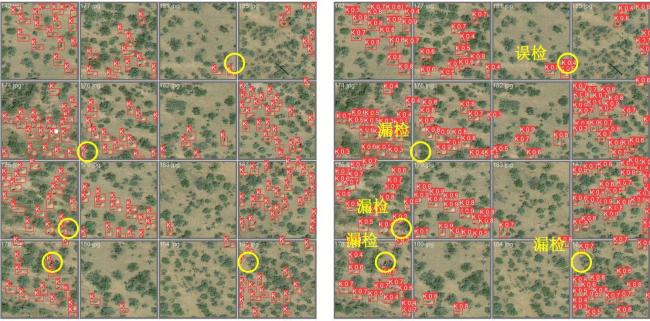

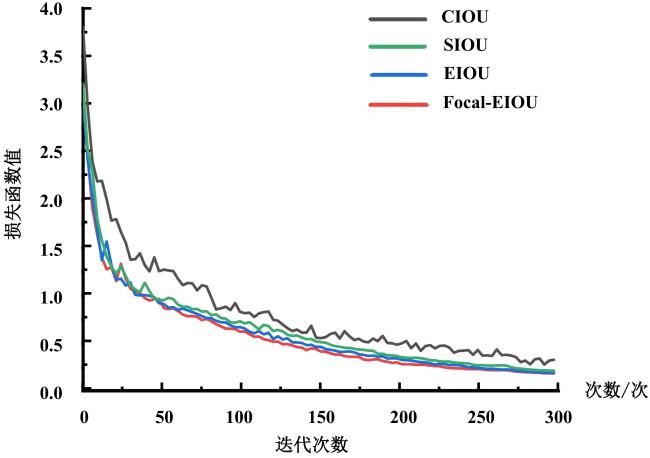

[Objective] The traditional manual field investigation method of the tree planting locations is not only inefficient but also error-prone, and the low-altitude unmanned aerial vehicle (UAV) has become the best choice to solve these problems. To solve the problem of accuracy and efficiency in the detection of tree planting locations (tree pits) in Inner Mongolia of China's Three North Project, an accurate recognition and detection model of tree planting locations based on YOLOv10-MHSA was proposed. [Methods] A long-endurance, multi-purpose vertical take-off and landing (VTOL) fixed-wing UAV was used to collect images of tree planting locations. Equipped with a 26-megapixel camera with high spatial resolution, the UAV was well-suited for high-precision field mapping. Aerial photography was conducted between 11:00 and 12:00 on August 1, 2024. Flight parameters were set as follows: Altitude of 150 m (yielding a ground resolution of approximately 2.56 cm), course overlap rate of 75%, side overlap rate of 65%, and flight speed of 20 m/s. To prevent overfitting during network training, the original data set was enhanced. To improve the quality and efficiency of model training, different attention mechanisms and optimizing loss functions were introduced. Specifically, a more effective EIOU loss function was introduced, comprising three components: IOU loss, distance loss, and azimuth loss. This function directly minimizes the width and height discrepancies between the target frame and anchor, leading to faster convergence and more accurate positioning. Additionally, the Focal-EIOU loss function was adopted to address sample imbalance in bounding box regression tasks, further improving the model's convergence speed and positioning precision. [Results and Discussions] After the introduction of the multi-head self-attention mechanism (MHSA), the model achieved improvements of 1.4% and 1.7% in the evaluation metrics AP@0.5 and AP@0.5:0.95, respectively, and the accuracy and recall rate were also improved. This indicates that MHSA effectively aids the model in extracting the feature information of the target and improving the detection accuracy in complex background. Although the processing speed of the model decreases slightly after adding the attention mechanism, it could still meet the requirements of real-time detection. The experiment compared four loss functions: CIOU, SIOU, EIOU and Focal-EIOU. The results showed that the Focal-EIOU loss function yielded significant increases in precision and recall. This demonstrated that the Focal-EIOU loss function could accelerate the convergence speed of the model and improve the positioning accuracy when dealing with the sample imbalance problem in small target detection. Finally, an improved model, YOLOv10-MHSA, was proposed, incorporating MHSA attention mechanism, small target detection layer and Focal-EIOU loss function. The results of ablation experiments showed that AP@0.5 and AP@0.5:0.95 were increased by 2.2% and 0.9%, respectively, after adding only small target detection layer on the basis of YOLOv10n, and the accuracy and recall rate were also significantly improved. When the MHSA and Focal-EIOU loss functions were further added, the model detection effect was significantly improved. Compared with the baseline model YOLOv10n, the AP@0.5, AP@0.5:0.95, P-value and R-value were improved by 6.6%, 10.0%, 4.1% and 5.1%, respectively. Although the FPS was reduced, the detection performance of the improved model was significantly better than that of the original model in various complex scenes, especially for small target detection in densely distributed and occluded scenes. [Conclusions] By introducing MHSA and the optimized loss function (Focal-EIOU) into YOLOv10n model, the research significantly improved the accuracy and efficiency of tree planting location detection in the Three North Project in Inner Mongolia. The experimental results show that MHSA can enhance the ability of the model to extract local and global information of the target in complex background, and effectively reduce the phenomenon of missed detection and false detection. The Focal-EIOU loss function accelerates the convergence speed of the model and improves the positioning accuracy by optimizing the sample imbalance problem in the bounding box regression task. Although the model processing speed has decreased, the method proposed still meets the real-time detection requirements, provides strong technical support for the scientific afforestation of the Three North Project.