文本语义相似性计算通常采用基于特征工程方法,利用向量空间模型(Vector Space Model,VSM)、TF-IDF(Term Frequency-Inverse Document Frequency)和词袋模型等方法提取特征,然后利用余弦相似度、编辑距离、曼哈顿距离等度量方法计算语义相似度。深度学习算法在文本相似性计算任务中得到广泛应用。该方法一般依托孪生神经网络架构,利用多种神经网络提取文本整体语义特征,然后在匹配层进行相似度计算。Wang等

[4]提出了由表示层、匹配层和聚合层三部分组成的双边多视角匹配模型(Bilateral Multi-Perspective Matching, BiMPM),使用双向长短期记忆网络(Bidirectional Long Short-Term Memory, BiLSTM)构建表示层,并提取从句子P到句子Q和从句子Q到句子P的双向匹配关系,以便全面捕捉句子间的交互信息。Chen等

[5]提出的ESIM(Enhanced Sequential Inference Model)模型在BiLSTM的基础上引入了注意力机制,实现了句子间的局部信息建模,有助于捕捉句子间的关键信息。Wang等

[6]在循环神经网络(Recurrent Neural Network,RNN)隐藏表示层之前引入注意力机制,解决了注意力机制偏移问题。Pang等

[7]将文本匹配问题建模为图像识别问题,构建一个单词级别的匹配矩阵,其元素表示单词间的相似性,利用卷积神经网络逐层捕捉深层次语义关系,提高语义相似计算的正确率。但基于深度学习的语义相似性计算效果高度依赖数据集规模和数据质量,并且对于语义关系更加复杂、知识更加丰富的专业领域而言,仍存在语义特征提取不够精准等问题。预训练模型可将外部知识引入到语义匹配任务中,以弥补短文本语义特征不足问题

[8]。BERT(Bidirectional Encoder Representations from Transformers)

[9]通过在大规模语料库上的预训练,提取了丰富的语言特征和语义关系,在迁移学习策略下,这些预训练模型可以被迁移到专业领域的语义特征提取任务中,通过少量的专业领域数据进行微调(fine-tuning),即可更加精准地提取语料特征,适应任务需求。研究人员针对文本语义相似度计算任务将迁移学习策略与BERT模型相结合开展了系列研究工作

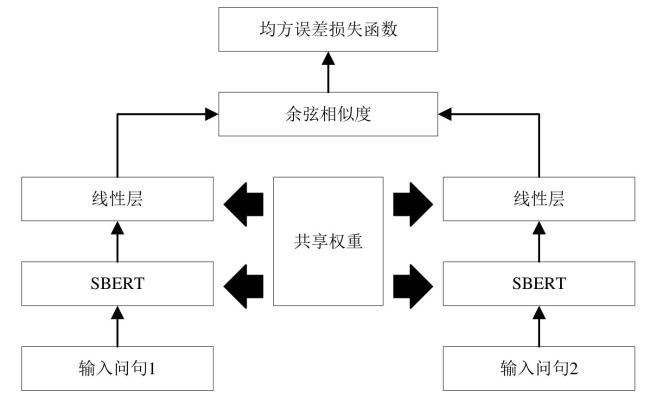

[10, 11]。SBERT(Sentence BERT)

[12]模型利用孪生神经网络结构,将句子向量化并经过平均池化层处理后,根据余弦相似度衡量语义相似度。Ryu等

[13]提出的ALBERT(A Lite BERT)模型,对BERT结构进行轻量化设计,实现了训练和预测时间的显著优化。Li等

[14]提出了一种自我集成的ALBERT模型,该模型通过数据增强技术扩大了数据集的规模,并结合半监督学习方法提高了模型的学习效率。Bai等

[15]提出的Syntax-BERT利用语法树从语法角度改进了Transformer模型,为预训练模型改进提供了新思路。近年来,基于通用大语言模型的方法也被应用在文本语义相似度计算研究中,Yang

[16]利用一种自定义的GPT(Generative Pre-Trained Transformer)获取文本向量表示,并利用多种策略计算文本的相似度。Xu等

[17]提出了GPT-4与“all-mpnet-base-v2”相结合的基于推理的相似度计算模型,该模型根据文本结构化信息和文本蕴含知识的关联程度计算文本语义相似性。大模型强大的语义理解能力和上下文感知能力可提高语义相似度计算的精准度,但大模型存在对计算资源和硬件设备需求高、计算效率低等问题影响了其应用,此外,针对特定领域的适应性仍有待进一步验证。