0 引 言

1 试验材料

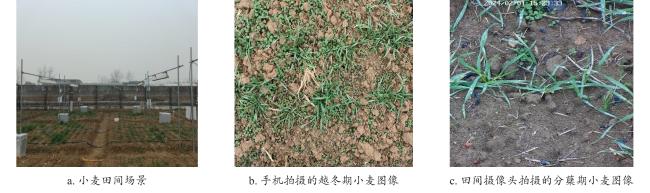

1.1 图像采集

表1 不同设备拍摄的不同生长期和光照条件的小麦图像数据组成Table 1 Composition of wheat image data captured by different devices with different growth stages and lighting conditions |

| 数据来源 | 不同生长期小麦图像数量/张 | 不同光照条件小麦图像数量/张 | |||

|---|---|---|---|---|---|

| 出苗期 | 分蘖期 | 越冬期 | 晴天 | 阴天 | |

| 手机 | 187 | 323 | 254 | 354 | 410 |

| 田间摄像头 | | 62 | 44 | 48 | 58 |

| 总数 | 187 | 385 | 298 | 402 | 468 |

|

1.2 数据集构建

2 算法模型构建和评价指标

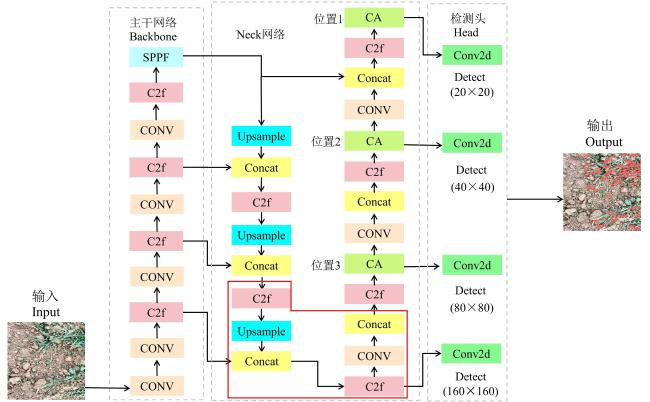

2.1 YOLOv8算法

2.2 嵌入CA注意力机制

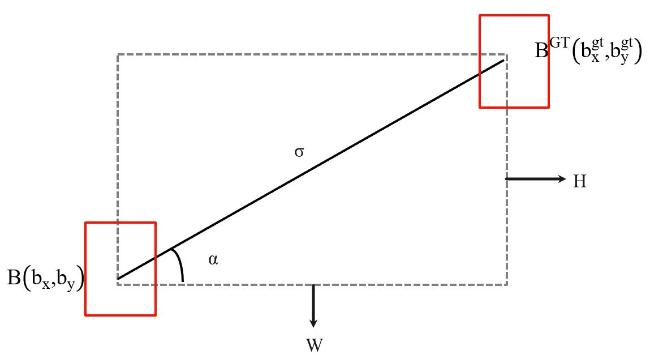

2.3 优化损失函数

2.4 添加小目标检测层

2.5 小麦叶尖识别算法模型

表2 YOLOv8-CSD模型检测头组成Table 2 Composition of detection head for YOLOv8-CSD model |

| 特征图/像素 | 20×20 | 40×40 | 80×80 | 160×160 |

|---|---|---|---|---|

| 感受野 | 大 | 中 | 较小 | 小 |

| 锚框 | (116,90) (156,198) (373,326) | (30,61) (62,45) (59,119) | (10,13)(16,30)(33,23) | (5,7) (9,13) (11,15) |

2.6 模型训练与评价指标

2.6.1 模型训练环境

2.6.2 评价指标

3 结果与分析

3.1 消融实验

表3 小麦叶尖识别研究中改进YOLOv8模型的消融实验Table 3 Improved YOLOv8 model ablation experiment for wheat leaf tip recognition research |

| 序号 | 添加CA注意力机制 | 替换SIoU损失函数 | 添加小目标检测层 | P/% | R/% | mAP0.5/% |

|---|---|---|---|---|---|---|

| 1 | × | × | × | 89.3 | 73.6 | 81.8 |

| 2 | √ | × | × | 90.2 | 74.5 | 83.2 |

| 3 | × | √ | × | 89.7 | 74.1 | 82.2 |

| 4 | × | × | √ | 90.0 | 76.8 | 84.9 |

| 5 | √ | √ | √ | 91.6 | 80.0 | 85.1 |

|

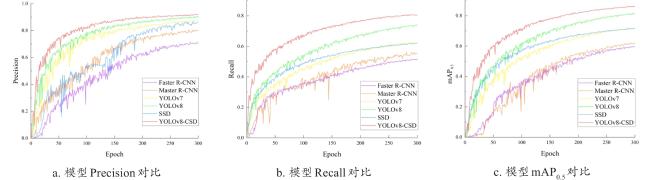

3.2 不同网络模型识别性能对比实验

表4 小麦叶尖识别研究中不同模型的检测性能对比平均值Table 4 Comparison of detection performance average of different models in wheat leaf tip recognition research |

| 模型 | P/% | R/% | mAP0.5/% | 模型大小/MB |

|---|---|---|---|---|

| Faster R-CNN | 70.9 | 50.4 | 58.7 | 108.2 |

| Mask R-CNN | 79.3 | 54.8 | 61.6 | 244.0 |

| YOLOv7 | 87.2 | 62.5 | 71.8 | 74.8 |

| YOLOv8 | 89.3 | 73.6 | 81.8 | 49.7 |

| SSD | 85.6 | 61.9 | 71.5 | 78.1 |

| YOLOv8-CSD | 91.6 | 80.0 | 85.1 | 52.2 |

3.3 不同设备获取图像检测效果对比

表5 YOLOv8-CSD模型对不同设备获取的小麦叶片图像检测结果对比Table 5 Comparison of detection results of wheat leaf images obtained from different devices using YOLOv8-CSD model |

| 图像采集设备 | P/% | R/% | mAP0.5/% |

|---|---|---|---|

| 田间摄像头 | 90.18 | 78.16 | 82.43 |

| 手机 | 92.43 | 83.51 | 86.78 |

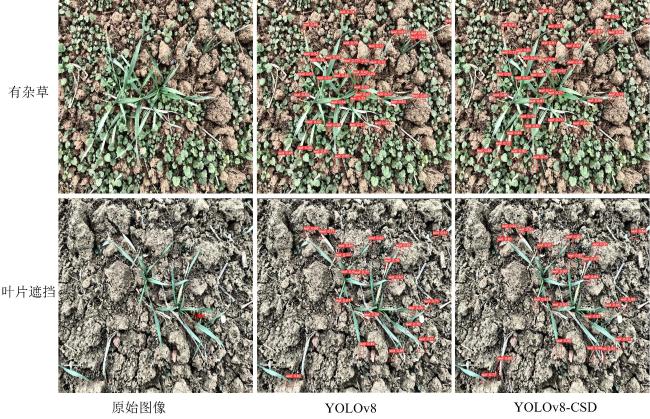

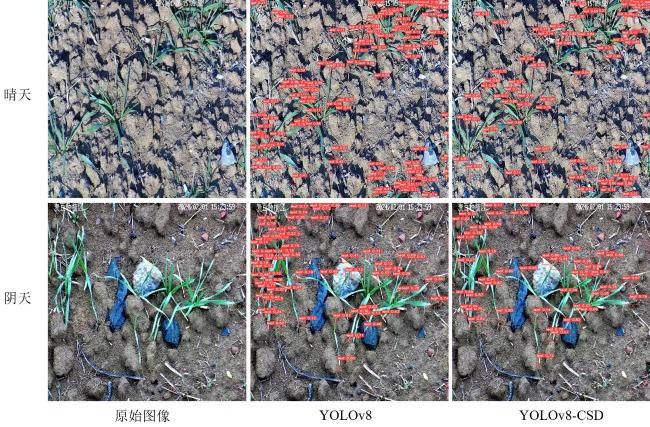

3.4 模型改进前后复杂环境检测效果对比

表6 YOLOv8和YOLOv8-CSD对两种典型光照条件下拍摄的小麦叶片图像检测结果对比Table 6 Comparison of detection results of wheat leaf images captured under two typical lighting conditions using YOLOv8 and YOLOv8-CSD |

| 光照条件 | 模型 | R/% | mAP0.5/% |

|---|---|---|---|

| 阴天 | YOLOv8 | 80.6 | 77.0 |

| YOLOv8-CSD | 82.7 | 82.2 | |

| 晴天 | YOLOv8 | 77.0 | 71.9 |

| YOLOv8-CSD | 80.9 | 76.1 |

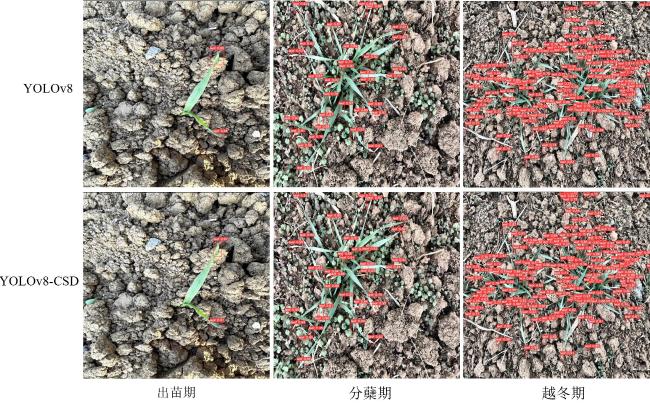

3.5 模型改进前后不同生长期检测效果对比

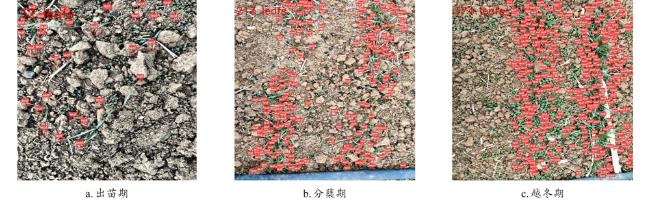

3.6 复杂大田场景下小麦叶片数检测效果

表7 YOLOv8-CSD对不同生长期小麦叶片数检测结果统计Table 7 Statistics of the number of wheat leaves detected by YOLOv8-CSD at different growth stages |

| 生长期 | 检测数/个 | 漏检数/个 | 模型检测总时间/s |

|---|---|---|---|

| 出苗期 | 103 | 0 | 1.45 |

| 分蘖期 | 468 | 8 | 2.27 |

| 越冬期 | 721 | 21 | 2.63 |