0 引 言

1 材料与方法

1.1 小目标羊群数据集构建

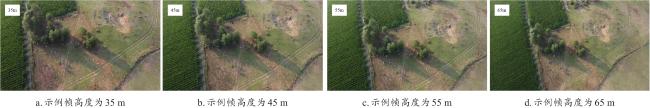

1.1.1 数据来源

1.1.2 数据处理

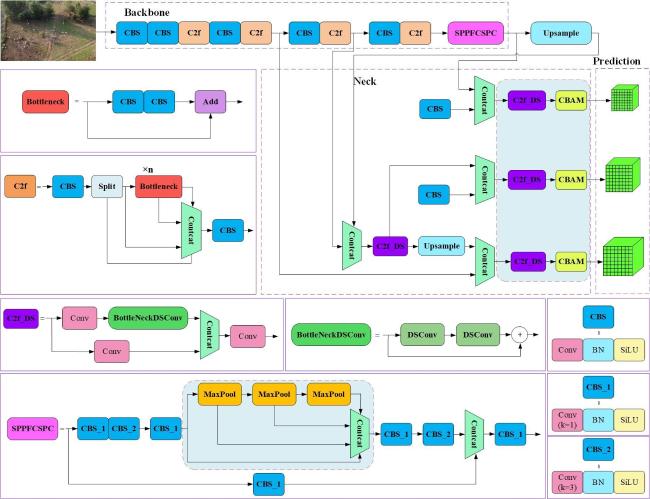

1.2 基于CSD-YOLOv8s的密集羊只检测模型

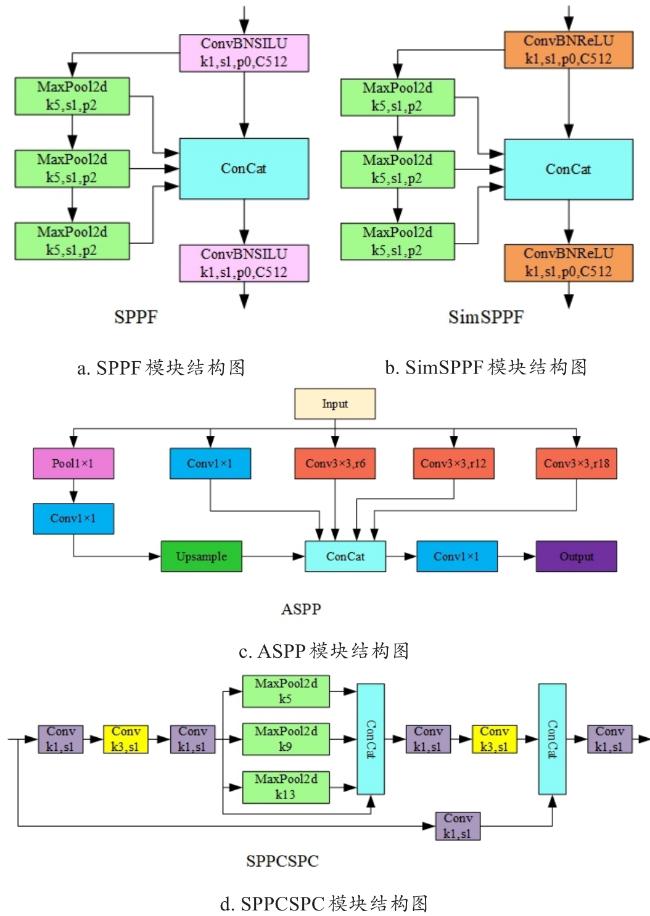

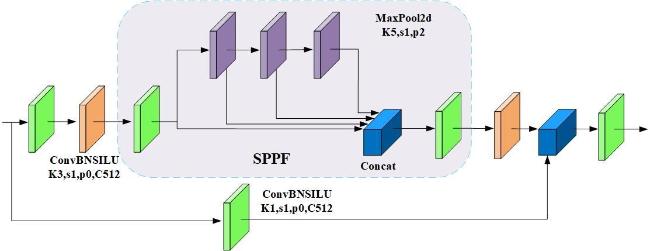

1.2.1 SPPFCSPC增强特征提取

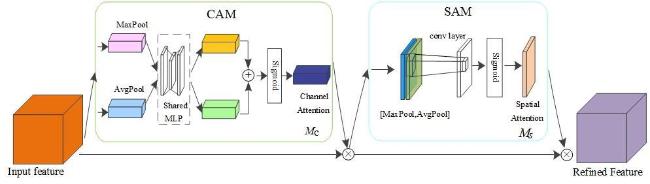

1.2.2 注意力机制

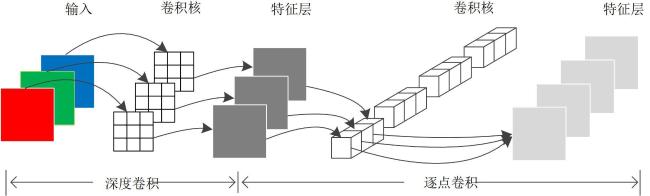

1.2.3 深度可分离卷积的模型轻量化

1.3 评价指标

2 结果分析

2.1 实验环境及参数设置

表2 无人机羊群目标检测实验硬件参数配置Table 2 Hardware parameter configuration for UAV sheep target detection experiment |

| 硬件配置 | 参数 |

|---|---|

| CPU | Intel(R) Core(TM) i9-9900K CPU@3.6 GHz |

| GPU | NVIDIA Quadro P6000 |

| 内存容量 | 32 G |

| 操作系统 | Windows 10 |

| 开发工具 | PyCharm2020.1.1 |

| CUDA版本 | 10.2 |

| 深度学习框架 | PyTorch 1.10.0 |

2.2 消融测试性能

表3 无人机羊群目标检测消融实验Table 3 UAV sheep target detectionAblation experiment |

| 模型名称 | P/% | mAP/% | FLOPs/G | FPS/(f/s) | Params/M |

|---|---|---|---|---|---|

| YOLOv8s | 93.0 | 91.2 | 28.6 | 105 | 11.13 |

| YOLOv8s+SPPFCSPC | 94.6 | 92.6 | 33.6 | 93 | 17.49 |

| YOLOv8s+CBAM | 94.1 | 92.1 | 28.7 | 88 | 11.17 |

| YOLOv8s+C2f_DS | 92.8 | 91.2 | 24.7 | 107 | 10.31 |

| YOLOv8s+SPPFCSPC+CBAM | 95.2 | 93.1 | 33.9 | 82 | 17.61 |

| YOLOv8s+SPPFCSPC+C2f_DS | 94.5 | 92.4 | 29.9 | 95 | 16.73 |

| YOLOv8s+CBAM+C2f_DS | 94.2 | 92 | 24.8 | 90 | 10.36 |

| CSD-YOLOv8s(本研究) | 95.2 | 93.1 | 29.9 | 87 | 16.68 |

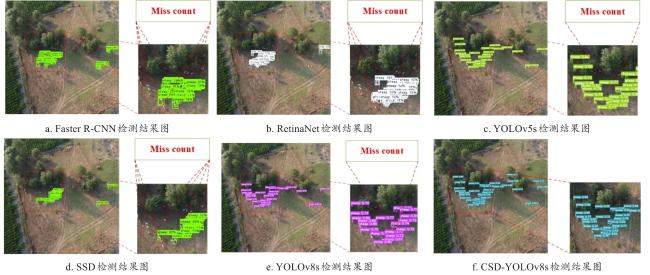

2.3 对比实验结果分析

2.3.1 不同模型对比

表 4 不同网络模型的羊群检测实验结果Table 4 Experimental results of sheep detection with different network models |

| Model | mAP/% | FPS/(f/s) | Model size/M |

|---|---|---|---|

| Faster R-CNN | 64.6 | 18 | 314 |

| REtinaNet | 76.2 | 18 | 245 |

| YOLOv5s | 90.5 | 115 | 14 |

| SSD | 58.8 | 59 | 100 |

| YOLOv8s | 91.2 | 105 | 22 |

| CSD-YOLOv8s | 93.1 | 87 | 35 |

2.3.2 不同注意力机制对比

表5 不同注意力机制实验对比结果Table 5 Experimental comparison of different attention mechanisms |

| Attention mechanism | P/% | mAP/% | FLOPs/G | FPS/(f/s) |

|---|---|---|---|---|

| —— | 93.0 | 91.2 | 28.6 | 105 |

| SE | 93.7 | 91.5 | 28.7 | 96 |

| SimAM | 93.2 | 91.2 | 28.6 | 100 |

| CA | 93.2 | 91.4 | 28.7 | 96 |

| Shuffle | 92.8 | 91.1 | 28.6 | 116 |

| ECA | 93.3 | 91.2 | 28.7 | 101 |

| CBAM | 94.1 | 92.1 | 28.7 | 88 |

|

2.3.3 改进SPPF模块的试验分析

表6 不同SPPF模块实验对比结果Table 6 Experimental pairwise comparisonresults of different SPPF modules |

| Module | P/% | mAP/% | FLOPs/G | FPS/(f/s) | Params/M |

|---|---|---|---|---|---|

| SPPF | 93.0 | 91.2 | 28.6 | 105 | 11.13 |

| ASPP | 93.3 | 91.0 | 35.0 | 84 | 19.38 |

| SimSPPF | 93.0 | 91.2 | 28.6 | 106 | 11.14 |

| SPPCSPC | 94.6 | 92.6 | 33.6 | 90 | 17.56 |

| SPPFCSPC | 94.6 | 92.6 | 33.6 | 93 | 17.56 |

2.3.4 公开数据集验证

表7 公共数据集PASCAL VOC 2007对比实验结果Table 7 The comparison experiment results of public dataset PASCAL VOC 2007 |

| Model | P/% | mAP/% |

|---|---|---|

| YOLOv8s(all) | 0.763 | 0.702 |

| YOLOv8s(sheep) | 0.722 | 0.652 |

| CSD-YOLOv8s(all) | 0.784 | 0.710 |

| CSD-YOLOv8s(sheep) | 0.819 | 0.663 |

|