0 引 言

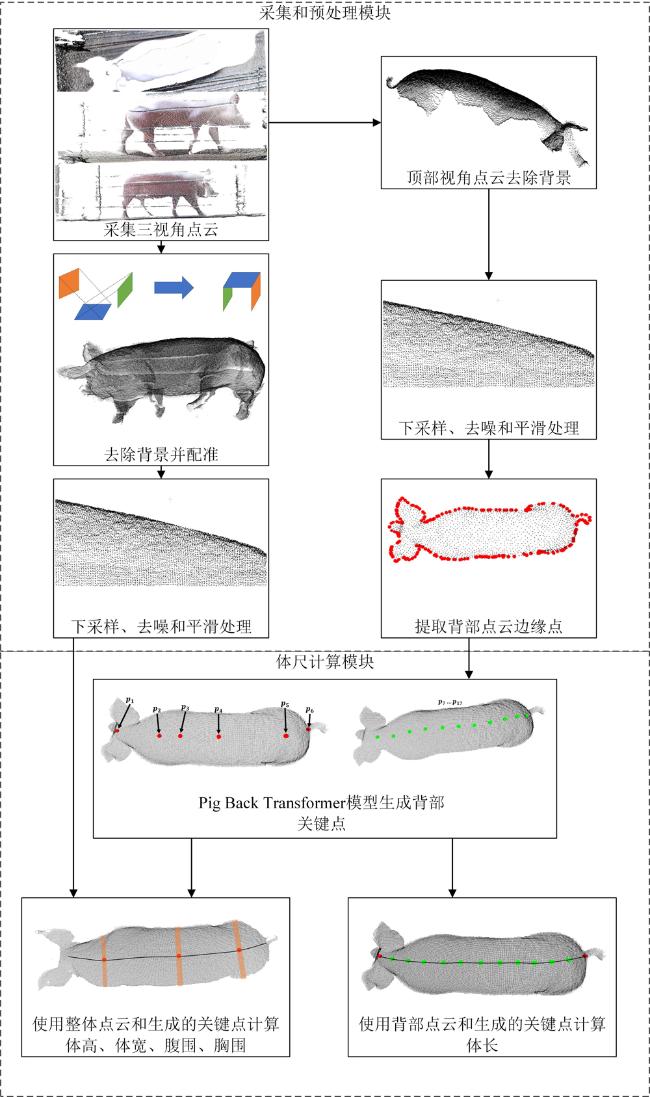

1 研究方法

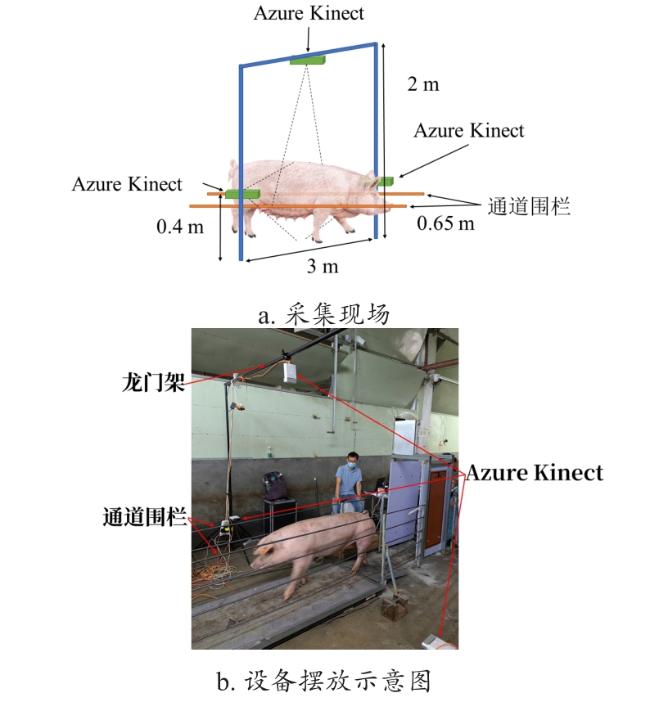

1.1 采集和数据预处理

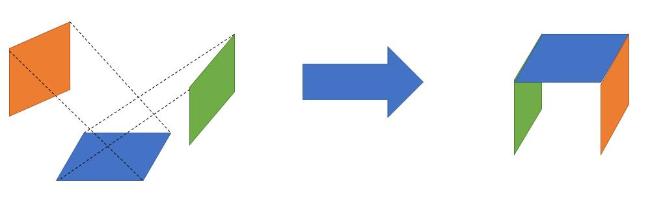

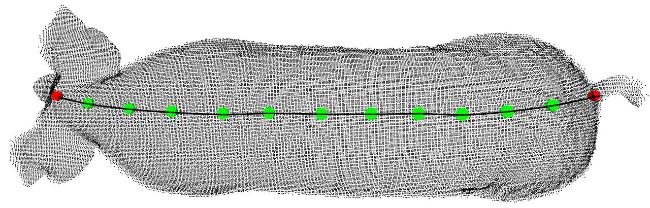

1.1.1 配准并提取猪体点云

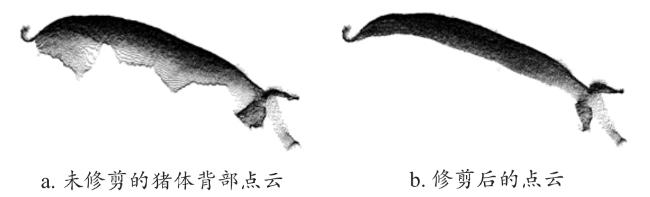

1.1.2 噪声点去除

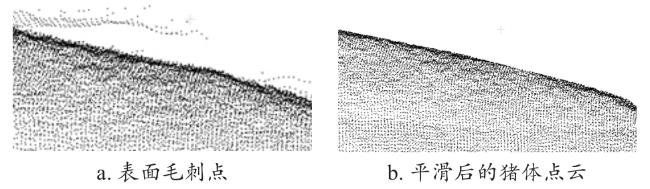

1.1.3 猪体点云平滑

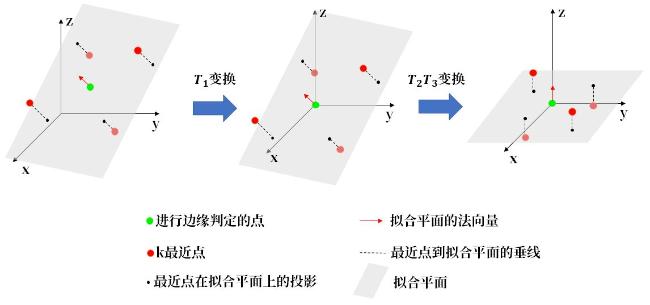

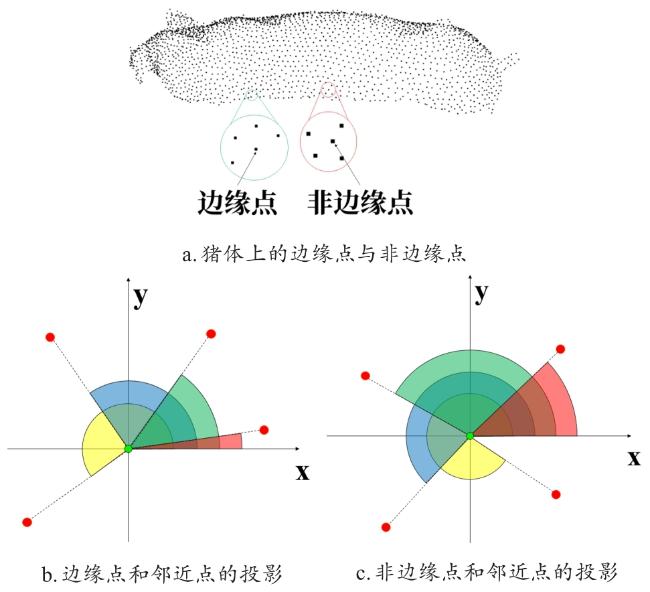

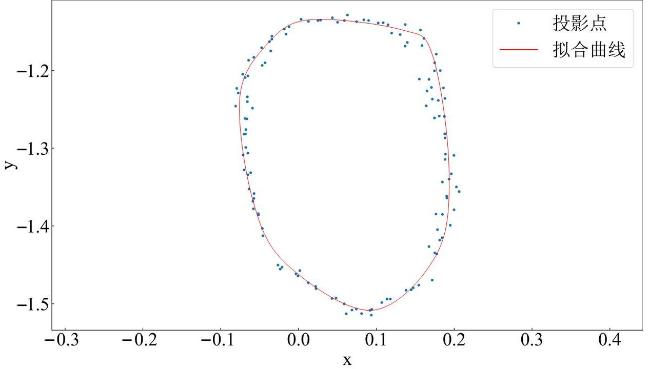

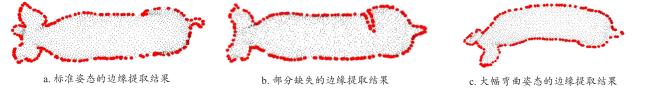

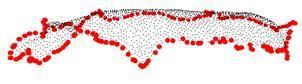

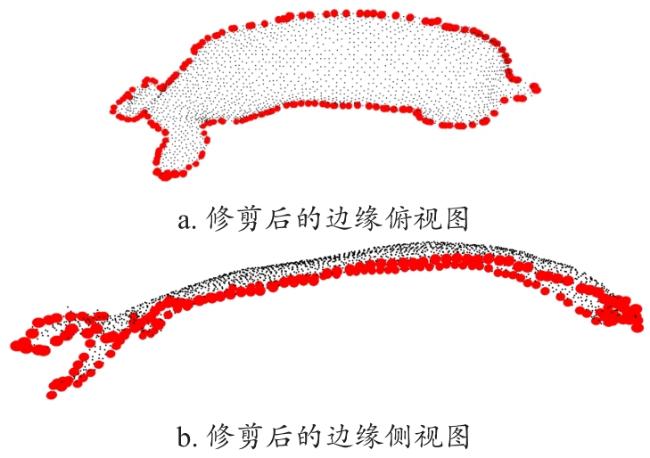

1.1.4 猪背部边缘提取

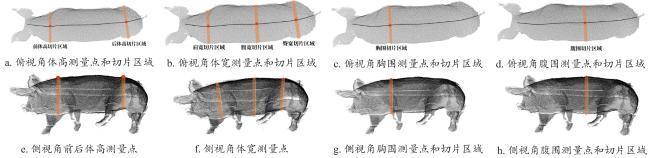

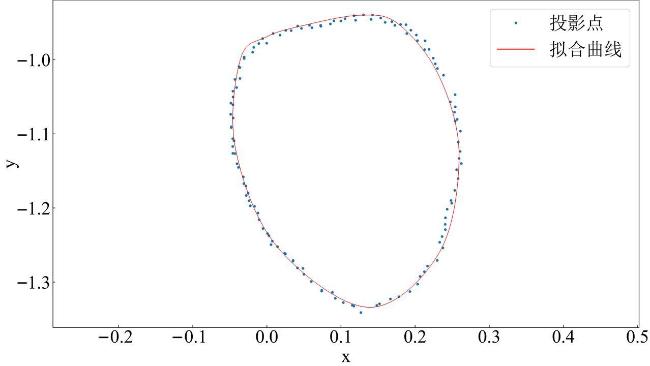

1.2 体尺计算

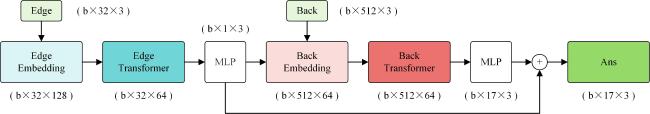

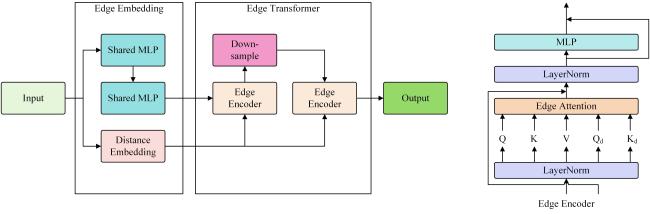

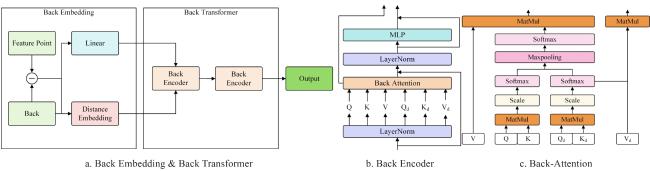

1.2.1 改进的自注意力Pig Back Transformer

1.2.2 猪体尺算法

2 实验结果与分析

2.1 边缘提取

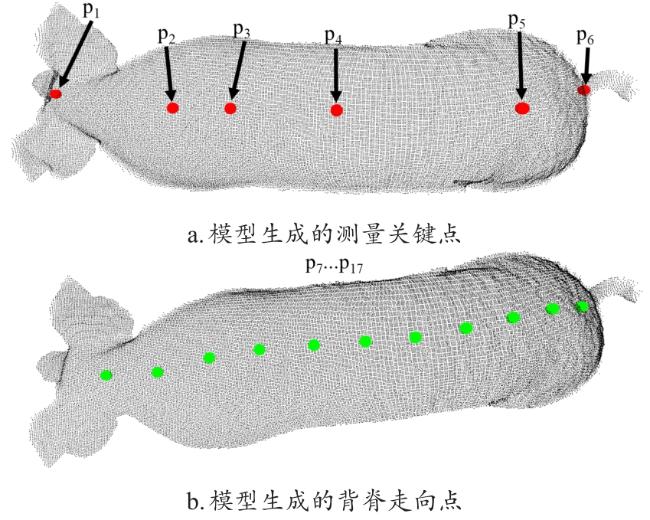

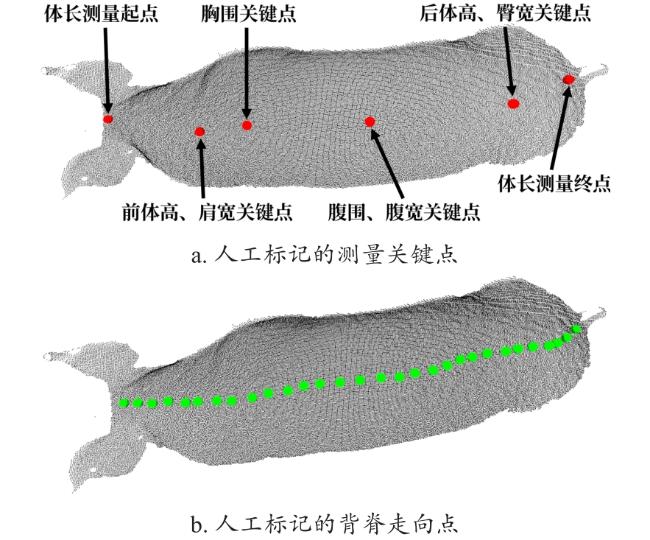

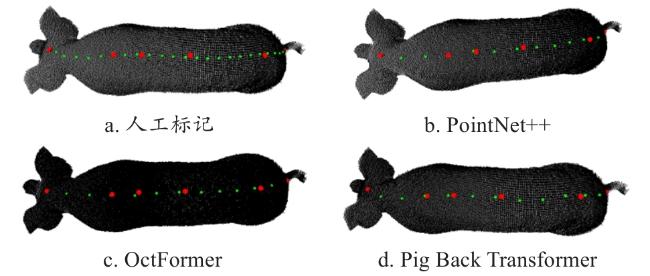

2.2 关键点生成

2.2.1 与其他模型的对比

表 1 不同模型的关键点拟合结果Table 1 Key points generated by different models |

| 模型 | Loss | 关键点平均偏差 | 点间距方差 | 参数量/M |

|---|---|---|---|---|

| PointNet++ | 0.061 | 0.009 | 0.001 5 | 8.7 |

| Point Transformer V2[20] | 0.052 | 0.008 | 0.001 5 | 11.0 |

| Point Cloud Transformer[21] | 0.074 | 0.012 | 0.002 1 | 10.5 |

| OctFormer[22] | 0.037 | 0.005 | 0.001 0 | 11.8 |

| PoinTr[23] | 0.082 | 0.013 | 0.001 8 | 10.1 |

| Pig Back Transformer(无边缘提取模块) | 0.091 | 0.015 | 0.001 5 | 9.8 |

| Pig Back Transformer | 0.013 | 0.002 | 0.001 1 | 10.3 |

|

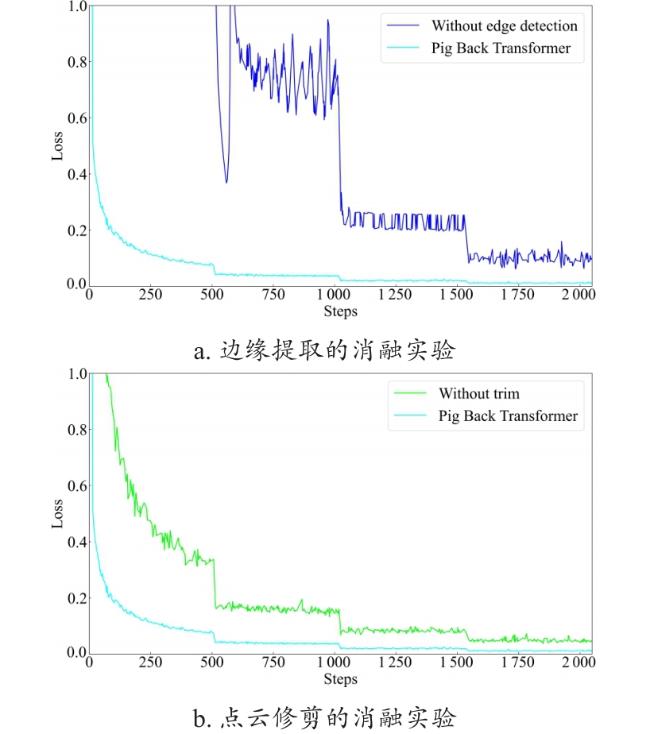

2.2.2 消融实验

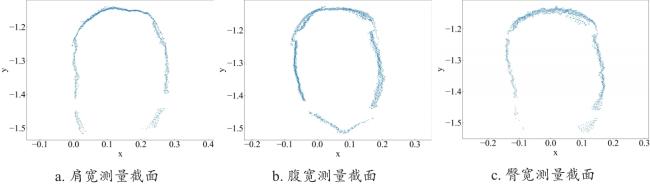

2.3 体尺计算

2.3.1 与人工测量结果对比

表 2 Pig Back Transformer模型体尺计算结果与人工体尺测量的误差Table 2 Error comparing body size calculated by Pig Back Transformerwith human measured result |

| 体尺类型 | 平均相对 误差/% | 平均误差/cm | 最大误差/cm | 误差标准差 |

|---|---|---|---|---|

| 体长 | 0.63 | 0.729 | 1.982 | 0.079 |

| 前体高 | 1.85 | 1.132 | 2.264 | 2.199 |

| 后体高 | 2.38 | 1.610 | 3.395 | 0.678 |

| 肩宽 | 2.68 | 0.832 | 2.264 | 2.348 |

| 腹宽 | 1.22 | 0.369 | 0.851 | 0.435 |

| 臀宽 | 5.46 | 1.747 | 3.608 | 1.194 |

| 胸围 | 4.02 | 4.200 | 3.170 | 2.910 |

| 腹围 | 3.95 | 4.585 | 2.966 | 2.831 |

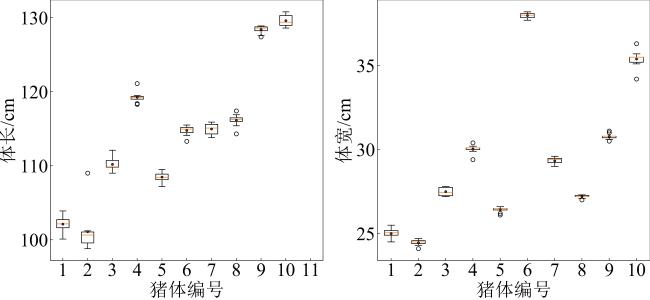

2.3.2 猪体姿态剧烈变化对体尺的影响

表 3 猪姿态剧烈变化时的体长测量结果Table 3 Body length results when pig's posture changed significantly |

| 编号 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 |

|---|---|---|---|---|---|---|---|---|---|---|

| 人工测量结果/cm | 102.0 | 100.0 | 111.0 | 120.0 | 108.0 | 115.0 | 115.0 | 116.0 | 127.0 | 129.0 |

| 结果1/cm | 102.5 | 99.1 | 111.1 | 121.1 | 108.4 | 114.1 | 115.0 | 116.3 | 127.4 | 128.9 |

| 结果2/cm | 102.2 | 100.1 | 112.1 | 119.5 | 108.1 | 114.4 | 114.0 | 116.0 | 128.9 | 130.4 |

| 结果3/cm | 101.1 | 98.8 | 109.8 | 119.0 | 108.9 | 113.3 | 113.8 | 116.5 | 128.8 | 128.6 |

| 结果4/cm | 102.1 | 109.0 | 109.4 | 118.4 | 107.2 | 114.7 | 114.6 | 116.2 | 127.6 | 129.4 |

| 结果5/cm | 101.5 | 101.1 | 109.9 | 118.3 | 109.0 | 115.1 | 114.2 | 116.0 | 128.4 | 128.6 |

| 结果6/cm | 100.1 | 101.2 | 109.8 | 119.2 | 108.0 | 115.5 | 115.8 | 116.4 | 128.6 | 130.7 |

| 结果7/cm | 102.0 | 100.8 | 109.8 | 119.3 | 108.5 | 115.0 | 115.6 | 114.3 | 128.7 | 130.8 |

| 结果8/cm | 103.9 | 100.9 | 109.0 | 119.3 | 109.5 | 115.5 | 115.2 | 115.4 | 128.8 | 129.2 |

| 结果9/cm | 102.9 | 100.5 | 109.9 | 119.0 | 108.2 | 115.2 | 115.6 | 117.4 | 128.2 | 130.0 |

| 结果10/cm | 102.8 | 99.4 | 111.0 | 119.4 | 108.8 | 114.9 | 115.9 | 116.9 | 128.6 | 129.4 |

表 4 猪姿态剧烈变化时的腹宽测量结果Table 4 Abdomen width results when posture changed significantly of pig |

| 编号 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 |

|---|---|---|---|---|---|---|---|---|---|---|

| 人工测量结果/cm | 25.0 | 25.0 | 27.0 | 30.0 | 27.0 | 38.0 | 29.0 | 27.0 | 30.0 | 35.0 |

| 结果1/cm | 25.1 | 24.5 | 27.8 | 30.1 | 26.5 | 38.1 | 29.5 | 27.2 | 31.0 | 35.5 |

| 结果2/cm | 25.1 | 24.4 | 27.5 | 29.4 | 26.4 | 38.0 | 29.4 | 27.3 | 30.8 | 35.1 |

| 结果3/cm | 25.2 | 24.4 | 27.4 | 30.2 | 26.6 | 38.0 | 29.4 | 27.1 | 30.8 | 35.1 |

| 结果4/cm | 25.3 | 24.3 | 27.6 | 30.1 | 26.5 | 38.0 | 29.4 | 27.2 | 30.7 | 35.5 |

| 结果5/cm | 25.5 | 24.5 | 27.8 | 30.1 | 26.2 | 37.8 | 29.5 | 27.0 | 31.1 | 36.3 |

| 结果6/cm | 24.9 | 24.1 | 27.8 | 29.9 | 26.5 | 37.8 | 29.0 | 27.2 | 30.8 | 35.5 |

| 结果7/cm | 24.9 | 24.5 | 27.4 | 30.0 | 26.1 | 37.7 | 29.0 | 27.2 | 30.5 | 35.7 |

| 结果8/cm | 24.5 | 24.6 | 27.2 | 30.4 | 26.5 | 38.1 | 29.3 | 27.2 | 30.6 | 34.2 |

| 结果9/cm | 25.0 | 24.6 | 27.2 | 30.1 | 26.5 | 38.2 | 29.6 | 27.3 | 30.8 | 35.5 |

| 结果10/cm | 24.5 | 24.7 | 27.2 | 30.0 | 26.4 | 38.1 | 29.2 | 27.3 | 30.7 | 35.5 |